Kubernetes 博客

- Kubernetes v1.32:内存管理器进阶至 GA

- Kubernetes v1.32 预览

- 关于日本的 Kubernetes 上游培训的特别报道

- 公布 2024 年指导委员会选举结果

- SIG Scheduling 访谈

- Kubernetes v1.31:kubeadm v1beta4

- Kubernetes 1.31:kubectl debug 中的自定义模板化配置特性已进入 Beta 阶段

- Kubernetes 1.31:细粒度的 SupplementalGroups 控制

- Kubernetes v1.31:全新的 Kubernetes CPUManager 静态策略:跨核分发 CPU

- Kubernetes 1.31: 节点 Cgroup 驱动程序的自动配置 (beta)

- Kubernetes 1.31:流式传输从 SPDY 转换为 WebSocket

- Kubernetes 1.31:针对 Job 的 Pod 失效策略进阶至 GA

- Kubernetes 1.31:podAffinity 中的 matchLabelKeys 进阶至 Beta

- Kubernetes 1.31:防止无序删除时 PersistentVolume 泄漏

- Kubernetes 1.31:基于 OCI 工件的只读卷 (Alpha)

- Kubernetes 1.31:通过 VolumeAttributesClass 修改卷进阶至 Beta

- Kubernetes 1.31:对 cgroup v1 的支持转为维护模式

- Kubernetes v1.31: Elli

- 向 Client-Go 引入特性门控:增强灵活性和控制力

- 聚焦 SIG API Machinery

- Kubernetes v1.31 中的移除和主要变更

- Kubernetes 的十年

- 完成 Kubernetes 史上最大规模迁移

- Gateway API v1.1:服务网格、GRPCRoute 和更多变化

- Kubernetes 1.30:防止未经授权的卷模式转换进阶到 GA

- Kubernetes 1.30:结构化身份认证配置进阶至 Beta

- Kubernetes 1.30:验证准入策略 ValidatingAdmissionPolicy 正式发布

- Kubernetes 1.30:只读卷挂载终于可以真正实现只读了

- Kubernetes 1.30:对 Pod 使用用户命名空间的支持进阶至 Beta

- SIG Architecture 特别报道:代码组织

- Kubernetes v1.30 初探

- 走进 Kubernetes 读书会(Book Club)

- 镜像文件系统:配置 Kubernetes 将容器存储在独立的文件系统上

- Kubernetes 1.29 中的上下文日志生成:更好的故障排除和增强的日志记录

- Kubernetes 1.29: 解耦污点管理器与节点生命周期控制器

- Kubernetes 1.29:PodReadyToStartContainers 状况进阶至 Beta

- Kubernetes 1.29 新的 Alpha 特性:Service 的负载均衡器 IP 模式

- Kubernetes 1.29:修改卷之 VolumeAttributesClass

- 聚焦 SIG Testing

- Kubernetes 1.29 中的移除、弃用和主要变更

- 介绍 SIG etcd

- Gateway API v1.0:正式发布(GA)

- Kubernetes 中 PersistentVolume 的最后阶段转换时间

- 2023 中国 Kubernetes 贡献者峰会简要回顾

- CRI-O 正迁移至 pkgs.k8s.io

- 聚焦 SIG Architecture: Conformance

- 公布 2023 年指导委员会选举结果

- kubeadm 七周年生日快乐!

- kubeadm:使用 etcd Learner 安全地接入控制平面节点

- 用户命名空间:对运行有状态 Pod 的支持进入 Alpha 阶段!

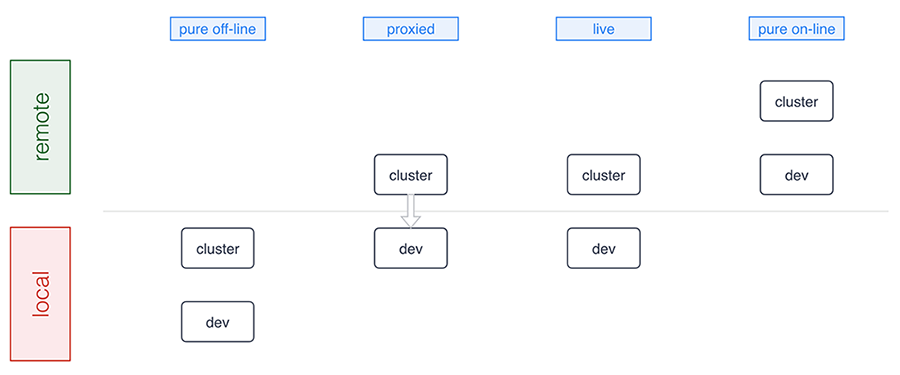

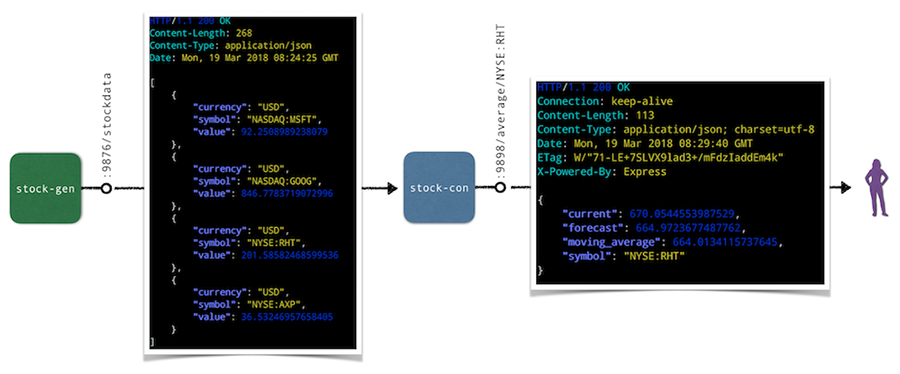

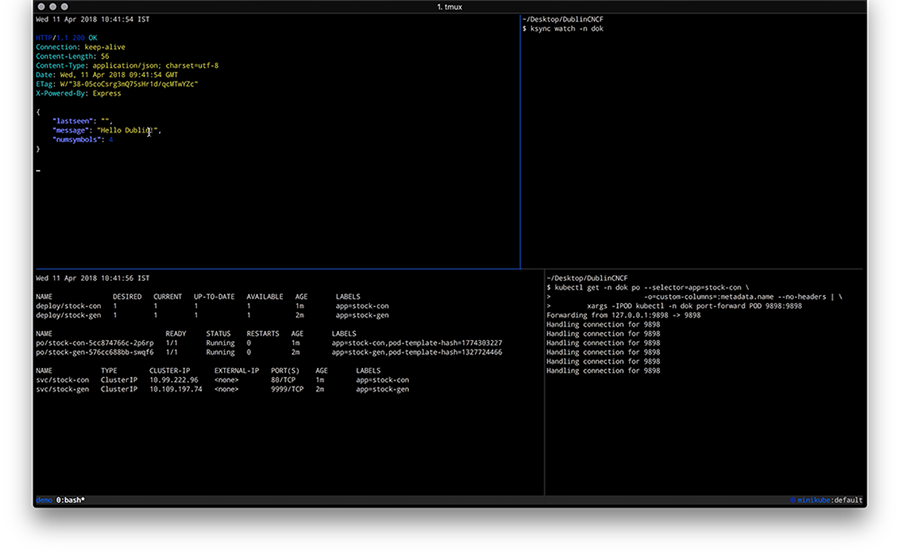

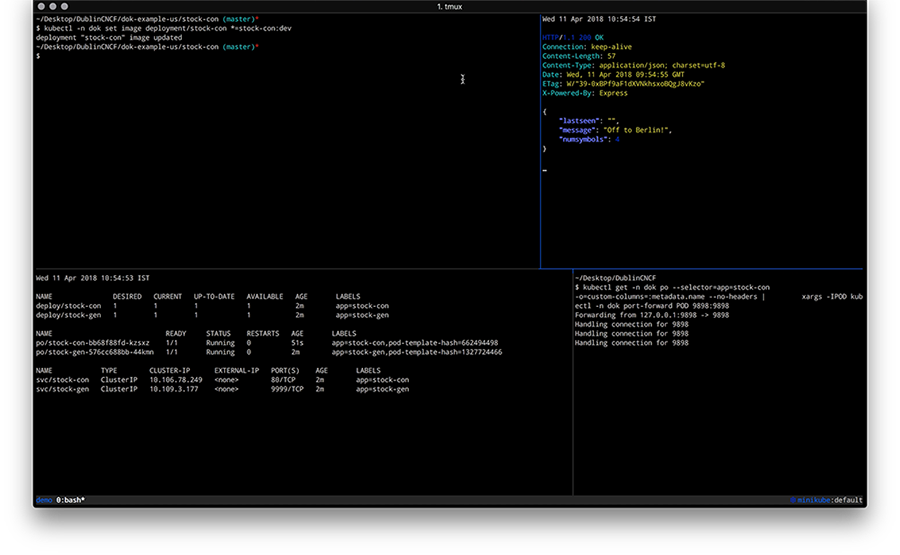

- 比较本地 Kubernetes 开发工具:Telepresence、Gefyra 和 mirrord

- Kubernetes 旧版软件包仓库将于 2023 年 9 月 13 日被冻结

- Gateway API v0.8.0:引入服务网格支持

- Kubernetes 1.28:用于改进集群安全升级的新(Alpha)机制

- Kubernetes v1.28:介绍原生边车容器

- Kubernetes 1.28:在 Linux 上使用交换内存的 Beta 支持

- Kubernetes 1.28:节点 podresources API 正式发布

- Kubernetes 1.28:Job 失效处理的改进

- Kubernetes v1.28:可追溯的默认 StorageClass 进阶至 GA

- Kubernetes 1.28: 节点非体面关闭进入 GA 阶段(正式发布)

- pkgs.k8s.io:介绍 Kubernetes 社区自有的包仓库

- 聚焦 SIG CLI

- Kubernetes 机密:使用机密虚拟机和安全区来增强你的集群安全性

- 在 CRI 运行时内验证容器镜像签名

- dl.k8s.io 采用内容分发网络(CDN)

- 使用 OCI 工件为 seccomp、SELinux 和 AppArmor 分发安全配置文件

- 在边缘上玩转 seccomp 配置文件

- Kubernetes 1.27: KMS V2 进入 Beta 阶段

- Kubernetes 1.27:关于加快 Pod 启动的进展

- Kubernetes 1.27: 原地调整 Pod 资源 (alpha)

- Kubernetes 1.27:为 NodePort Service 分配端口时避免冲突

- Kubernetes 1.27:kubectl apply 裁剪更安全、更高效

- Kubernetes 1.27:介绍用于磁盘卷组快照的新 API

- Kubernetes 1.27:内存资源的服务质量(QoS)Alpha

- Kubernetes 1.27: StatefulSet PVC 自动删除(beta)

- Kubernetes 1.27:HorizontalPodAutoscaler ContainerResource 类型指标进阶至 Beta

- Kubernetes 1.27: StatefulSet 启动序号简化了迁移

- 官方自动刷新 CVE 订阅源的更新

- Kubernetes 1.27:服务器端字段校验和 OpenAPI V3 进阶至 GA

- Kubernetes 1.27: 使用 Kubelet API 查询节点日志

- Kubernetes 1.27:持久卷的单个 Pod 访问模式升级到 Beta

- Kubernetes 1.27:高效的 SELinux 卷重新标记(Beta 版)

- Kubernetes 1.27:更多精细粒度的 Pod 拓扑分布策略进阶至 Beta

- “使用更新后的 Go 版本保持 Kubernetes 安全”

- Kubernetes 验证准入策略:一个真实示例

- Kubernetes 在 v1.27 中移除的特性和主要变更

- k8s.gcr.io 重定向到 registry.k8s.io - 用户须知

- Kubernetes 的容器检查点分析

- 介绍 KWOK(Kubernetes WithOut Kubelet,没有 Kubelet 的 Kubernetes)

- 免费的 Katacoda Kubernetes 教程即将关闭

- k8s.gcr.io 镜像仓库将从 2023 年 4 月 3 日起被冻结

- 聚光灯下的 SIG Instrumentation

- 考虑所有微服务的脆弱性并对其行为进行监控

- 使用 PriorityClass 确保你的关键任务 Pod 免遭驱逐

- Kubernetes 1.26:PodDisruptionBudget 守护的不健康 Pod 所用的驱逐策略

- Kubernetes v1.26:可追溯的默认 StorageClass

- Kubernetes v1.26:对跨名字空间存储数据源的 Alpha 支持

- Kubernetes v1.26:Kubernetes 中流量工程的进步

- Kubernetes v1.26:CPUManager 正式发布

- Kubernetes 1.26:Pod 调度就绪态

- Kubernetes 1.26: 支持在挂载时将 Pod fsGroup 传递给 CSI 驱动程序

- Kubernetes 1.26:设备管理器正式发布

- Kubernetes 1.26: 节点非体面关闭进入 Beta 阶段

- Kubernetes 1.26: 动态资源分配 Alpha API

- Kubernetes 1.26: 我们现在正在对二进制发布工件进行签名!

- Kubernetes 的取证容器检查点

- Kubernetes 1.26 中的移除、弃用和主要变更

- Kueue 介绍

- “Kubernetes 1.25:对使用用户名字空间运行 Pod 提供 Alpha 支持”

- Kubernetes 1.25:应用滚动上线所用的两个特性进入稳定阶段

- Kubernetes 1.25:Pod 新增 PodHasNetwork 状况

- 宣布自动刷新官方 Kubernetes CVE 订阅源

- Kubernetes 的 iptables 链不是 API

- COSI 简介:使用 Kubernetes API 管理对象存储

- Kubernetes 1.25: cgroup v2 升级到 GA

- Kubernetes 1.25:CSI 内联存储卷正式发布

- PodSecurityPolicy:历史背景

- Kubernetes v1.25: Combiner

- 聚焦 SIG Storage

- 认识我们的贡献者 - 亚太地区(中国地区)

- 逐个 KEP 地增强 Kubernetes

- Kubernetes 1.25 的移除说明和主要变更

- 聚光灯下的 SIG Docs

- Kubernetes Gateway API 进入 Beta 阶段

- 2021 年度总结报告

- Kubernetes 1.24: StatefulSet 的最大不可用副本数

- Kubernetes 1.24 中的上下文日志记录

- Kubernetes 1.24: 避免为 Services 分配 IP 地址时发生冲突

- Kubernetes 1.24: 节点非体面关闭特性进入 Alpha 阶段

- Kubernetes 1.24: 防止未经授权的卷模式转换

- Kubernetes 1.24: 卷填充器功能进入 Beta 阶段

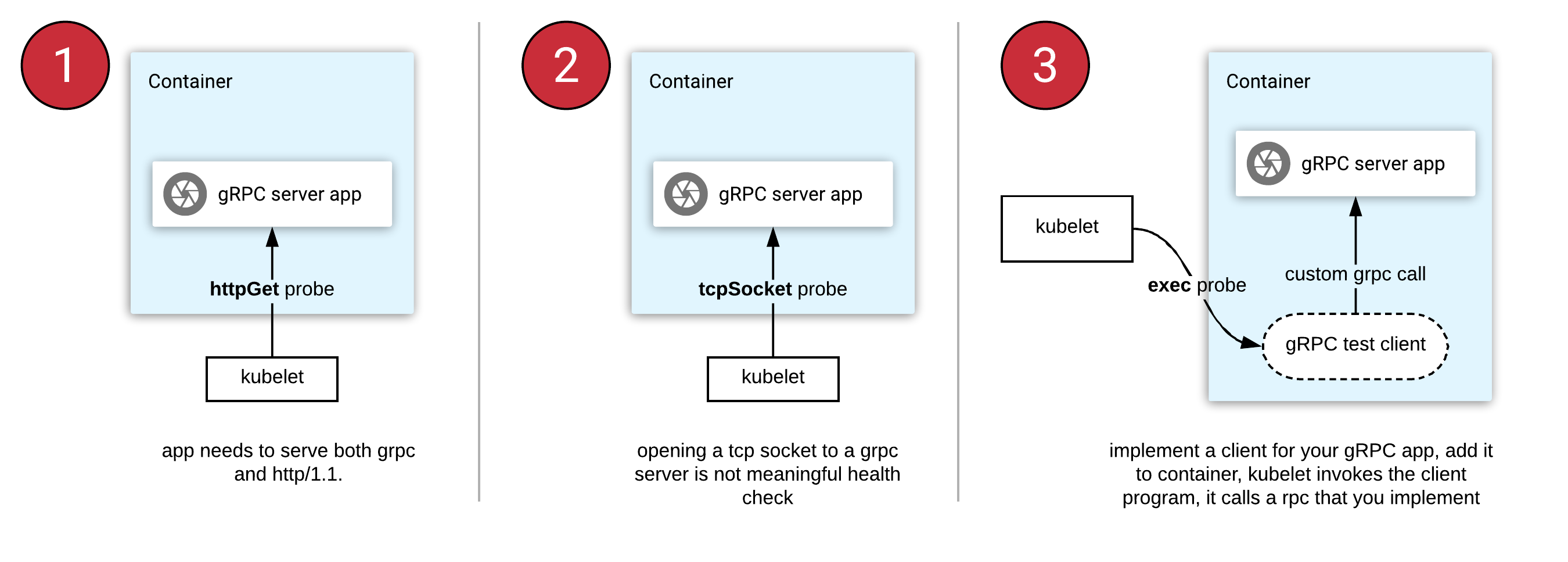

- Kubernetes 1.24:gRPC 容器探针功能进入 Beta 阶段

- Kubernetes 1.24 版本中存储容量跟踪特性进入 GA 阶段

- Kubernetes 1.24:卷扩充现在成为稳定功能

- Dockershim:历史背景

- Kubernetes 1.24: 观星者

- Frontiers, fsGroups and frogs: Kubernetes 1.23 发布采访

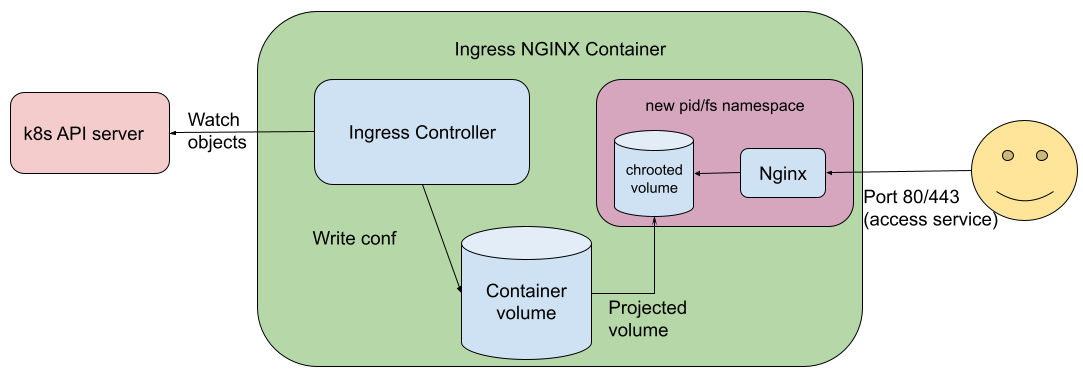

- 在 Ingress-NGINX v1.2.0 中提高安全标准

- Kubernetes 1.24 中的移除和弃用

- 你的集群准备好使用 v1.24 版本了吗?

- 认识我们的贡献者 - 亚太地区(澳大利亚-新西兰地区)

- 更新:移除 Dockershim 的常见问题

- SIG Node CI 子项目庆祝测试改进两周年

- 关注 SIG Multicluster

- 确保准入控制器的安全

- 认识我们的贡献者 - 亚太地区(印度地区)

- Kubernetes 即将移除 Dockershim:承诺和下一步

- Security Profiles Operator v0.4.0 中的新功能

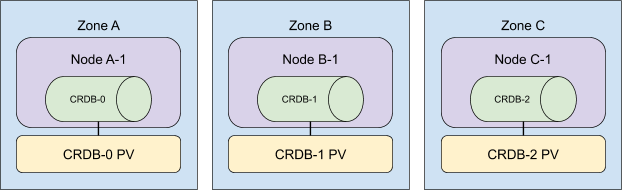

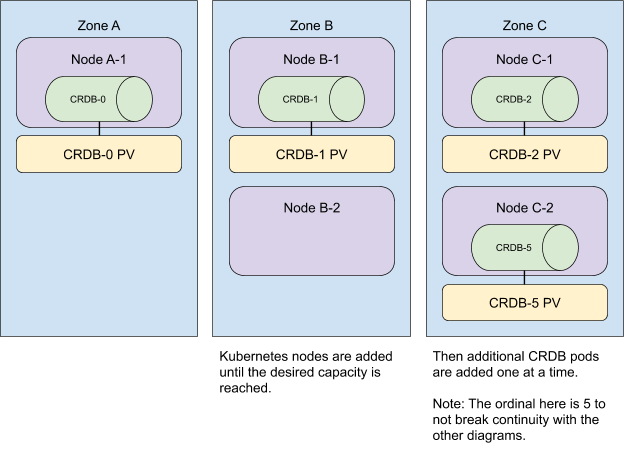

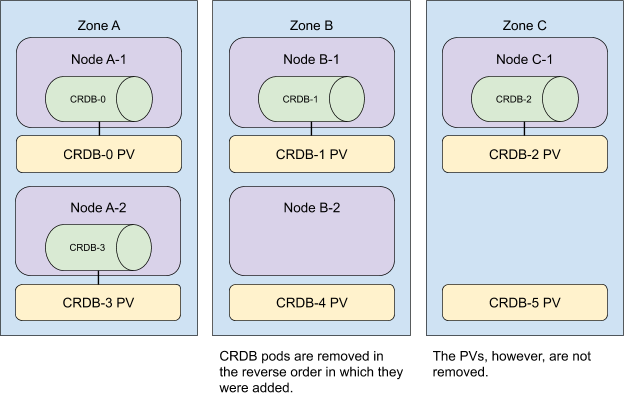

- Kubernetes 1.23: StatefulSet PVC 自动删除 (alpha)

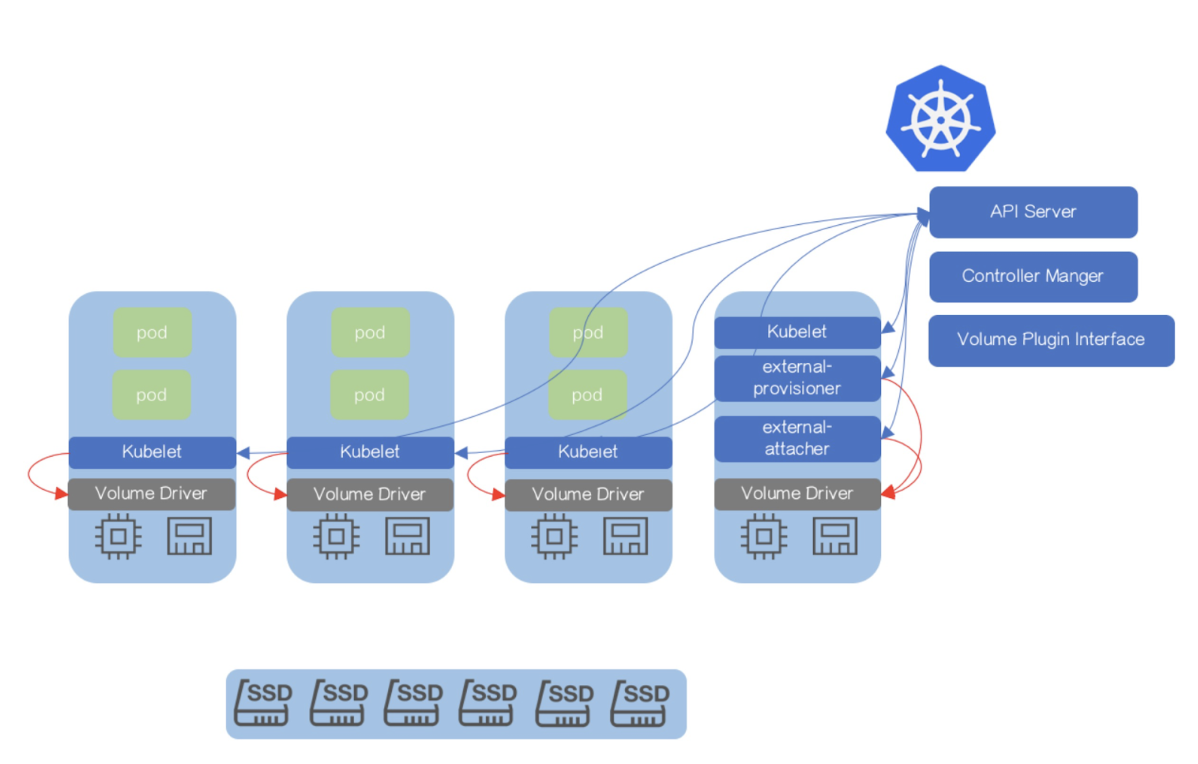

- Kubernetes 1.23:树内存储向 CSI 卷迁移工作的进展更新

- Kubernetes 1.23:IPv4/IPv6 双协议栈网络达到 GA

- 公布 2021 年指导委员会选举结果

- 关注 SIG Node

- 更新 NGINX-Ingress 以使用稳定的 Ingress API

- 聚焦 SIG Usability

- 卷健康监控的 Alpha 更新

- 弃用 PodSecurityPolicy:过去、现在、未来

- 一个编排高可用应用的 Kubernetes 自定义调度器

- Kubernetes 1.20:CSI 驱动程序中的 Pod 身份假扮和短时卷

- Kubernetes 1.20: 最新版本

- 别慌: Kubernetes 和 Docker

- 弃用 Dockershim 的常见问题

- 为开发指南做贡献

- 结构化日志介绍

- 警告: 有用的预警

- Docsy 带来更好的 Docs UX

- Kubernetes 1.18: Fit & Finish

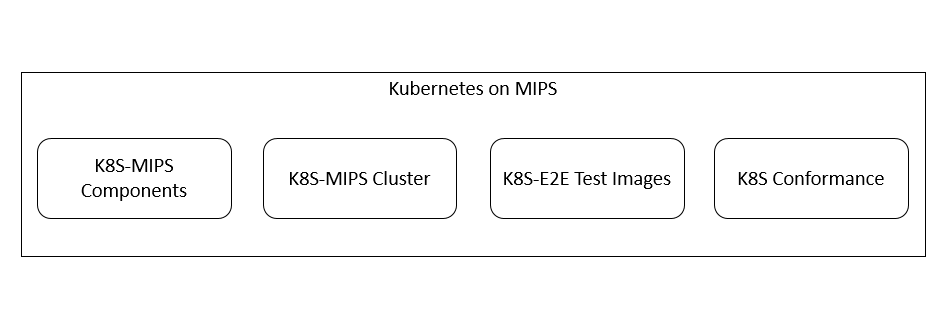

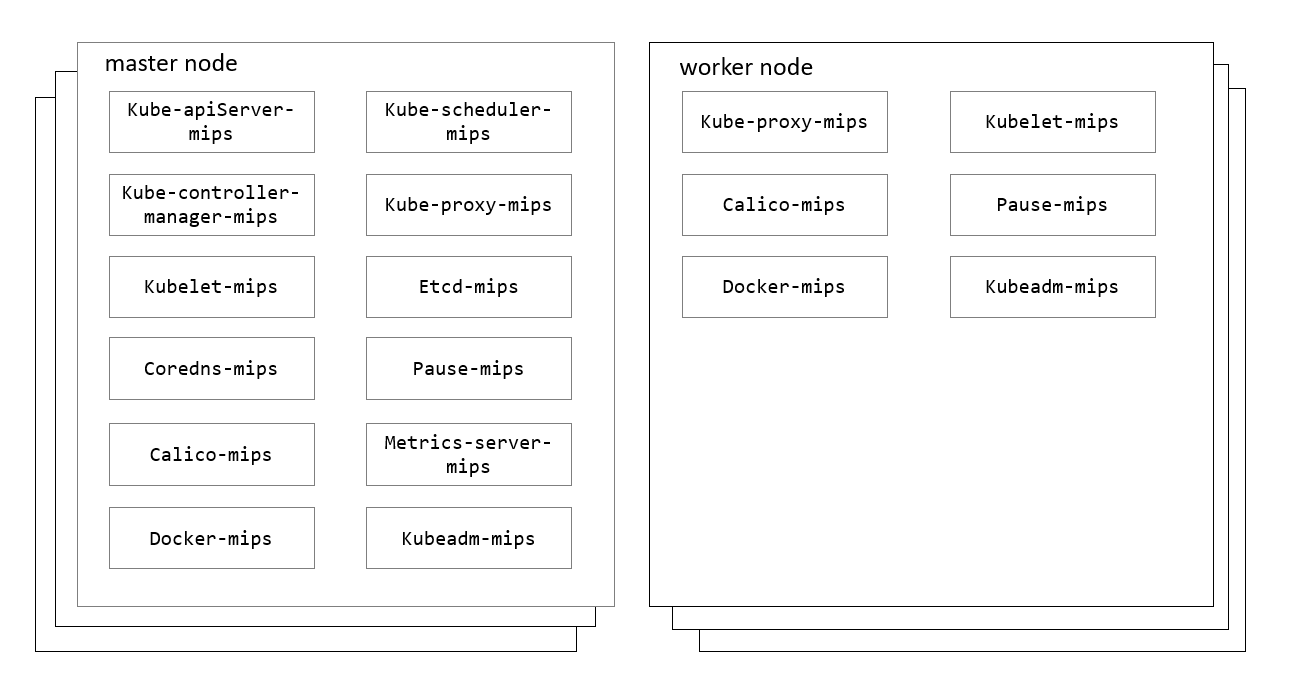

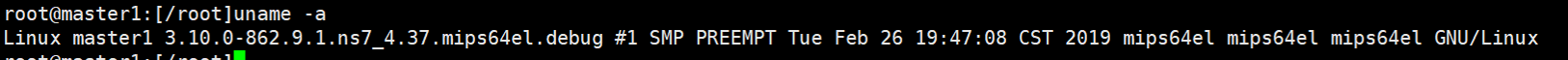

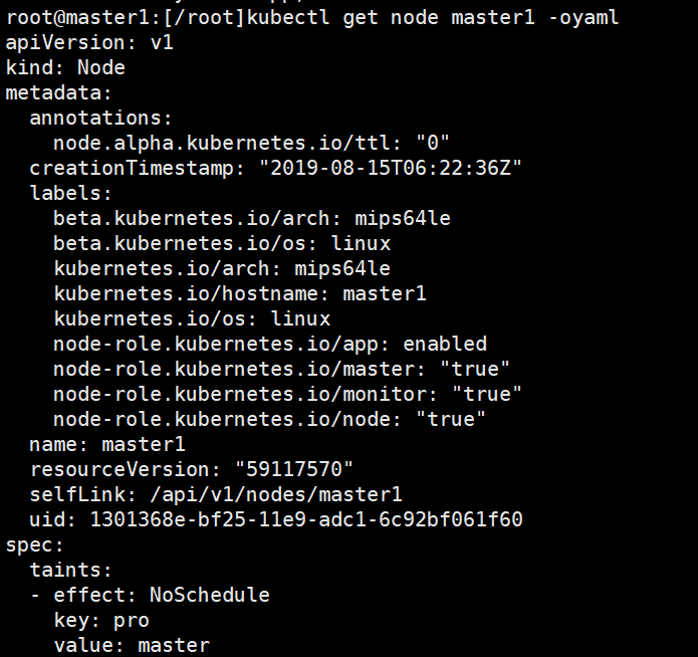

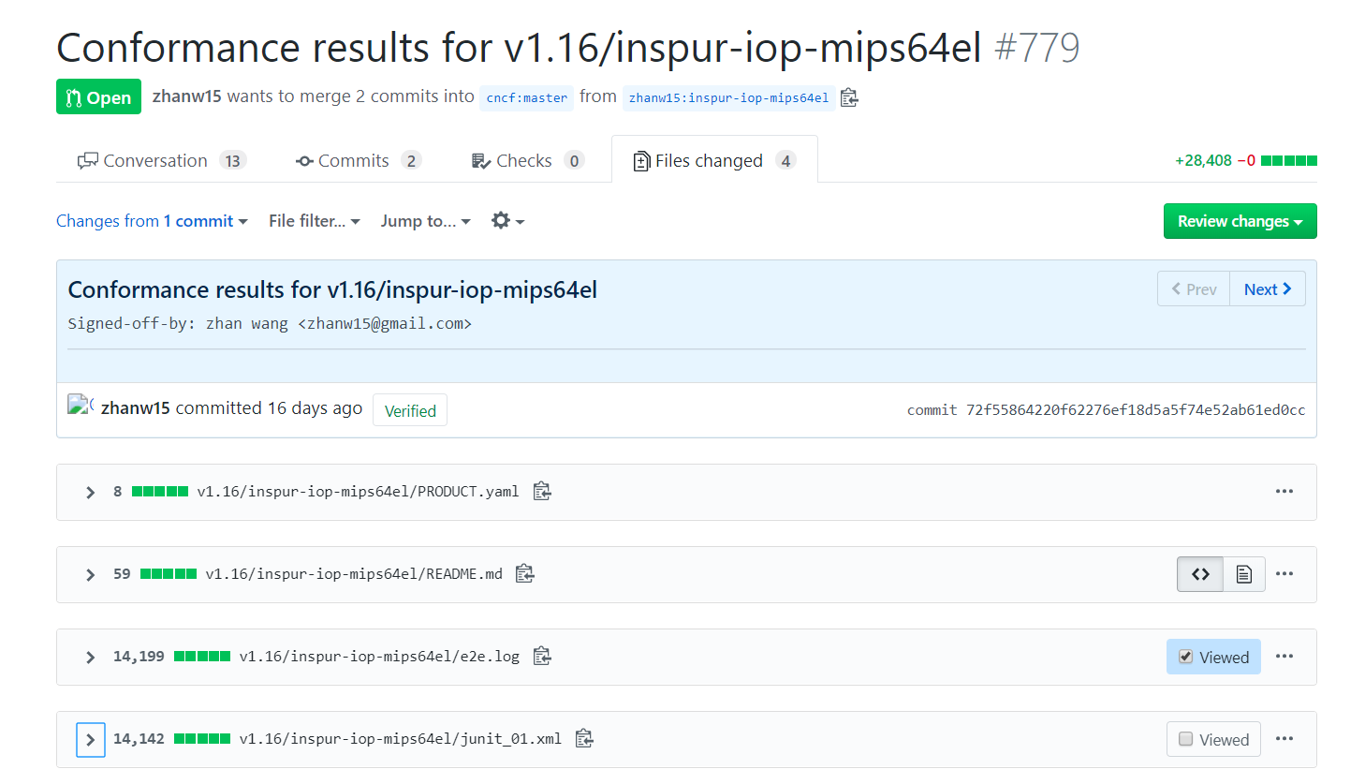

- 基于 MIPS 架构的 Kubernetes 方案

- Kubernetes 1.17:稳定

- 使用 Java 开发一个 Kubernetes controller

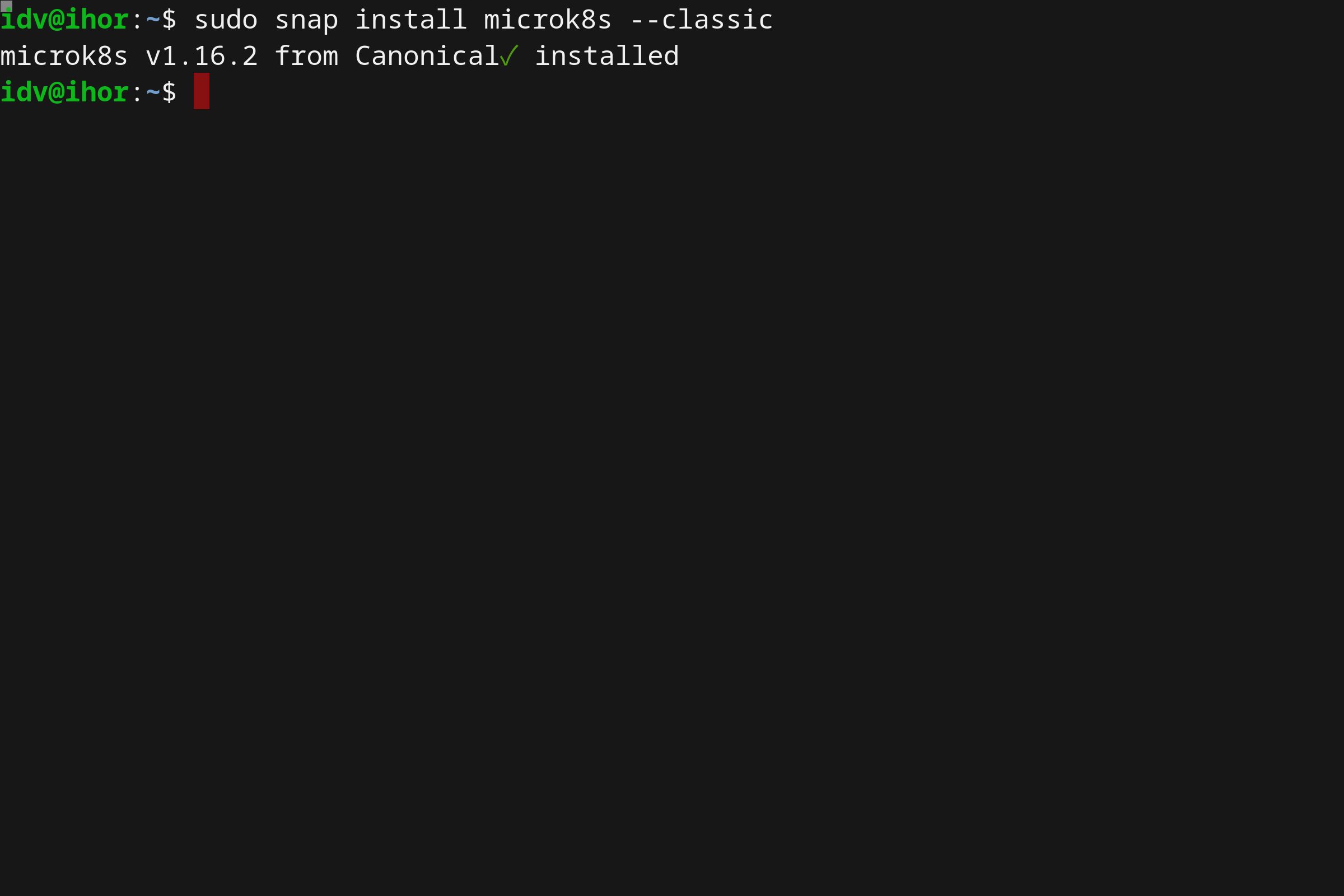

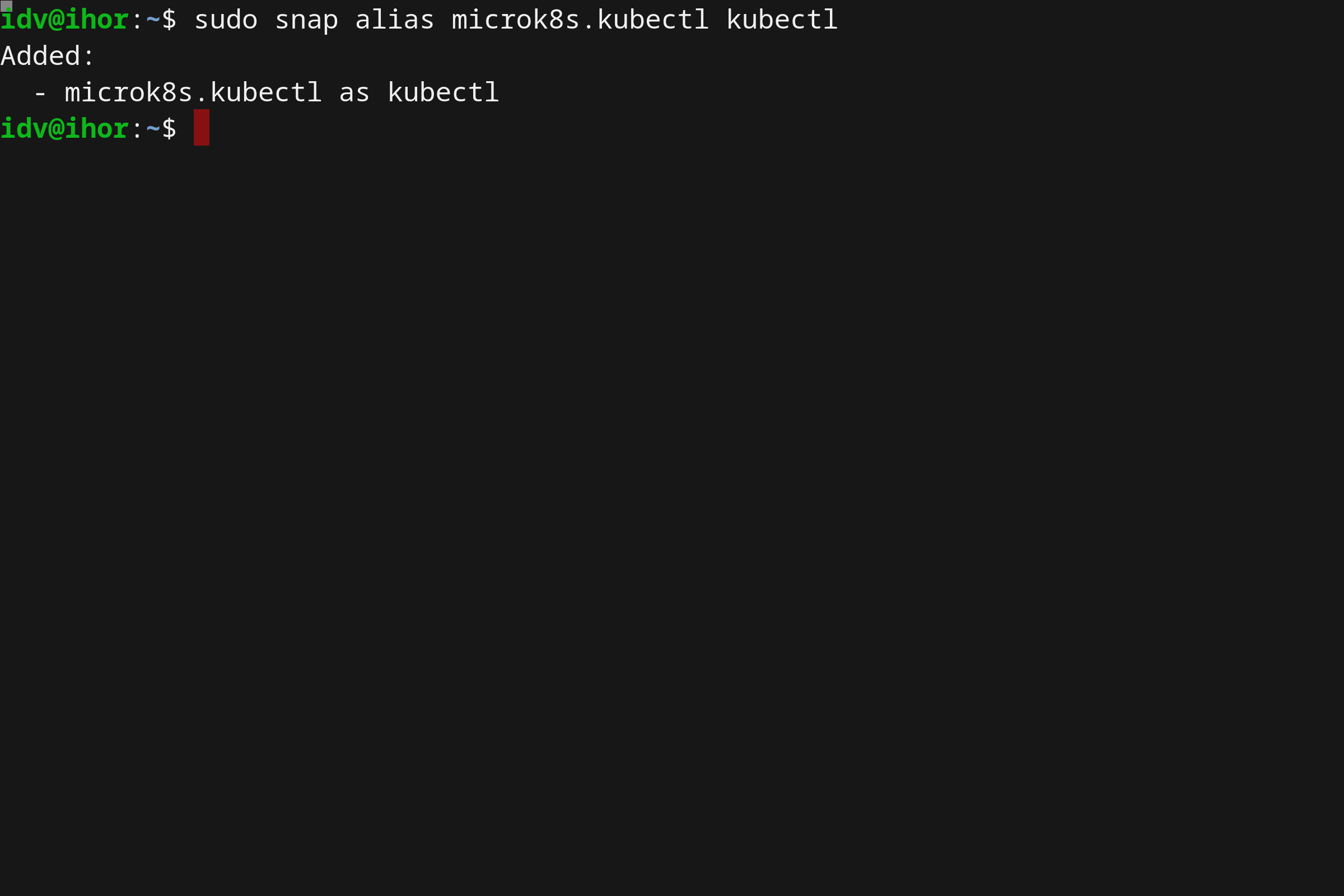

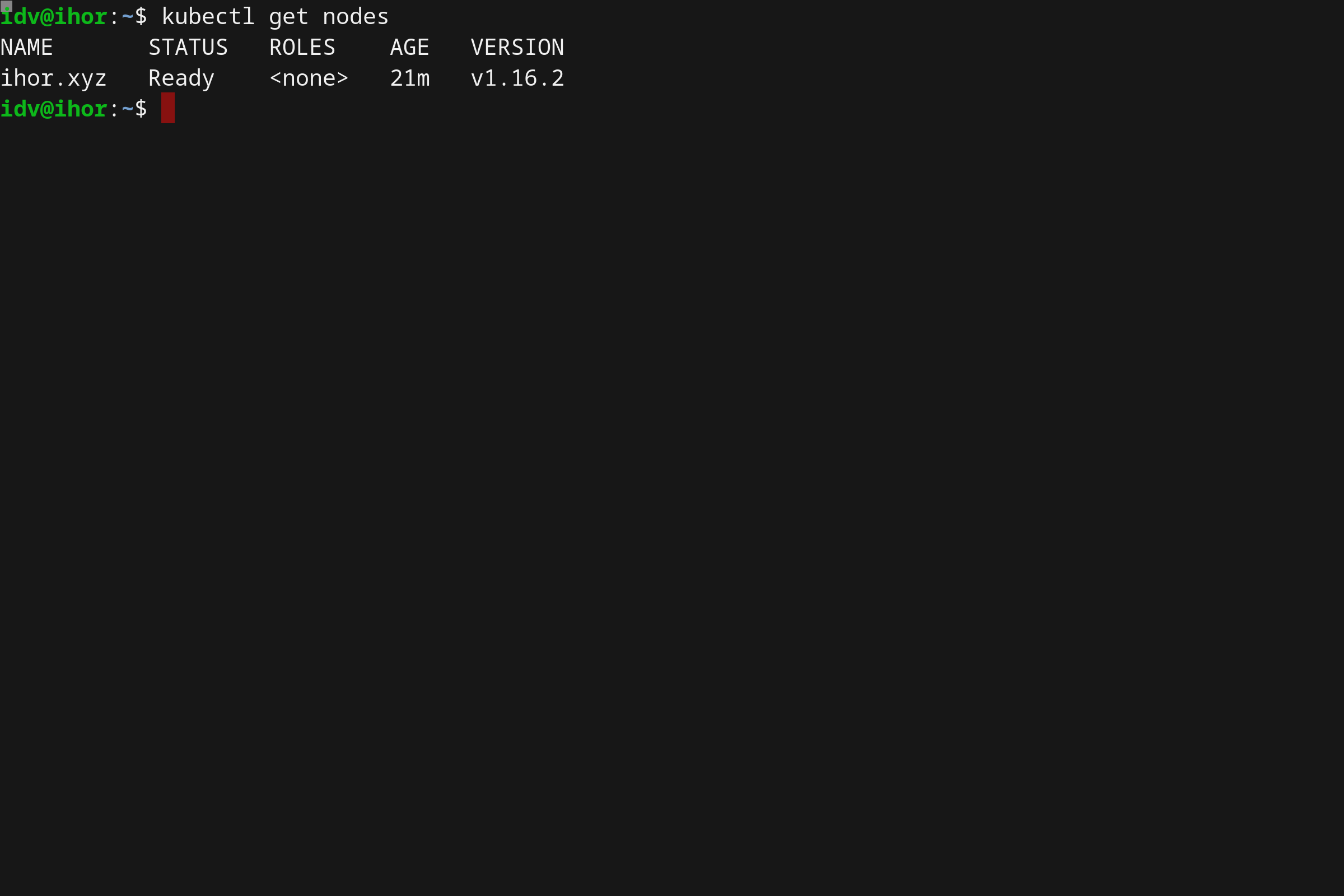

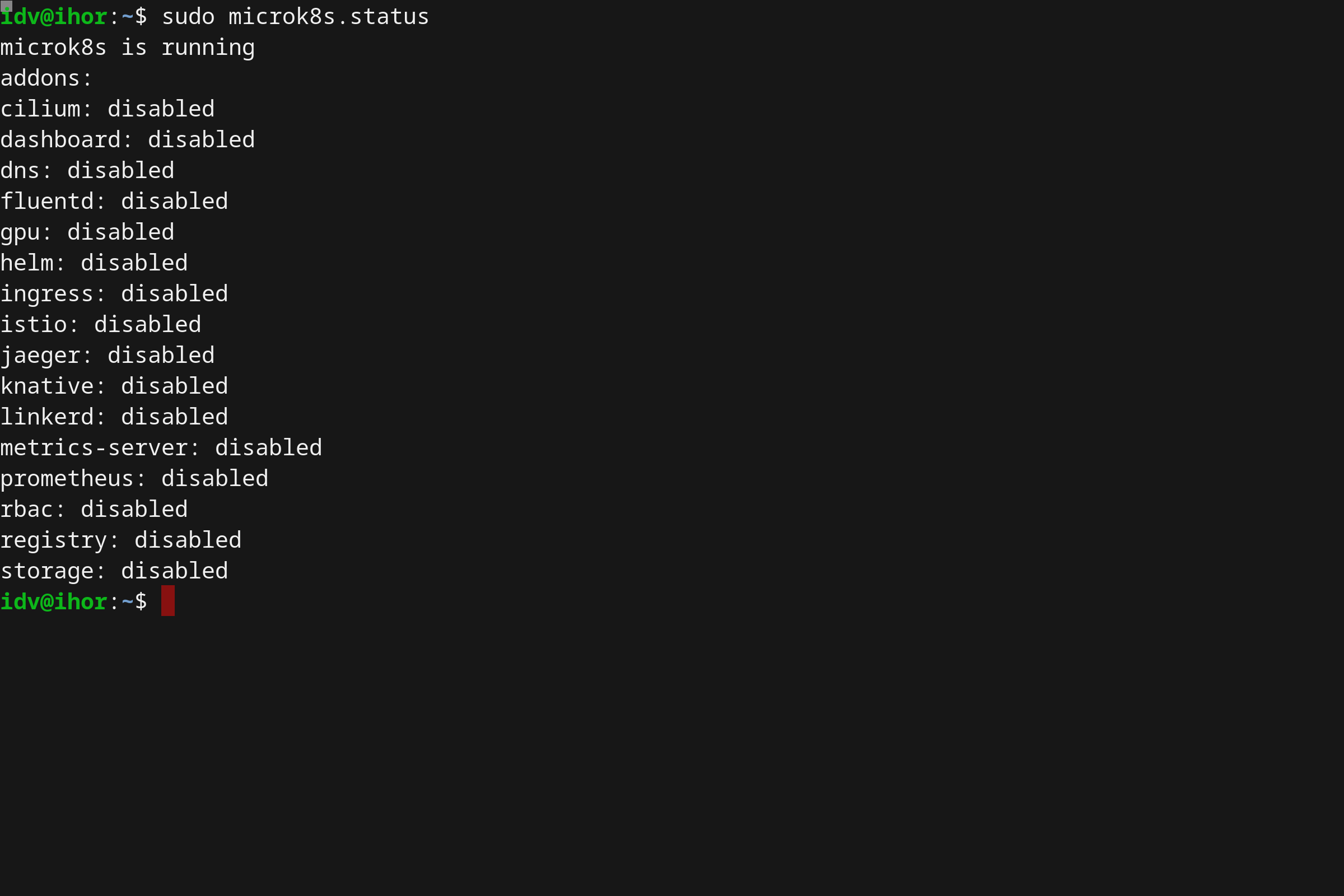

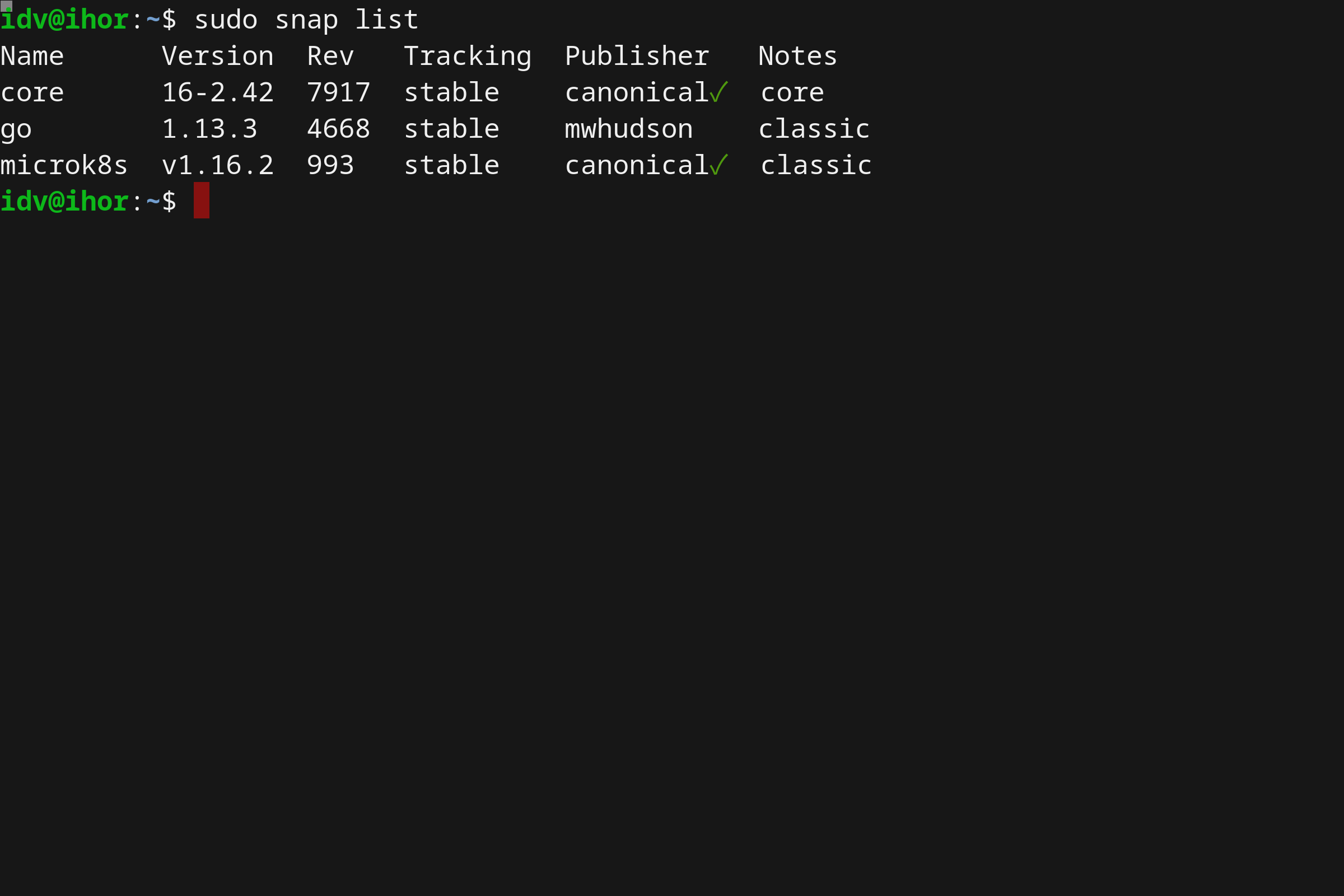

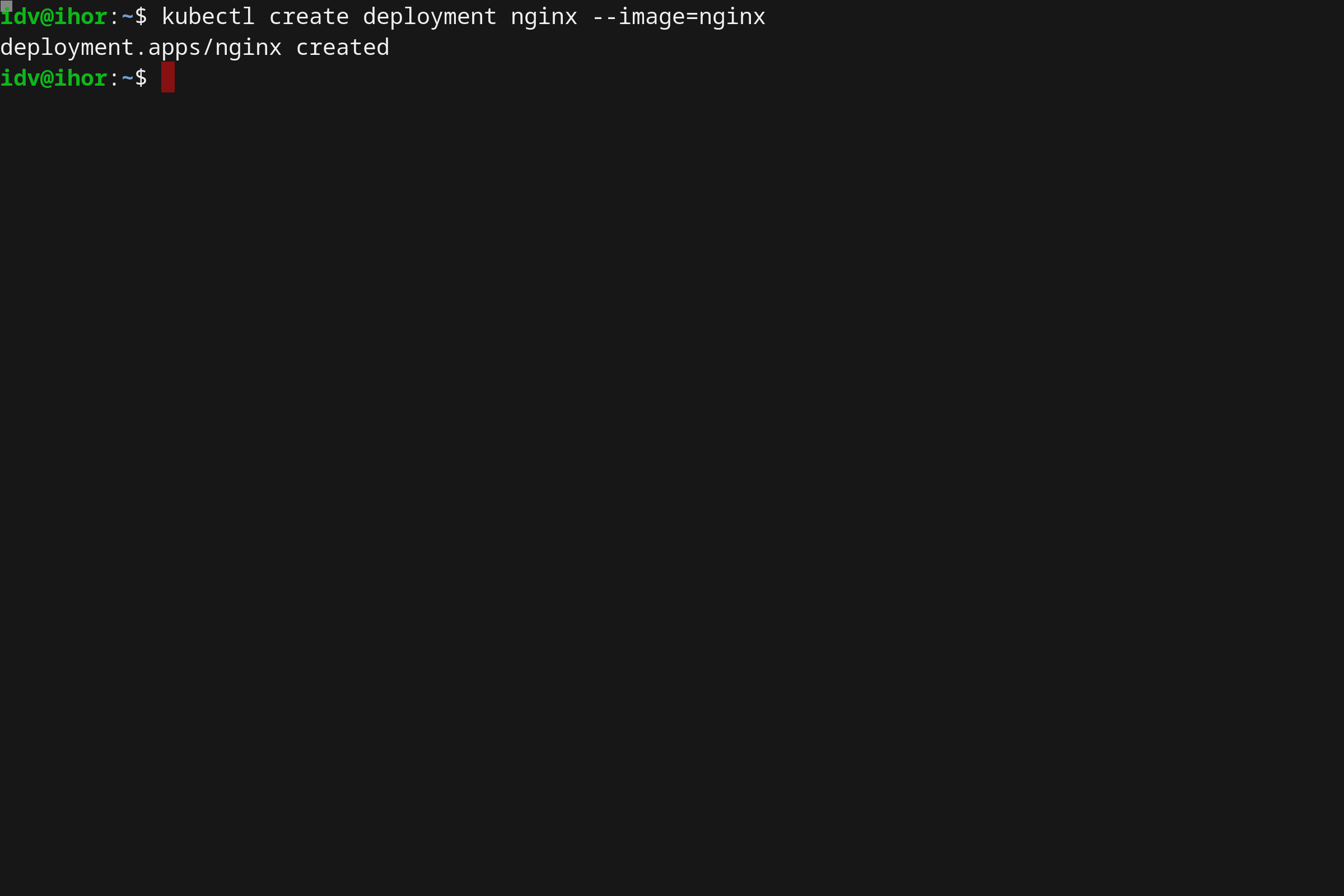

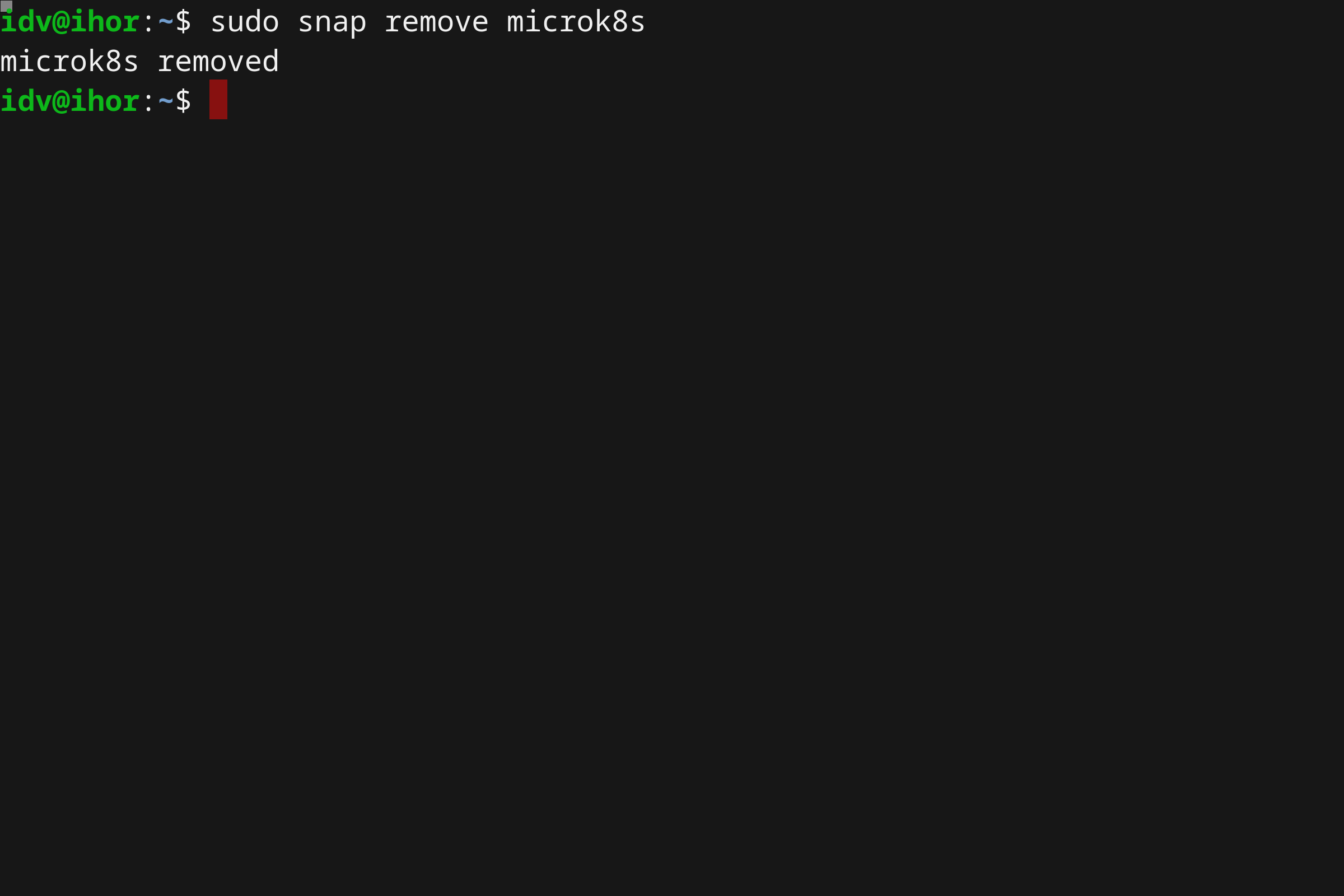

- 使用 Microk8s 在 Linux 上本地运行 Kubernetes

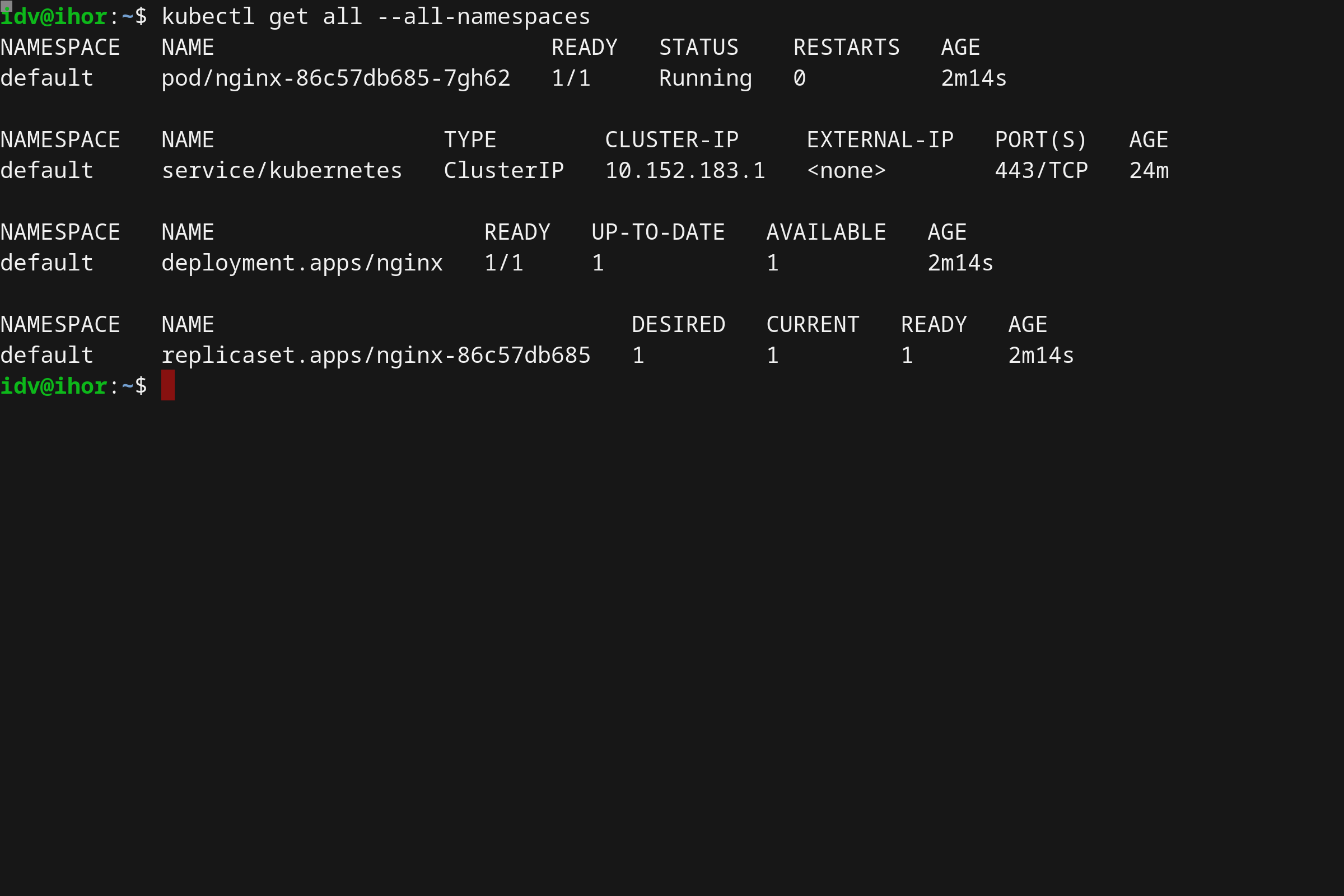

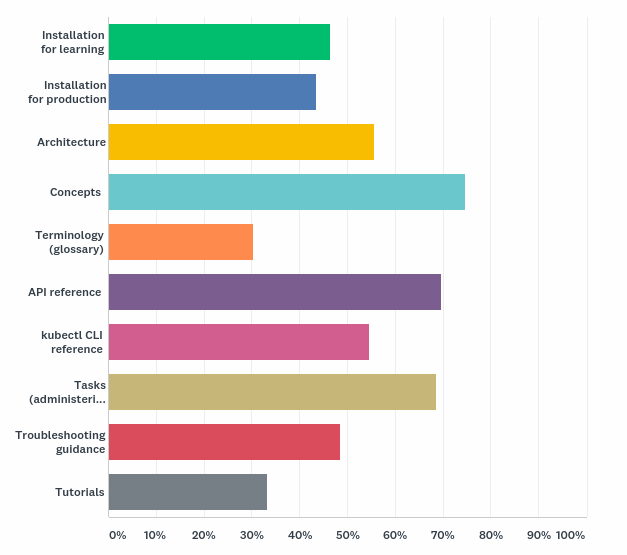

- Kubernetes 文档最终用户调研

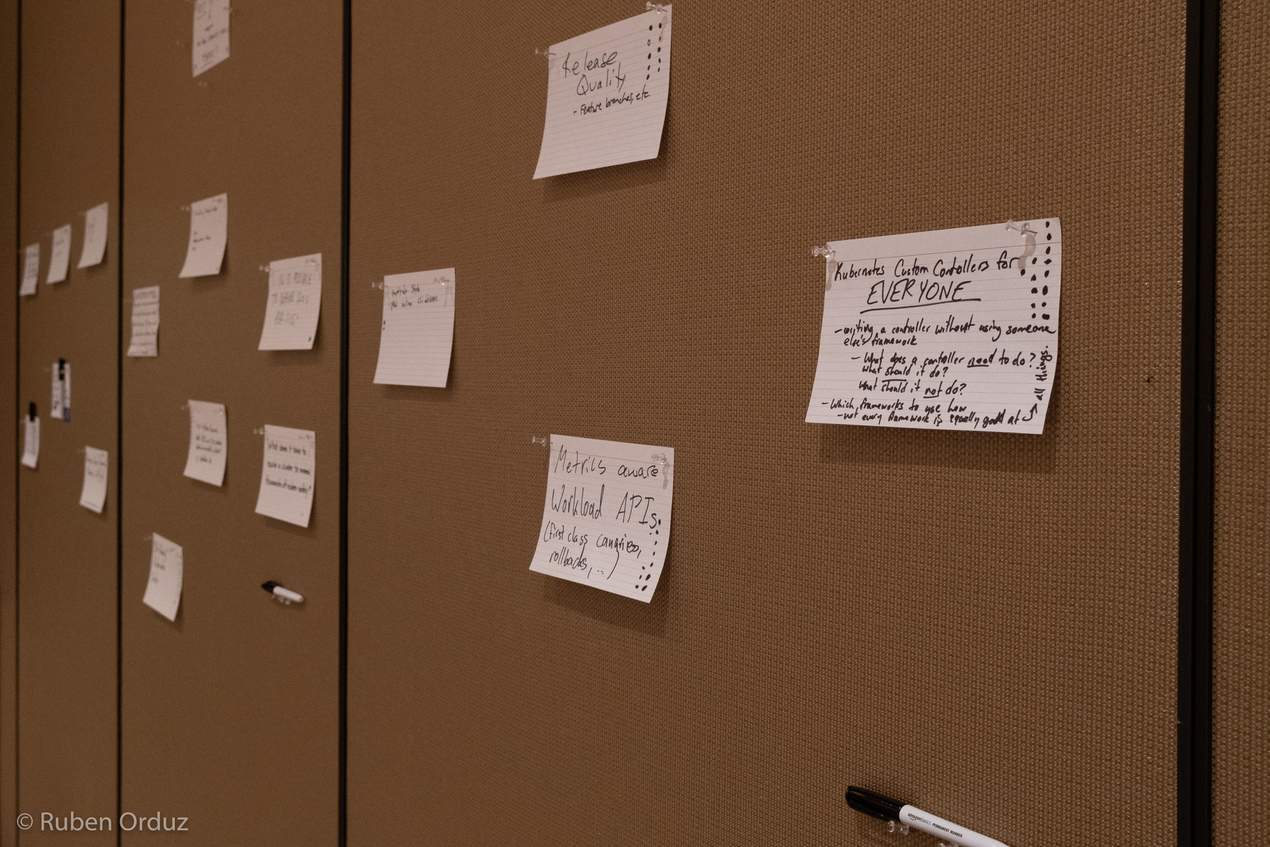

- 圣迭戈贡献者峰会日程公布!

- 2019 指导委员会选举结果

- San Diego 贡献者峰会开放注册!

- 机器可以完成这项工作,一个关于 kubernetes 测试、CI 和自动化贡献者体验的故事

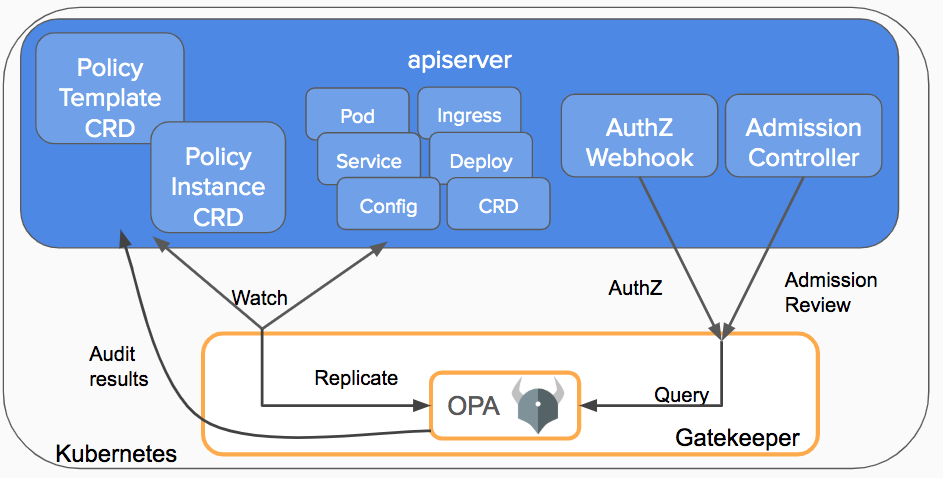

- OPA Gatekeeper:Kubernetes 的策略和管理

- 欢迎参加在上海举行的贡献者峰会

- 壮大我们的贡献者研讨会

- 如何参与 Kubernetes 文档的本地化工作

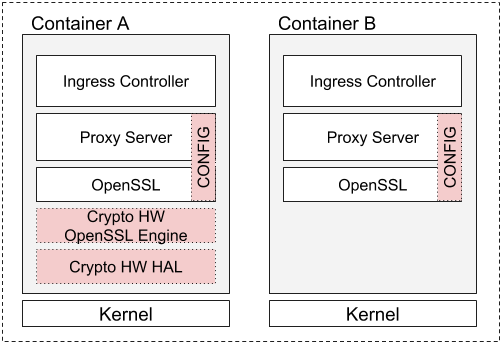

- 使用 Kubernetes 设备插件和 RuntimeClass 在 Ingress 控制器中实现硬件加速 SSL/TLS 终止

- Kubernetes 1.14 稳定性改进中的进程ID限制

- Raw Block Volume 支持进入 Beta

- 新贡献者工作坊上海站

- Kubernetes 文档更新,国际版

- Kubernetes 2018 年北美贡献者峰会

- 2018 年督导委员会选举结果

- Kubernetes 中的拓扑感知数据卷供应

- Kubernetes v1.12: RuntimeClass 简介

- KubeDirector:在 Kubernetes 上运行复杂状态应用程序的简单方法

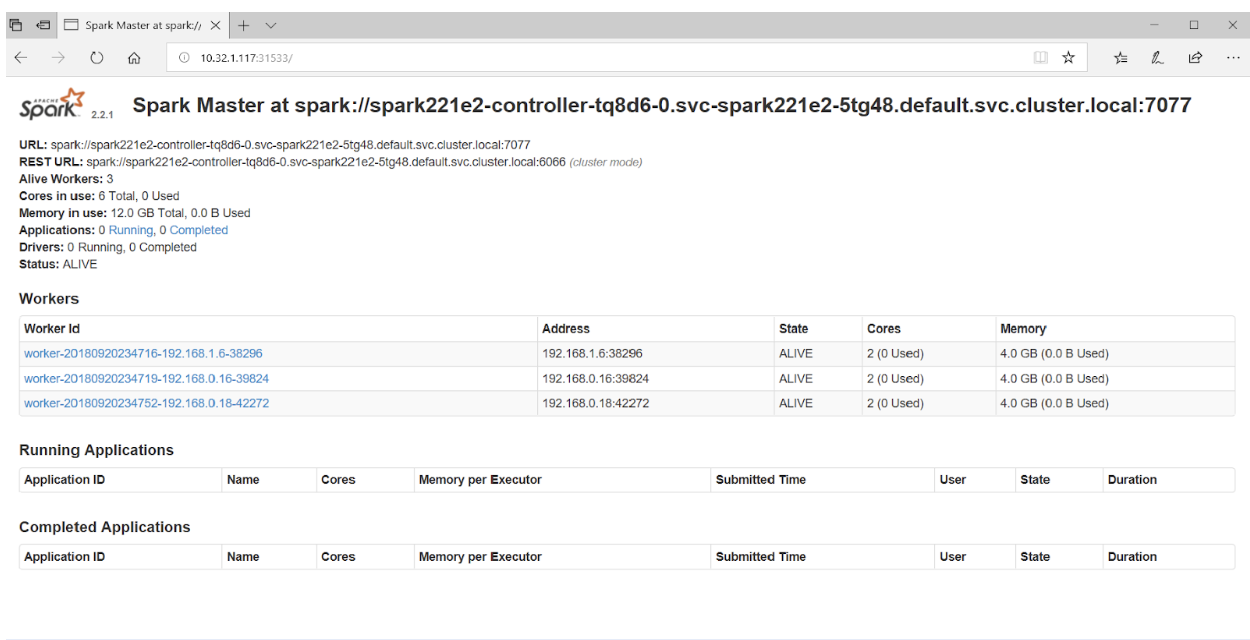

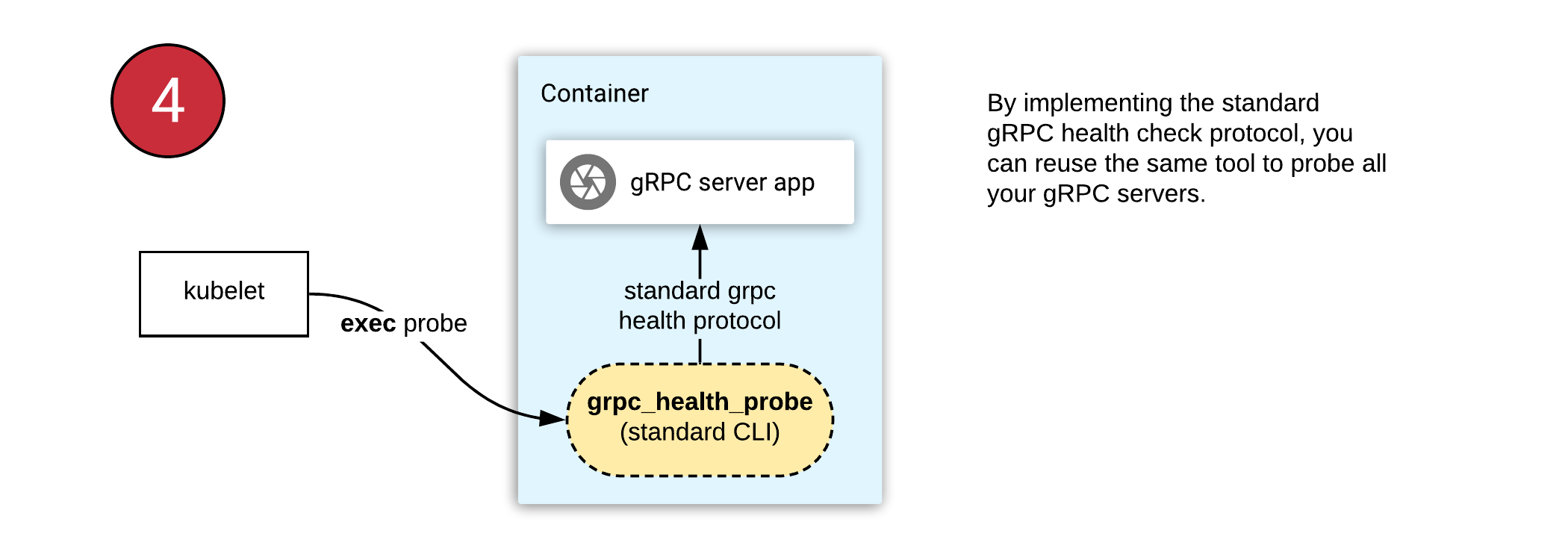

- 在 Kubernetes 上对 gRPC 服务器进行健康检查

- 使用 CSI 和 Kubernetes 实现卷的动态扩容

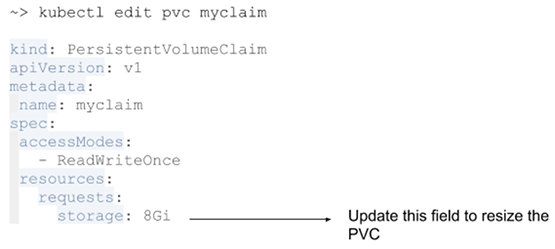

- 使用 Kubernetes 调整 PersistentVolume 的大小

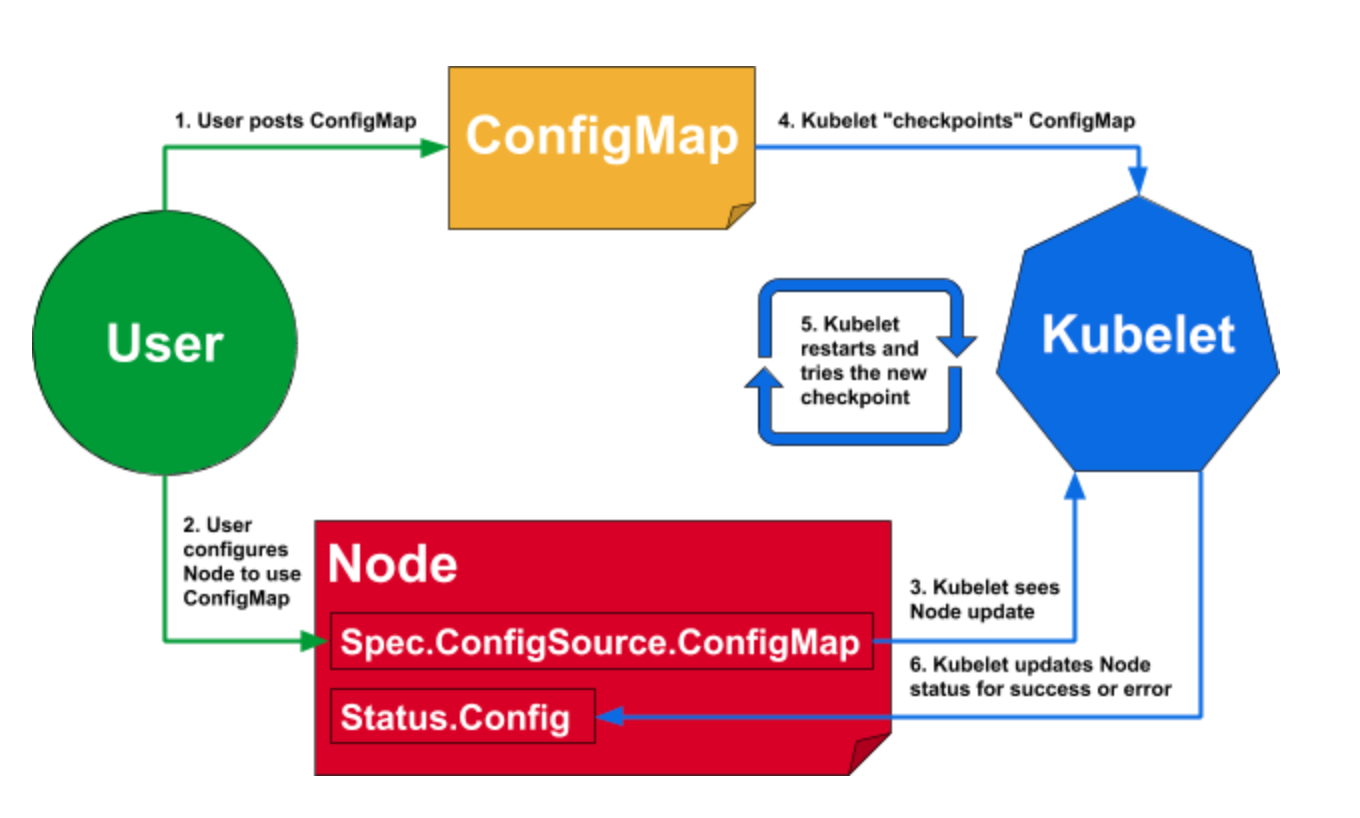

- 动态 Kubelet 配置

- 用于 Kubernetes 集群 DNS 的 CoreDNS GA 正式发布

- 基于 IPVS 的集群内部负载均衡

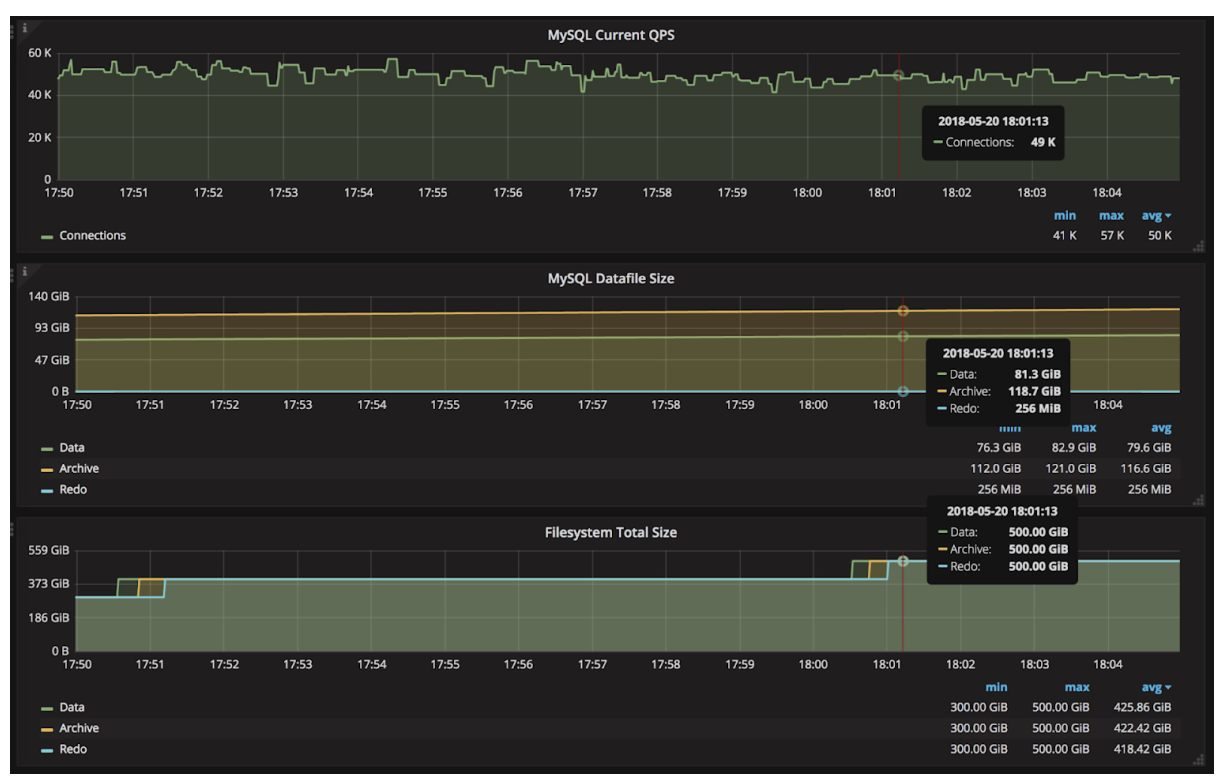

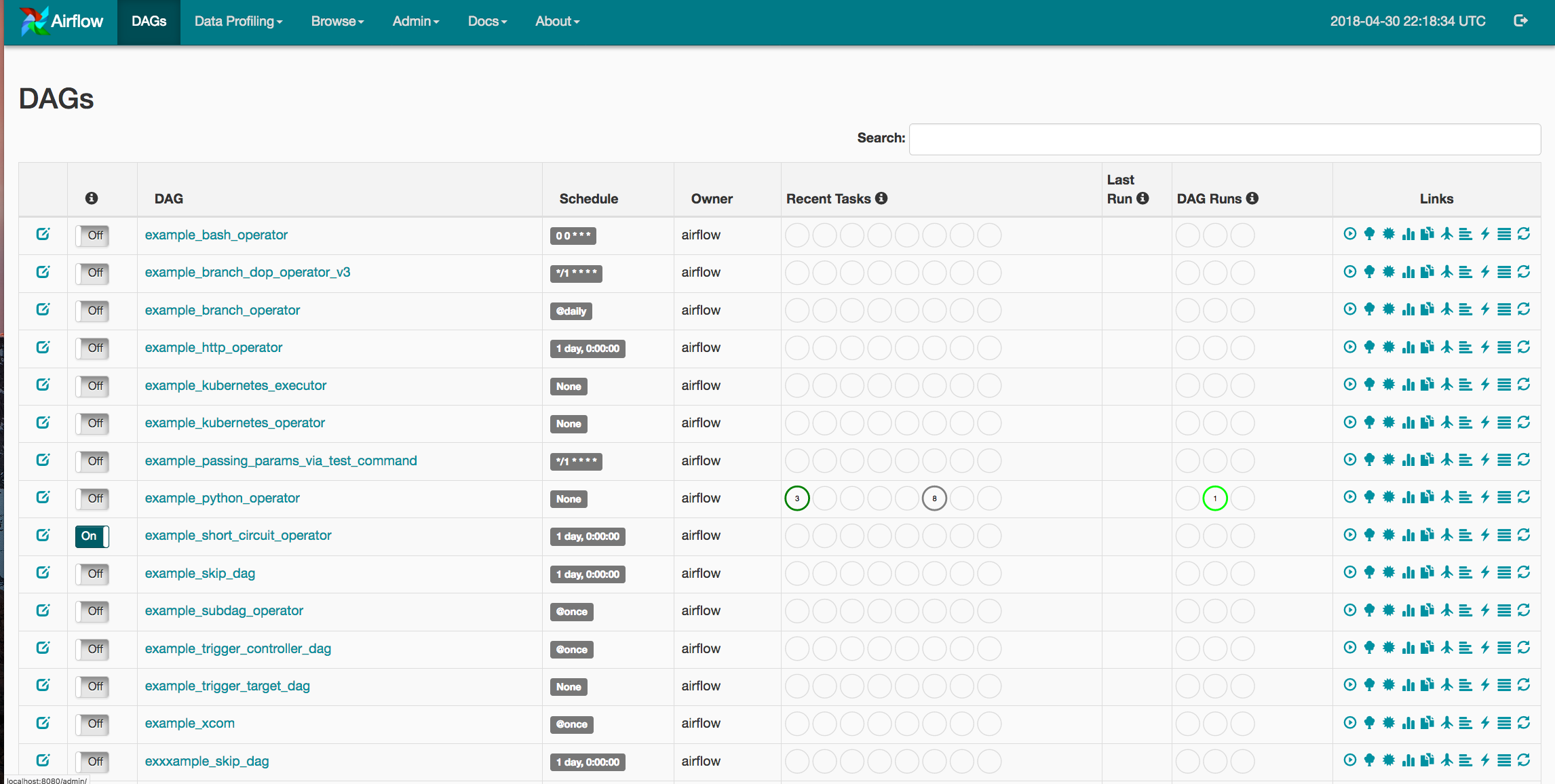

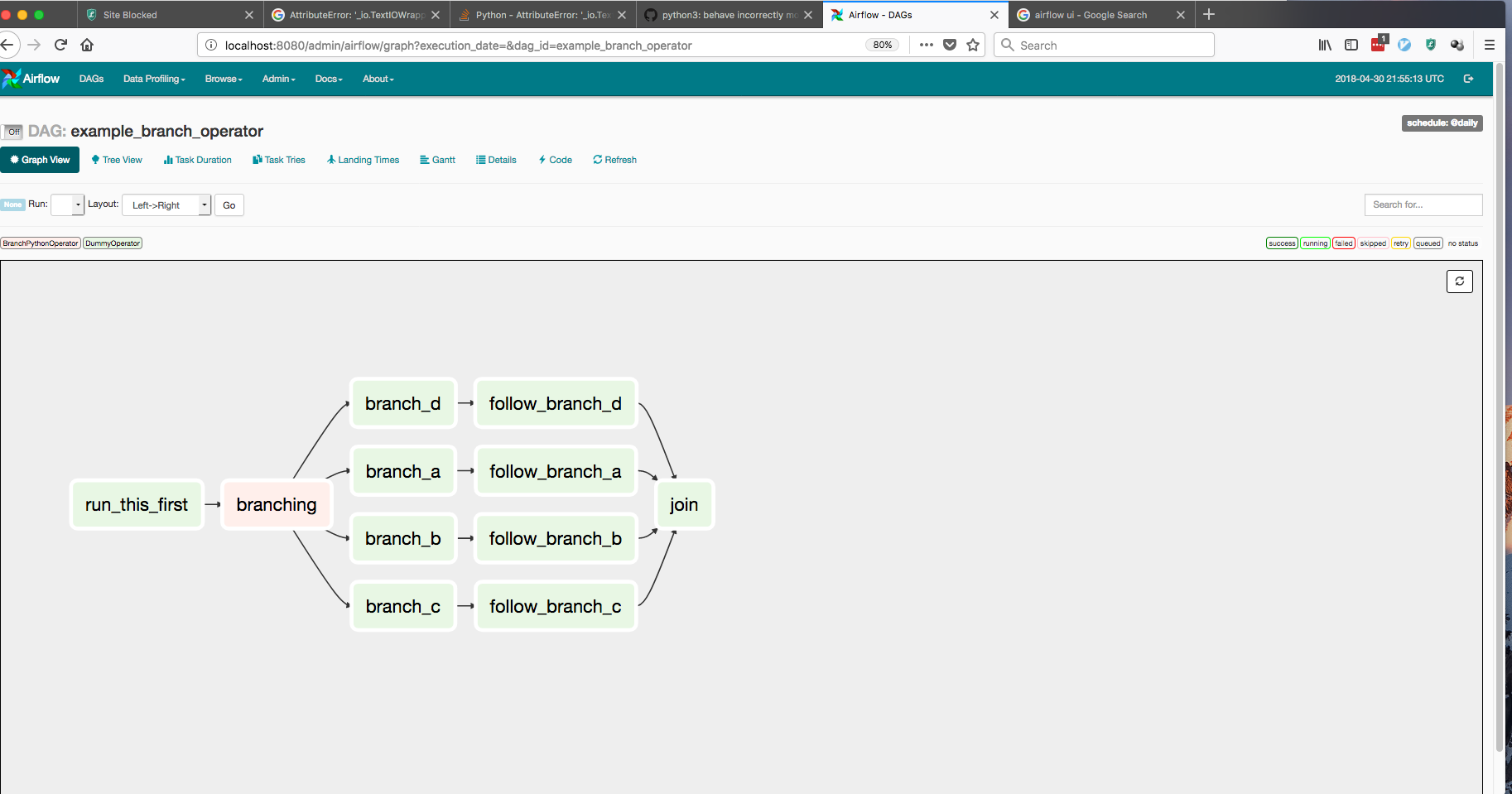

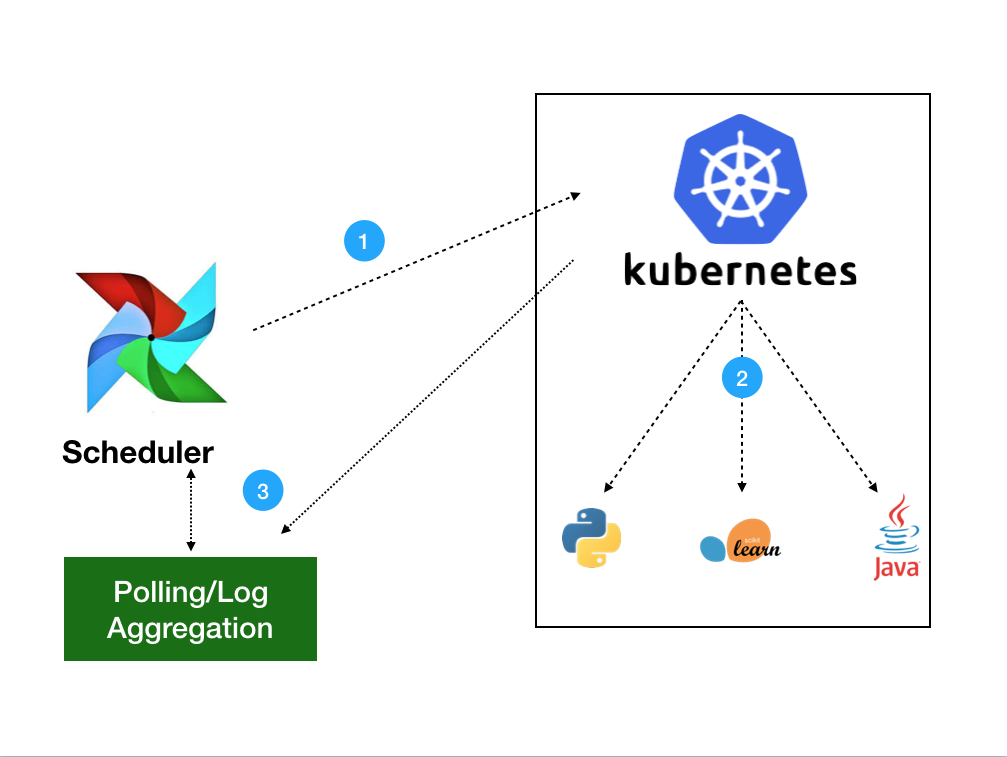

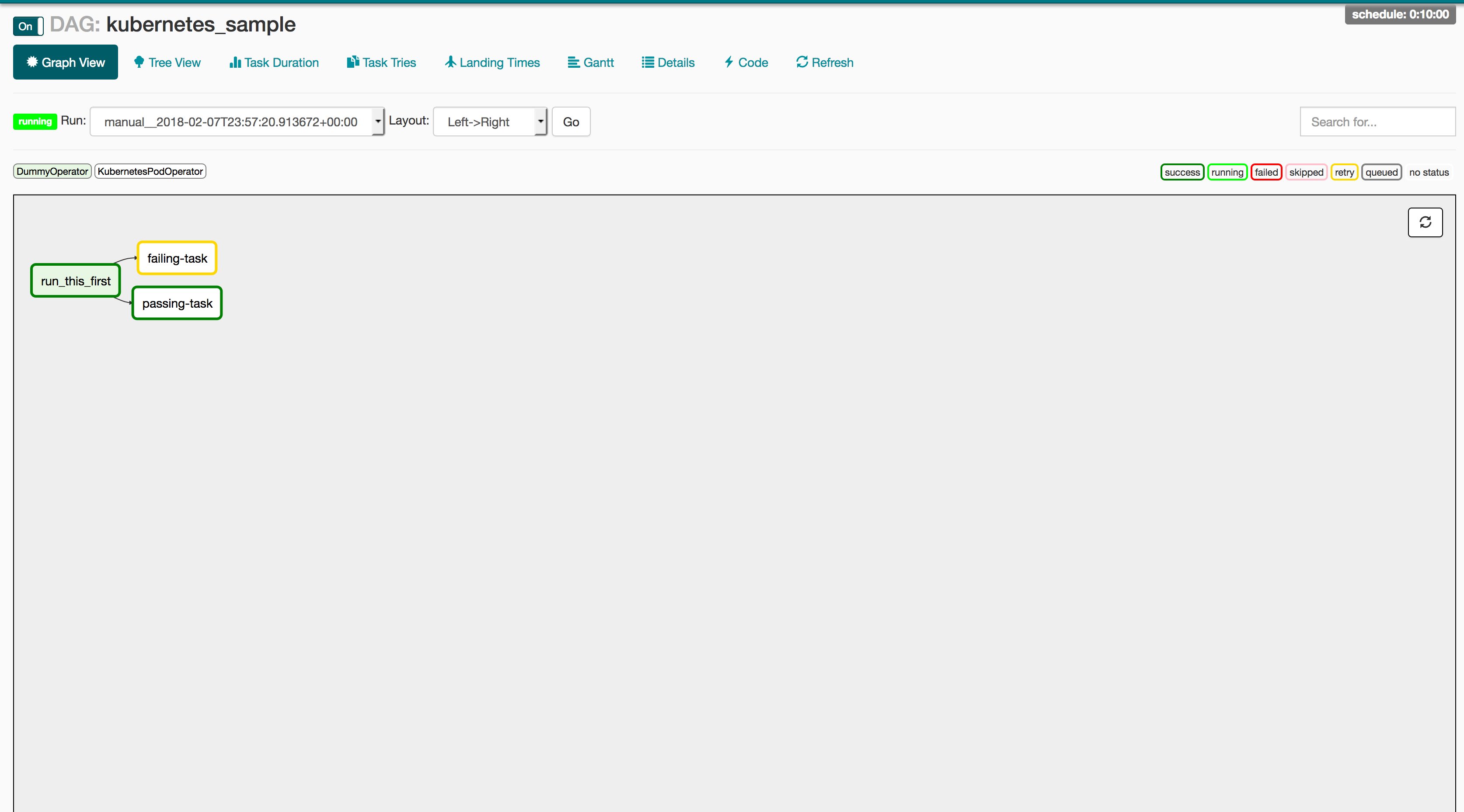

- Airflow 在 Kubernetes 中的使用(第一部分):一种不同的操作器

- Kubernetes 的动态 Ingress

- Kubernetes 这四年

- 向 Discuss Kubernetes 问好

- 在 Kubernetes 上开发

- Kubernetes 社区 - 2017 年开源排行榜榜首

- “基于容器的应用程序设计原理”

- Kubernetes 1.9 对 Windows Server 容器提供 Beta 版本支持

- Kubernetes 中自动缩放

- Kubernetes 1.8 的五天

- Kubernetes 社区指导委员会选举结果

- 使用 Kubernetes Pet Sets 和 Datera Elastic Data Fabric 的 FlexVolume 扩展有状态的应用程序

- SIG Apps: 为 Kubernetes 构建应用并在 Kubernetes 中进行运维

- Kubernetes 生日快乐。哦,这是你要去的地方!

- 将端到端的 Kubernetes 测试引入 Azure (第二部分)

- Dashboard - Kubernetes 的全功能 Web 界面

- Citrix + Kubernetes = 全垒打

- 容器中运行有状态的应用!? Kubernetes 1.3 说 “是!”

- CoreOS Fest 2016: CoreOS 和 Kubernetes 在柏林(和旧金山)社区见面会

- SIG-ClusterOps: 提升 Kubernetes 集群的可操作性和互操作性

- “SIG-Networking:1.3 版本引入 Kubernetes 网络策略 API”

- 在 Rancher 中添加对 Kuernetes 的支持

- KubeCon EU 2016:伦敦 Kubernetes 社区

- Kubernetes 社区会议记录 - 20160218

- Kubernetes 社区会议记录 - 20160204

- 容器世界现状,2016 年 1 月

- Kubernetes 社区会议记录 - 20160114

- 为什么 Kubernetes 不用 libnetwork

- Kubernetes 和 Docker 简单的 leader election

- 使用 Puppet 管理 Kubernetes Pod、Service 和 Replication Controller

- Kubernetes 1.1 性能升级,工具改进和社区不断壮大

- Kubernetes 社区每周环聊笔记——2015 年 7 月 31 日

- 宣布首个Kubernetes企业培训课程

- 幻灯片:Kubernetes 集群管理,爱丁堡大学演讲

- OpenStack 上的 Kubernetes

- Kubernetes 社区每周聚会笔记- 2015年5月1日

- 通过 RKT 对 Kubernetes 的 AppC 支持

- Kubernetes 社区每周聚会笔记- 2015年4月24日

- Borg: Kubernetes 的前身

- Kubernetes 社区每周聚会笔记- 2015年4月17日

- Kubernetes Release: 0.15.0

- 每周 Kubernetes 社区例会笔记 - 2015 年 4 月 3 日

- Kubernetes 社区每周聚会笔记 - 2015 年 3 月 27 日

- Kubernetes 采集视频

- 欢迎来到 Kubernetes 博客!

Kubernetes v1.32:内存管理器进阶至 GA

随着 Kubernetes 1.32 的发布,内存管理器已进阶至正式发布(GA), 这标志着在为容器化应用实现高效和可预测的内存分配的旅程中迈出了重要的一步。 内存管理器自 Kubernetes v1.22 进阶至 Beta 后,其可靠性、稳定性已得到证实, 是 CPU 管理器的一个良好补充特性。

作为 kubelet 的工作负载准入过程的一部分,内存管理器提供拓扑提示以优化内存分配和对齐。这使得用户能够为 Guaranteed QoS 类的 Pod 分配独占的内存。 有关此过程的细节,参见博客:内存管理器进阶至 Beta。

自 Beta 以来引入的大部分变更是修复 Bug、内部重构以及改进可观测性(例如优化指标和日志)。

改进可观测性

作为提高内存管理器可观测性工作的一部分,新增了一些指标以提供关于内存分配模式的某些统计信息。

memory_manager_pinning_requests_total - 跟踪 Pod 规约要求内存管理器锁定内存页的次数。

memory_manager_pinning_errors_total - 跟踪 Pod 规约要求内存管理器锁定内存页但分配失败的次数。

提高内存管理器可靠性和一致性

kubelet 不保证在 Pod 重启或重新引导后准入 Pod 的顺序。

在某些边缘情况下,这种行为可能导致内存管理器拒绝某些 Pod, 在更极端的情况下,可能导致 kubelet 在重启时失败。

以前,Beta 实现缺乏某些检查和逻辑来防止这些问题的发生。

为了使内存管理器更为稳定,以便为进阶至正式发布(GA)做好准备, 我们对算法进行了小而美的改进,提高了其稳健性和对边缘场景的处理能力。

未来发展

总体而言,未来对拓扑管理器(Topology Manager),特别是内存管理器,会有更多特性推出。 值得一提的是,目前的工作重心是将内存管理器支持扩展到 Windows, 使得在 Windows 操作系统上实现 CPU 和内存亲和性成为可能。

参与其中

此特性由 SIG Node 社区推动。请加入我们,与社区建立联系,分享你对上述特性及其他方面的想法和反馈。 我们期待听到你的声音!

Kubernetes v1.32 预览

随着 Kubernetes v1.32 发布日期的临近,Kubernetes 项目继续发展和成熟。 在这个过程中,某些特性可能会被弃用、移除或被更好的特性取代,以确保项目的整体健康与发展。

本文概述了 Kubernetes v1.32 发布的一些计划变更,发布团队认为你应该了解这些变更, 以确保你的 Kubernetes 环境得以持续维护并跟上最新的变化。以下信息基于 v1.32 发布的当前状态,实际发布日期前可能会有所变动。

Kubernetes API 的移除和弃用流程

Kubernetes 项目对功能特性有一个文档完备的弃用策略。 该策略规定,只有当较新的、稳定的相同 API 可用时,原有的稳定 API 才可能被弃用,每个稳定级别的 API 都有一个最短的生命周期。 弃用的 API 指的是已标记为将在后续发行某个 Kubernetes 版本时移除的 API; 移除之前该 API 将继续发挥作用(从弃用起至少一年时间),但使用时会显示一条警告。 移除的 API 将在当前版本中不再可用,此时你必须迁移以使用替换的 API。

正式发布的(GA)或稳定的 API 版本可被标记为已弃用,但不得在 Kubernetes 主要版本未变时删除。

Beta 或预发布 API 版本,必须保持在被弃用后 3 个发布版本中仍然可用。

Alpha 或实验性 API 版本可以在任何版本中删除,不必提前通知; 如果同一特性已有不同实施方案,则此过程可能会成为撤销。

无论 API 是因为特性从 Beta 升级到稳定状态还是因为未能成功而被移除, 所有移除操作都遵守此弃用策略。每当 API 被移除时, 迁移选项都会在弃用指南中进行说明。

关于撤回 DRA 的旧的实现的说明

增强特性 #3063 在 Kubernetes 1.26 中引入了动态资源分配(DRA)。

然而,在 Kubernetes v1.32 中,这种 DRA 的实现方法将发生重大变化。与原来实现相关的代码将被删除, 只留下 KEP #4381 作为"新"的基础特性。

改变现有方法的决定源于其与集群自动伸缩的不兼容性,因为资源可用性是不透明的, 这使得 Cluster Autoscaler 和控制器的决策变得复杂。 新增的结构化参数模型替换了原有特性。

这次移除将使 Kubernetes 能够更可预测地处理新的硬件需求和资源声明, 避免了与 kube-apiserver 之间复杂的来回 API 调用。

请参阅增强问题 #3063 以了解更多信息。

API 移除

在 Kubernetes v1.32 中,计划仅移除一个 API:

flowcontrol.apiserver.k8s.io/v1beta3版本的 FlowSchema 和 PriorityLevelConfiguration 已被移除。 为了对此做好准备,你可以编辑现有的清单文件并重写客户端软件,使用自 v1.29 起可用的flowcontrol.apiserver.k8s.io/v1API 版本。 所有现有的持久化对象都可以通过新 API 访问。flowcontrol.apiserver.k8s.io/v1beta3中的重要变化包括: 当未指定时,PriorityLevelConfiguration 的spec.limited.nominalConcurrencyShares字段仅默认为 30,而显式设置的 0 值不会被更改为此默认值。有关更多信息,请参阅 API 弃用指南。

Kubernetes v1.32 的抢先预览

以下增强特性有可能会被包含在 v1.32 发布版本中。请注意,这并不是最终承诺,发布内容可能会发生变化。

更多 DRA 增强特性!

在此次发布中,就像上一次一样,Kubernetes 项目继续提出多项对动态资源分配(DRA)的增强。 DRA 是 Kubernetes 资源管理系统的关键组件,这些增强旨在提高对需要专用硬件(如 GPU、FPGA 和网络适配器) 的工作负载进行资源分配的灵活性和效率。此次发布引入了多项改进,包括在 Pod 状态中添加资源健康状态, 具体内容详见 KEP #4680。

在 Pod 状态中添加资源健康状态

当 Pod 使用的设备出现故障或暂时不健康时,很难及时发现。

KEP #4680

提议通过 Pod 的 status 暴露设备健康状态,从而使 Pod 崩溃的故障排除更加容易。

Windows 工作继续

KEP #4802 为 Kubernetes 集群中的 Windows 节点添加了体面关机支持。 在此之前,Kubernetes 为 Linux 节点提供了体面关机特性,但缺乏对 Windows 节点的同等支持。 这一增强特性使 Windows 节点上的 kubelet 能够正确处理系统关机事件,确保在 Windows 节点上运行的 Pod 能够体面终止, 从而允许工作负载在不受干扰的情况下重新调度。这一改进提高了包含 Windows 节点的集群的可靠性和稳定性, 特别是在计划维护或系统更新期间。

允许环境变量中使用特殊字符

随着这一增强特性升级到 Beta 阶段,

Kubernetes 现在允许几乎所有的可打印 ASCII 字符(不包括 =)作为环境变量名称。

这一变化解决了此前对变量命名的限制,通过适应各种应用需求,促进了 Kubernetes 的更广泛采用。

放宽的验证将通过 RelaxedEnvironmentVariableValidation 特性门控默认启用,

确保用户可以轻松使用环境变量而不受严格限制,增强了开发者在处理需要特殊字符配置的应用(如 .NET Core)时的灵活性。

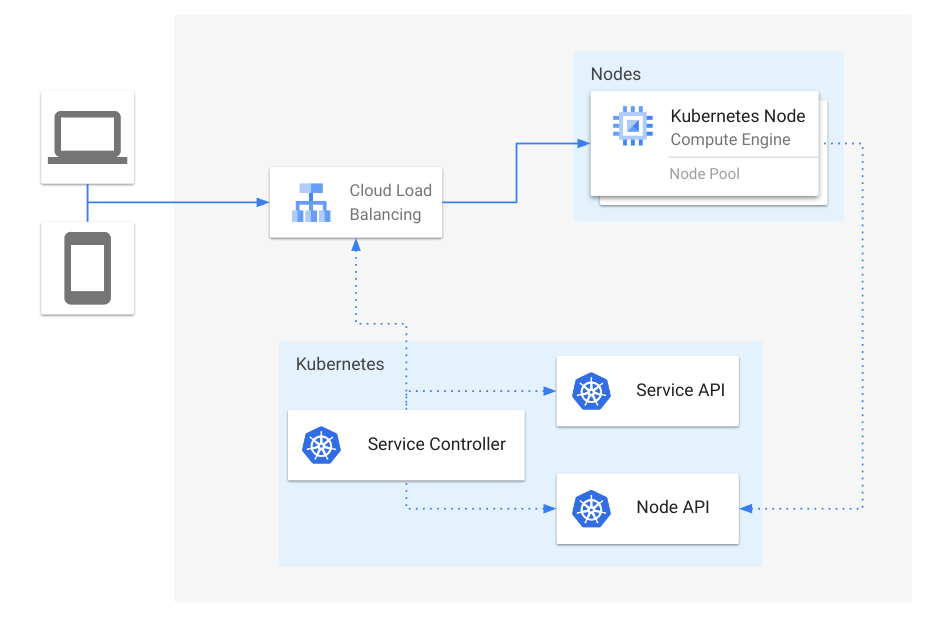

使 Kubernetes 感知到 LoadBalancer 的行为

KEP #1860 升级到 GA 阶段,

为 type: LoadBalancer 类型的 Service 引入了 ipMode 字段,该字段可以设置为 "VIP" 或 "Proxy"。

这一增强旨在改善云提供商负载均衡器与 kube-proxy 的交互方式,对最终用户来说是透明的。

使用 "VIP" 时,kube-proxy 会继续处理负载均衡,保持现有的行为。使用 "Proxy" 时,

流量将直接发送到负载均衡器,提供云提供商对依赖 kube-proxy 的更大控制权;

这意味着对于某些云提供商,你可能会看到负载均衡器性能的提升。

为资源生成名称时重试

这一增强特性改进了使用

generateName 字段创建 Kubernetes 资源时的名称冲突处理。此前,如果发生名称冲突,

API 服务器会返回 409 HTTP 冲突错误,客户端需要手动重试请求。通过此次更新,

API 服务器在发生冲突时会自动重试生成新名称,最多重试七次。这显著降低了冲突的可能性,

确保生成多达 100 万个名称时冲突的概率低于 0.1%,为大规模工作负载提供了更高的弹性。

想了解更多?

新特性和弃用特性也会在 Kubernetes 发布说明中宣布。我们将在此次发布的 Kubernetes v1.32 的 CHANGELOG 中正式宣布新内容。

你可以在以下版本的发布说明中查看变更公告:

关于日本的 Kubernetes 上游培训的特别报道

我们是日本 Kubernetes 上游培训的组织者。 我们的团队由积极向 Kubernetes 做贡献的成员组成,他们在社区中担任了 Member、Reviewer、Approver 和 Chair 等角色。

我们的目标是增加 Kubernetes 贡献者的数量,并促进社区的成长。 虽然 Kubernetes 社区友好协作,但新手可能会发现迈出贡献的第一步有些困难。 我们的培训项目旨在降低壁垒,创造一个即使是初学者也能顺利参与的环境。

日本 Kubernetes 上游培训是什么?

我们的培训始于 2019 年,每年举办 1 到 2 次。 最初,Kubernetes 上游培训曾作为 KubeCon(Kubernetes 贡献者峰会)的同场地活动进行, 后来我们在日本推出了 Kubernetes 上游培训,目的是通过在日本举办类似活动来增加日本的贡献者。

在疫情之前,培训是面对面进行的,但自 2020 年以来,我们已转为在线上进行。 培训为尚未参与过 Kubernetes 贡献的学员提供以下内容:

- Kubernetes 社区简介

- Kubernetes 代码库概述以及如何创建你的第一个 PR

- 各种降低参与壁垒(如语言)的提示和鼓励

- 如何搭建开发环境

- 使用 kubernetes-sigs/contributor-playground 开展实践课程

在培训开始时,我们讲解为什么贡献 Kubernetes 很重要以及谁可以做贡献。 我们强调,贡献 Kubernetes 可以让你产生全球影响,而 Kubernetes 社区期待着你的贡献!

我们还讲解 Kubernetes 社区、SIG(特别兴趣小组)和 WG(工作组)。 接下来,我们讲解 Member、Reviewer、Approver、Tech Lead 和 Chair 的角色与职责。 此外,我们介绍大家所使用的主要沟通工具,如 Slack、GitHub 和邮件列表。 一些讲日语的人可能会觉得用英语沟通是一个障碍。 此外,社区的新人需要理解在哪儿以及如何与人交流。 我们强调迈出第一步的重要性,这是我们培训中最关注的方面!

然后,我们讲解 Kubernetes 代码库的结构、主要的仓库、如何创建 PR 以及使用 Prow 的 CI/CD 流程。 我们详细讲解从创建 PR 到合并 PR 的过程。

经过几节课后,参与者将体验使用 kubernetes-sigs/contributor-playground 开展实践工作,在那里他们可以创建一个简单的 PR。 目标是让参与者体验贡献 Kubernetes 的过程。

在项目结束时,我们还提供关于为贡献 kubernetes/kubernetes 仓库搭建开发环境的详细说明,

包括如何在本地构建代码、如何高效运行测试以及如何搭建集群。

与参与者的访谈

我们对参与我们培训项目的人进行了访谈。 我们询问了他们参加的原因、印象和未来目标。

Keita Mochizuki(NTT DATA 集团公司)

Keita Mochizuki 是一位持续为 Kubernetes 及相关项目做贡献的贡献者。 他还是容器安全领域的专业人士,他最近出版了一本书。此外, 他还发布了一份新贡献者路线图, 对新贡献者非常有帮助。

Junya: 你为什么决定参加 Kubernetes 上游培训?

Keita: 实际上,我分别在 2020 年和 2022 年参加过两次培训。 在 2020 年,我刚开始学习 Kubernetes,想尝试参与工作以外的活动, 所以在 Twitter 上偶然看到活动后报了名参加了活动。 然而,那时我的知识积累还不多,贡献 OSS 感觉超出了我的能力。 因此,在培训后的理解比较肤浅,离开时更多是“嗯,好吧”的感觉。

在 2022 年,我再次参加,那时我认真考虑开始贡献。 我事先进行了研究,并能够在讲座中解决我的问题,那次经历非常有成效。

Junya: 参加后你有什么感受?

Keita: 我觉得培训的意义很大程度上取决于参与者的心态。 培训本身包括常规的讲解和简单的实践练习,但这并不意味着参加培训就会立即会去做贡献。

Junya: 你贡献的目的是什么?

Keita: 我最初的动机是“深入理解 Kubernetes 并生成成绩记录”,也就是说“贡献本身就是目标”。 如今,我还会通过贡献来解决我在工作中发现的 Bug 或约束。 此外,通过贡献,我变得不再那么犹豫,会去直接基于源代码分析了解没有文档记录的特性。

Junya: 贡献中遇到的挑战是什么?

Keita: 最困难的部分是迈出第一步。贡献 OSS 需要一定的知识水平,利用像这样的培训和他人的支持至关重要。

一句让我印象深刻的话是,“一旦你迈出第一步,后续就会变得更容易。”

此外,在作为工作的一部分继续贡献时,最具挑战性的是将输出的结果变为成就感。

要保持长期贡献,将贡献与业务目标和策略对齐非常重要,但上游贡献并不总是能直接产生与表现相关的即时结果。

因此,确保与管理人员的相互理解并获得他们的支持至关重要。

Junya: 你未来的目标是什么?

Keita: 我的目标是对影响更大的领域做出贡献。 到目前为止,我主要通过修复较小的 Bug 来做贡献,因为我的主要关注是生成一份成绩单, 但未来,我希望挑战自己对 Kubernetes 用户产生更大影响的贡献,或解决与我工作相关的问题。 最近,我还在努力将我对代码库所做的更改反映到官方文档中, 我将这视为实现我目标的一步。

Junya: 非常感谢!

Yoshiki Fujikane(CyberAgent, Inc.)

Yoshiki Fujikane 是 CNCF 沙盒项目 PipeCD 的维护者之一。 除了在 PipeCD 中开发对 Kubernetes 支持的新特性外, Yoshiki 还积极参与社区管理,并在各种技术会议上发言。

Junya: 你为什么决定参加 Kubernetes 上游培训?

Yoshiki: 当我参与培训时,我还是一名学生。 我只简短地接触过 EKS,我觉得 Kubernetes 看起来复杂但很酷,我对此有一种随意的兴趣。 当时,OSS 对我来说感觉像是遥不可及,而 Kubernetes 的上游开发似乎非常令人生畏。 虽然我一直对 OSS 感兴趣,但我不知道从哪里开始。 也就在那个时候,我了解到 Kubernetes 上游培训,并决定挑战自己为 Kubernetes 做贡献。

Junya: 参加后你的印象是什么?

Yoshiki: 我发现对于了解如何成为 OSS 社区的一部分,这种培训是一种非常有价值的方式。 当时,我的英语水平不是很好,所以获取主要信息源对我来说是一个很大的障碍。 Kubernetes 是一个非常大的项目,我对整体结构没有清晰的理解,更不用说贡献所需的内容了。 上游培训提供了对社区结构的日文解释,并让我获得了实际贡献的实践经验。 得益于我所得到的指导,我学会了如何接触主要信息源,并将其作为进一步研究的切入点,这对我帮助很大。 这次经历让我意识到组织和评审主要信息源的重要性,现在我经常在 GitHub Issue 和文档中深入研究我感兴趣的内容。 因此,虽然我不再直接向 Kubernetes 做贡献,但这次经历为我在其他项目中做贡献奠定了很好的基础。

Junya: 你目前在哪些领域做贡献?你参与了哪些其他项目?

Yoshiki: 目前,我不再从事 Kubernetes 的工作,而是担任 CNCF 沙盒项目 PipeCD 的维护者。 PipeCD 是一个支持各种应用平台的 GitOps 式部署的 CD 工具。 此工具最初作为 CyberAgent 的内部项目启动。 随着不同团队采用不同的平台,PipeCD 设计为提供一个统一的 CD 平台,确保用户体验一致。 目前,它支持 Kubernetes、AWS ECS、Lambda、Cloud Run 和 Terraform。

Junya: 你在 PipeCD 团队中扮演什么角色?

Yoshiki: 我全职负责团队中与 Kubernetes 相关特性的改进和开发。 由于我们将 PipeCD 作为内部 SaaS 提供,我的主要关注点是添加新特性和改进现有特性, 确保 PipeCD 能够持续良好支持 Kubernetes 等平台。 除了代码贡献外,我还通过在各种活动上发言和管理社区会议来帮助发展 PipeCD 社区。

Junya: 你能讲解一下你对于 Kubernetes 正在进行哪些改进或开发吗?

Yoshiki: PipeCD 支持 Kubernetes 的 GitOps 和渐进式交付,因此我参与这些特性的开发。 最近,我一直在开发简化跨多个集群部署的特性。

Junya: 在贡献 OSS 的过程中,你遇到过哪些挑战?

Yoshiki: 一个挑战是开发在满足用户用例的同时保持通用性的特性。 当我们在运营内部 SaaS 期间收到特性请求时,我们首先考虑添加特性来解决这些问题。 与此同时,我们希望 PipeCD 作为一个 OSS 工具被更广泛的受众使用。 因此,我总是思考为一个用例设计的特性是否可以应用于其他用例,以确保 PipeCD 这个软件保持灵活且广泛可用。

Junya: 你未来的目标是什么?

Yoshiki: 我希望专注于扩展 PipeCD 的功能。 目前,我们正在以“普遍可用的持续交付”(One CD for All)的口号开发 PipeCD。 正如我之前提到的,它支持 Kubernetes、AWS ECS、Lambda、Cloud Run 和 Terraform, 但还有许多其他平台,以及未来可能会出现的新平台。 因此,我们目前正在开发一个插件系统,允许用户自行扩展 PipeCD,我希望将这一努力向前推进。 我也在处理 Kubernetes 的多集群部署特性,目标是继续做出有影响力的贡献。

Junya: 非常感谢!

Kubernetes 上游培训的未来

我们计划继续在日本举办 Kubernetes 上游培训,并期待欢迎更多的新贡献者。 我们的下一次培训定于 11 月底在 CloudNative Days Winter 2024 期间举行。

此外,我们的目标不仅是在日本推广这些培训项目,还希望推广到全球。 今年的 Kubernetes 十周年庆, 以及为了使社区更加活跃,让全球各地的人们持续贡献至关重要。 虽然上游培训已经在多个地区举行,但我们希望将其带到更多地方。

我们希望随着越来越多的人加入 Kubernetes 社区并做出贡献,我们的社区将变得更加生机勃勃!

公布 2024 年指导委员会选举结果

2024 年指导委员会选举现已完成。 Kubernetes 指导委员会由 7 个席位组成,其中 3 个席位于 2024 年进行选举。 新任委员会成员的任期为 2 年,所有成员均由 Kubernetes 社区选举产生。

这个社区机构非常重要,因为它负责监督整个 Kubernetes 项目的治理。 权力越大责任越大,你可以在其 章程中了解有关指导委员会角色的更多信息。

感谢所有在选举中投票的人;你们的参与有助于支持社区的持续健康和成功。

结果

祝贺当选的委员会成员,其两年任期立即开始(按 GitHub 句柄按字母顺序列出):

- Antonio Ojea (@aojea), Google

- Benjamin Elder (@BenTheElder), Google

- Sascha Grunert (@saschagrunert), Red Hat

他们将与以下连任成员一起工作:

- Stephen Augustus (@justaugustus), Cisco

- Paco Xu 徐俊杰 (@pacoxu), DaoCloud

- Patrick Ohly (@pohly), Intel

- Maciej Szulik (@soltysh), Defense Unicorns

Benjamin Elder 是一位回归的指导委员会成员。

十分感谢!

感谢并祝贺本轮选举官员成功完成选举工作:

- Bridget Kromhout (@bridgetkromhout)

- Christoph Blecker (@cblecker)

- Priyanka Saggu (@Priyankasaggu11929)

感谢名誉指导委员会成员,你们的服务受到社区的赞赏:

- Bob Killen (@mrbobbytables)

- Nabarun Pal (@palnabarun)

感谢所有前来竞选的候选人。

参与指导委员会

这个管理机构与所有 Kubernetes 一样,向所有人开放。 你可以关注指导委员会会议记录, 并通过提交 Issue 或针对其 repo 创建 PR 来参与。 他们在太平洋时间每月第一个周一上午 8:00 举行开放的会议。 你还可以通过其公共邮件列表 steering@kubernetes.io 与他们联系。

你可以通过在 YouTube 播放列表上观看过去的会议来了解指导委员会会议的全部内容。

如果你想认识一些新当选的指导委员会成员, 欢迎参加在盐湖城举行的 2024 年北美 Kubernetes 贡献者峰会上的 Steering AMA。

这篇文章是由贡献者通信子项目撰写的。 如果你想撰写有关 Kubernetes 社区的故事,请了解有关我们的更多信息。

SIG Scheduling 访谈

在本次 SIG Scheduling 的访谈中,我们与 Kensei Nakada 进行了交流,他是 SIG Scheduling 的一名 Approver。

介绍

Arvind: 你好,感谢你让我们有机会了解 SIG Scheduling! 你能介绍一下自己,告诉我们你的角色以及你是如何参与 Kubernetes 的吗?

Kensei: 嗨,感谢你给我这个机会!我是 Kensei Nakada (@sanposhiho),是来自 Tetrate.io 的一名软件工程师。 我在业余时间为 Kubernetes 贡献了超过 3 年的时间,现在我是 Kubernetes 中 SIG Scheduling 的一名 Approver。 同时,我还是两个 SIG 子项目的创始人/负责人: kube-scheduler-simulator 和 kube-scheduler-wasm-extension。

关于 SIG Scheduling

AP: 太棒了!你参与这个项目已经很久了。你能简要概述一下 SIG Scheduling,并说明它在 Kubernetes 生态系统中的角色吗?

KN: 正如名字所示,我们的责任是增强 Kubernetes 中的调度特性。 具体来说,我们开发了一些组件,将每个 Pod 调度到最合适的 Node。 在 Kubernetes 中,我们的主要关注点是维护 kube-scheduler, 以及其他调度相关的组件,这些组件是 SIG Scheduling 的子项目。

AP: 明白了!我有点好奇,SIG Scheduling 最近为 Kubernetes 调度引入了哪些创新或发展?

KN: 从特性的角度来看,最近对 PodTopologySpread

进行了几项增强。

PodTopologySpread 是调度器中一个相对较新的特性,我们仍在收集反馈并进行改进。

最近,我们专注于一个内部增强特性,称为 QueueingHint, 这个特性旨在提高调度的吞吐量。吞吐量是我们调度中的关键指标之一。传统上,我们主要关注优化每个调度周期的延迟。 而 QueueingHint 采取了一种不同的方法,它可以优化何时重试调度,从而减少浪费调度周期的可能性。

A: 听起来很有趣!你目前在 SIG Scheduling 中还有其他有趣的主题或项目吗?

KN: 我正在牵头刚刚提到的 QueueingHint 的开发。考虑到这是我们面临的一项重大新挑战,

我们遇到了许多意想不到的问题,特别是在可扩展性方面,我们正在努力解决每一个问题,使这项特性最终能够默认启用。

此外,我认为我去年启动的 kube-scheduler-wasm-extension(SIG 子项目) 对许多人来说也会很有趣。Kubernetes 有各种扩展来自许多组件。传统上,扩展通过 Webhook (调度器中的 extender)或 Go SDK(调度器中的调度框架)提供。 然而,这些方法存在缺点,首先是 Webhook 的性能问题以及需要重建和替换调度器的 Go SDK,这就给那些希望扩展调度器但对其不熟悉的人带来了困难。 此项目尝试引入一种新的解决方案来应对这一普遍挑战,即基于 WebAssembly 的扩展。 Wasm 允许用户轻松构建插件,而无需担心重新编译或替换调度器,还能规避性能问题。

通过这个项目,SIG Scheduling 正在积累 WebAssembly 与大型 Kubernetes 对象交互的宝贵洞察。 我相信我们所获得的经验应该对整个社区都很有用,而不仅限于 SIG Scheduling 的范围。

A: 当然!目前 SIG Scheduling 有 8 个子项目。你想谈谈它们吗?有没有一些你想强调的有趣贡献?

KN: 让我挑选三个子项目:Kueue、KWOK 和 Descheduler。

- Kueue:

- 最近,许多人尝试使用 Kubernetes 管理批处理工作负载,2022 年,Kubernetes 社区成立了 WG-Batch, 以更好地支持 Kubernetes 中的此类批处理工作负载。 Kueue 是一个在其中扮演关键角色的项目。 它是一个作业队列控制器,决定何时一个作业应该等待,何时一个作业应该被准许启动,以及何时一个作业应该被抢占。 Kueue 旨在安装在一个普通的 Kubernetes 集群上, 同时与现有的成熟控制器(调度器、cluster-autoscaler、kube-controller-manager 等)协作。

- KWOK

- KWOK 这个组件可以在几秒钟内创建一个包含数千个节点的集群。它主要用于模拟/测试轻量级集群,实际上另一个 SIG 子项目 kube-scheduler-simulator 就在后端使用了 KWOK。

- Descheduler

- Descheduler 这个组件可以将运行在不理想的节点上的 Pod 重新创建。

在 Kubernetes 中,调度约束(

PodAffinity、NodeAffinity、PodTopologySpread等)仅在 Pod 调度时被考虑, 但不能保证这些约束在之后仍然被满足。Descheduler 会驱逐违反其调度约束(或其他不符合预期状况)的 Pod, 以便这些 Pod 被重新创建和重新调度。

- Descheduling Framework:

- 一个非常有趣的正在进行的项目,类似于调度器中的调度框架, 旨在使去调度逻辑可扩展,并允许维护者们专注于构建 Descheduler 的核心引擎。

AP: 感谢你告诉我们这些!我想问一下,你最喜欢这个 SIG 的哪些方面?

KN: 我真正喜欢这个 SIG 的地方在于每个人都积极参与。 我们来自不同的公司和行业,带来了多样的视角。 这些差异并没有造成分歧,实际上产生了丰富的观点。 每种观点都会受到尊重,这使我们的讨论既丰富又富有成效。

我非常欣赏这种协作氛围,我相信这对我们多年来不断改进组件至关重要。

给 SIG Scheduling 做贡献

AP: Kubernetes 是一个社区驱动的项目。你对新贡献者或希望参与并为 SIG Scheduling 做出贡献的初学者有什么建议?他们应该从哪里开始?

KN: 让我先给出一个关于为任何 SIG 贡献的通用建议:一种常见的方法是寻找 good-first-issue。 然而,你很快就会意识到,世界各地有很多人正在尝试为 Kubernetes 仓库做贡献。

我建议先查看你感兴趣的某个组件的实现。如果你对该组件有任何疑问,可以在相应的 Slack 频道中提问(例如,调度器的 #sig-scheduling,kubelet 的 #sig-node 等)。 一旦你对实现有了大致了解,就可以查看 SIG 中的 Issue (例如,sig-scheduling), 相比 good-first-issue,在这里你会发现更多未分配的 Issue。你可能还想过滤带有 kind/cleanup 标签的 Issue,这通常表示较低优先级的任务,可以作为起点。

具体对于 SIG Scheduling 而言,你应该先了解调度框架, 这是 kube-scheduler 的基本架构。大多数实现都可以在 pkg/scheduler中找到。我建议从 ScheduleOne 函数开始,然后再深入探索。

此外,除了 kubernetes/kubernetes 主仓库外,还可以考虑查看一些子项目。 这些子项目的维护者通常比较少,你有更多的机会来对其产生重大影响。尽管被称为“子”项目, 但许多项目实际上有大量用户,并对社区产生了相当大的影响。

最后但同样重要的是,记住为社区做贡献不仅仅是编写代码。 虽然我谈到了很多关于实现的贡献,但还有许多其他方式可以做贡献,每一种都很有价值。 对某个 Issue 的一条评论,对现有特性的一个反馈,对 PR 的一个审查建议,对文档的一个说明阐述; 每一个小贡献都有助于推动 Kubernetes 生态系统向前发展。

AP: 这些建议非常有用!冒昧问一下,你是如何帮助新贡献者入门的,参与 SIG Scheduling 的贡献者可能会学习到哪些技能?

KN: 我们的维护者在 #sig-scheduling Slack 频道中随时可以回答你的问题。 多多参与,你将深入了解 Kubernetes 的调度,并有机会与来自不同背景的维护者合作和建立联系。 你将学习到的不仅仅是如何编写代码,还有如何维护大型项目、设计和讨论新特性、解决 Bug 等等。

未来方向

AP: 在调度方面,Kubernetes 特有的挑战有哪些?有没有特别的痛点?

KN: 在 Kubernetes 中进行调度可能相当具有挑战性,因为不同组织有不同的业务要求。 在 kube-scheduler 中支持所有可能的使用场景是不可能的。因此,可扩展性是我们关注的核心焦点。 几年前,我们使用调度框架为 kube-scheduler 重新设计了架构,为用户通过插件实现各种调度需求提供了灵活的可扩展性。 这使得维护者们能够专注于核心调度特性和框架运行时。

另一个主要问题是保持足够的调度吞吐量。通常,一个 Kubernetes 集群只有一个 kube-scheduler, 因此其吞吐量直接影响整体调度的可扩展性,从而影响集群的可扩展性。尽管我们有一个内部性能测试 (scheduler_perf), 但不巧的是,我们有时会忽视在不常见场景下的性能下降。即使是与性能无关的小改动也有难度,可能导致性能下降。

AP: 接下来 SIG Scheduling 有哪些即将实现的目标或计划?你如何看待 SIG 的未来发展?

KN: 我们的主要目标始终是构建和维护可扩展的和稳定的调度运行时,我敢打赌这个目标将永远不会改变。

正如之前所提到的,可扩展性是解决调度多样化需求挑战的关键。我们不会尝试直接在 kube-scheduler 中支持每种不同的使用场景, 而是将继续专注于增强可扩展性,以便能够适应各种用例。我提到的 kube-scheduler-wasm-extension 也是这一计划的一部分。

关于稳定性,引入 QueueHint 这类新的优化是我们的一项策略。 此外,保持吞吐量也是面向未来的关键目标。我们计划增强我们的吞吐量监控 (参考), 以便在发布之前尽可能多地发现性能下降问题。但实际上,我们无法覆盖每个可能的场景。 我们非常感谢社区对调度吞吐量的关注,鼓励大家提出反馈,就性能问题提出警示!

结束语

AP: 最后,你想对那些有兴趣了解 SIG Scheduling 的人说些什么?

KN: 调度是 Kubernetes 中最复杂的领域之一,你可能一开始会觉得很困难。但正如我之前分享的, 你可以找到许多贡献的机会,许多维护者愿意帮助你理解各事项。 我们知道你独特的视角和技能是我们的开源项目能够如此强大的源泉 😊

随时可以通过 Slack (#sig-scheduling) 或会议联系我们。 我希望这篇文章能引起大家的兴趣,希望能吸引到新的贡献者!

AP: 非常感谢你抽出时间进行这次访谈!我相信很多人会发现这些信息对理解 SIG Scheduling 和参与 SIG 的贡献非常有价值。

Kubernetes v1.31:kubeadm v1beta4

作为 Kubernetes v1.31 发布的一部分,kubeadm

采用了全新版本(v1beta4)的配置文件格式。

之前 v1beta3 格式的配置现已正式弃用,这意味着尽管之前的格式仍然受支持,但你应迁移到 v1beta4 并停止使用已弃用的格式。

对 v1beta3 配置的支持将在至少 3 次 Kubernetes 次要版本发布后被移除。

在本文中,我将介绍关键的变更;我将解释 kubeadm v1beta4 配置格式,以及如何从 v1beta3 迁移到 v1beta4。

你可以参阅 v1beta4 配置格式的参考文档: kubeadm 配置 (v1beta4)。

自 v1beta3 以来的变更列表

此版本通过修复一些小问题并添加一些新字段来改进 v1beta3 格式。

简单而言,

- 增加了两个新的配置元素:ResetConfiguration 和 UpgradeConfiguration

- 对于 InitConfiguration 和 JoinConfiguration,支持

dryRun模式和nodeRegistration.imagePullSerial - 对于 ClusterConfiguration,新增字段包括

certificateValidityPeriod、caCertificateValidityPeriod、encryptionAlgorithm、dns.disabled和proxy.disabled - 所有控制平面组件支持

extraEnvs extraArgs从映射变更为支持重复的结构化额外参数- 为 init、join、upgrade 和 reset 添加了

timeouts结构

有关细节请参阅以下官方文档:

- 在

ClusterConfiguration下支持控制平面组件的自定义环境变量。 可以使用apiServer.extraEnvs、controllerManager.extraEnvs、scheduler.extraEnvs、etcd.local.extraEnvs。 - ResetConfiguration API 类型现在在 v1beta4 中得到支持。用户可以通过将

--config文件传递给kubeadm reset来重置节点。 dryRun模式现在在 InitConfiguration 和 JoinConfiguration 中可配置。

- 用支持重复的结构化额外参数替换现有的 string/string 额外参数映射。

此变更适用于

ClusterConfiguration-apiServer.extraArgs、controllerManager.extraArgs、scheduler.extraArgs、etcd.local.extraArgs。也适用于nodeRegistrationOptions.kubeletExtraArgs。 - 添加了

ClusterConfiguration.encryptionAlgorithm,可用于设置此集群的密钥和证书所使用的非对称加密算法。 可以是 "RSA-2048"(默认)、"RSA-3072"、"RSA-4096" 或 "ECDSA-P256" 之一。 - 添加了

ClusterConfiguration.dns.disabled和ClusterConfiguration.proxy.disabled, 可用于在集群初始化期间禁用 CoreDNS 和 kube-proxy 插件。 在集群创建期间跳过相关插件阶段将把相同的字段设置为true。

- 在

InitConfiguration和JoinConfiguration中添加了nodeRegistration.imagePullSerial字段, 可用于控制 kubeadm 是顺序拉取镜像还是并行拉取镜像。 - 当将

--config传递给kubeadm upgrade子命令时,现已在 v1beta4 中支持 UpgradeConfiguration kubeadm API。 对于升级子命令,kubelet 和 kube-proxy 的组件配置以及 InitConfiguration 和 ClusterConfiguration 的用法现已弃用, 并将在传递--config时被忽略。 - 在

InitConfiguration、JoinConfiguration、ResetConfiguration和UpgradeConfiguration中添加了timeouts结构,可用于配置各种超时。ClusterConfiguration.timeoutForControlPlane字段被timeouts.controlPlaneComponentHealthCheck替换。JoinConfiguration.discovery.timeout被timeouts.discovery替换。

- 向

ClusterConfiguration添加了certificateValidityPeriod和caCertificateValidityPeriod字段。 这些字段可用于控制 kubeadm 在init、join、upgrade和certs等子命令中生成的证书的有效期。 默认值继续为非 CA 证书 1 年和 CA 证书 10 年。另请注意,只有非 CA 证书可以通过kubeadm certs renew进行续期。

这些变更简化了使用 kubeadm 的工具的配置,并提高了 kubeadm 本身的可扩展性。

如何将 v1beta3 配置迁移到 v1beta4?

如果你的配置未使用最新版本,建议你使用 kubeadm config migrate 命令进行迁移。

此命令读取使用旧格式的现有配置文件,并写入一个使用当前格式的新文件。

示例

使用 kubeadm v1.31,运行 kubeadm config migrate --old-config old-v1beta3.yaml --new-config new-v1beta4.yaml

我该如何参与?

衷心感谢在此特性的设计、实现和评审中提供帮助的所有贡献者:

- Lubomir I. Ivanov (neolit123)

- Dave Chen (chendave)

- Paco Xu (pacoxu)

- Sata Qiu (sataqiu)

- Baofa Fan (carlory)

- Calvin Chen (calvin0327)

- Ruquan Zhao (ruquanzhao)

如果你有兴趣参与 kubeadm 配置的后续讨论,可以通过多种方式与 kubeadm 或 SIG-cluster-lifecycle 联系:

- v1beta4 相关事项在 kubeadm issue #2890 中跟踪。

- Slack: #kubeadm 或 #sig-cluster-lifecycle

- 邮件列表

Kubernetes 1.31:kubectl debug 中的自定义模板化配置特性已进入 Beta 阶段

有很多方法可以对集群中的 Pod 和节点进行故障排查,而 kubectl debug 是最简单、使用最广泛、最突出的方法之一。

它提供了一组静态配置,每个配置适用于不同类型的角色。

例如,从网络管理员的视角来看,调试节点应该像这样简单:

$ kubectl debug node/mynode -it --image=busybox --profile=netadmin

另一方面,静态配置也存在固有的刚性,对某些 Pod 所产生的影响与其易用性是相悖的。 因为各种类型的 Pod(或节点)都有其特定的需求,不幸的是,有些问题仅通过静态配置是无法调试的。

以一个简单的 Pod 为例,此 Pod 由一个容器组成,其健康状况依赖于环境变量:

apiVersion: v1

kind: Pod

metadata:

name: example-pod

spec:

containers:

- name: example-container

image: customapp:latest

env:

- name: REQUIRED_ENV_VAR

value: "value1"

目前,复制 Pod 是使用 kubectl debug 命令调试此 Pod 的唯一机制。

此外,如果用户需要将 REQUIRED_ENV_VAR 环境变量修改为其他不同值来进行高级故障排查,

当前并没有机制能够实现这一需求。

自定义模板化配置

自定义模板化配置使用 --custom 标志提供的一项新特性,在 kubectl debug 中引入以提供可扩展性。

它需要以 YAML 或 JSON 格式的内容填充 container 规约,

为了通过创建临时容器来调试上面的示例容器,我们只需定义此 YAML:

# partial_container.yaml

env:

- name: REQUIRED_ENV_VAR

value: value2

并且执行:

kubectl debug example-pod -it --image=customapp --custom=partial_container.yaml

下面是另一个在 JSON 中一次修改多个字段(更改端口号、添加资源限制、修改环境变量)的示例:

{

"ports": [

{

"containerPort": 80

}

],

"resources": {

"limits": {

"cpu": "0.5",

"memory": "512Mi"

},

"requests": {

"cpu": "0.2",

"memory": "256Mi"

}

},

"env": [

{

"name": "REQUIRED_ENV_VAR",

"value": "value2"

}

]

}

约束

不受控制的扩展性会损害可用性。因此,某些字段(例如命令、镜像、生命周期、卷设备和容器名称)不允许进行自定义模版化配置。 将来如果需要,可以将更多字段添加到禁止列表中。

限制

kubectl debug 命令有 3 个方面:使用临时容器进行调试、Pod 复制和节点调试。

这些方面最大的交集是 Pod 内的容器规约,因此自定义模版化配置仅支持修改使用 containers 下定义的字段。

这导致了一个限制,如果用户需要修改 Pod 规约中的其他字段,则不受支持。

致谢

特别感谢所有审查和评论此特性(从最初的概念到实际实施)的贡献者(按字母顺序排列):

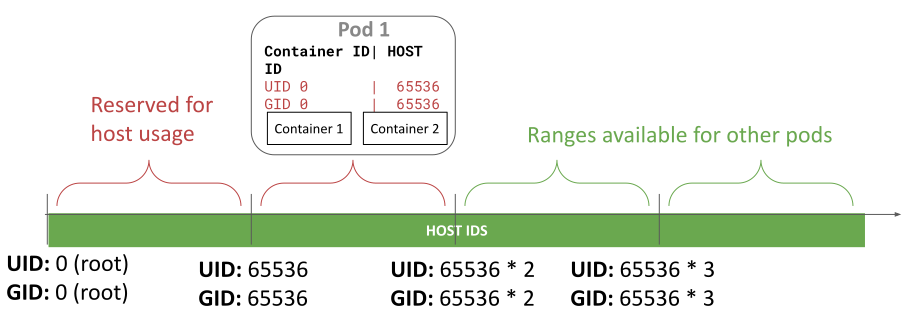

Kubernetes 1.31:细粒度的 SupplementalGroups 控制

本博客讨论了 Kubernetes 1.31 中的一项新特性,目的是改善处理 Pod 中容器内的附加组。

动机:容器镜像中 /etc/group 中定义的隐式组成员关系

尽管这种行为可能并不受许多 Kubernetes 集群用户/管理员的欢迎,

但 Kubernetes 默认情况下会将 Pod 中的组信息与容器镜像中 /etc/group 中定义的信息进行合并。

让我们看一个例子,以下 Pod 在 Pod 的安全上下文中指定了

runAsUser=1000、runAsGroup=3000 和 supplementalGroups=4000。

apiVersion: v1

kind: Pod

metadata:

name: implicit-groups

spec:

securityContext:

runAsUser: 1000

runAsGroup: 3000

supplementalGroups: [4000]

containers:

- name: ctr

image: registry.k8s.io/e2e-test-images/agnhost:2.45

command: [ "sh", "-c", "sleep 1h" ]

securityContext:

allowPrivilegeEscalation: false

在 ctr 容器中执行 id 命令的结果是什么?

# 创建 Pod:

$ kubectl apply -f https://k8s.io/blog/2024-08-22-Fine-grained-SupplementalGroups-control/implicit-groups.yaml

# 验证 Pod 的容器正在运行:

$ kubectl get pod implicit-groups

# 检查 id 命令

$ kubectl exec implicit-groups -- id

输出应类似于:

uid=1000 gid=3000 groups=3000,4000,50000

尽管 50000 根本没有在 Pod 的清单中被定义,但附加组中的组 ID 50000(groups 字段)是从哪里来的呢?

答案是容器镜像中的 /etc/group 文件。

检查容器镜像中 /etc/group 的内容应如下所示:

$ kubectl exec implicit-groups -- cat /etc/group

...

user-defined-in-image:x:1000:

group-defined-in-image:x:50000:user-defined-in-image

原来如此!容器的主要用户 1000 属于最后一个条目中的组 50000。

因此,容器镜像中为容器的主要用户定义的组成员关系会被隐式合并到 Pod 的信息中。 请注意,这是当前 CRI 实现从 Docker 继承的设计决策,而社区直到现在才重新考虑这个问题。

这有什么问题?

从容器镜像中的 /etc/group 隐式合并的组信息可能会引起一些担忧,特别是在访问卷时

(有关细节参见 kubernetes/kubernetes#112879),

因为在 Linux 中文件权限是通过 uid/gid 进行控制的。

更糟糕的是,隐式的 gid 无法被任何策略引擎所检测/验证,因为在清单中没有隐式组信息的线索。

这对 Kubernetes 的安全性也可能构成隐患。

Pod 中的细粒度 SupplementalGroups 控制:SupplementaryGroupsPolicy

为了解决上述问题,Kubernetes 1.31 在 Pod 的 .spec.securityContext

中引入了新的字段 supplementalGroupsPolicy。

此字段提供了一种控制 Pod 中容器进程如何计算附加组的方法。可用的策略如下:

Merge:将容器的主要用户在

/etc/group中定义的组成员关系进行合并。 如果不指定,则应用此策略(即为了向后兼容性而保持的原有行为)。Strict:仅将

fsGroup、supplementalGroups或runAsGroup字段中指定的组 ID 挂接为容器进程的附加组。这意味着容器的主要用户在/etc/group中定义的任何组成员关系都不会被合并。

让我们看看 Strict 策略是如何工作的。

apiVersion: v1

kind: Pod

metadata:

name: strict-supplementalgroups-policy

spec:

securityContext:

runAsUser: 1000

runAsGroup: 3000

supplementalGroups: [4000]

supplementalGroupsPolicy: Strict

containers:

- name: ctr

image: registry.k8s.io/e2e-test-images/agnhost:2.45

command: [ "sh", "-c", "sleep 1h" ]

securityContext:

allowPrivilegeEscalation: false

# 创建 Pod:

$ kubectl apply -f https://k8s.io/blog/2024-08-22-Fine-grained-SupplementalGroups-control/strict-supplementalgroups-policy.yaml

# 验证 Pod 的容器正在运行:

$ kubectl get pod strict-supplementalgroups-policy

# 检查进程身份:

kubectl exec -it strict-supplementalgroups-policy -- id

输出应类似于:

uid=1000 gid=3000 groups=3000,4000

你可以看到 Strict 策略可以将组 50000 从 groups 中排除出去!

因此,确保(通过某些策略机制强制执行的)supplementalGroupsPolicy: Strict 有助于防止 Pod 中的隐式附加组。

说明:

实际上,这还不够,因为具有足够权限/能力的容器可以更改其进程身份。 有关细节参见以下章节。

Pod 状态中挂接的进程身份

此特性还通过 .status.containerStatuses[].user.linux

字段公开挂接到容器的第一个容器进程的进程身份。这将有助于查看隐式组 ID 是否被挂接。

...

status:

containerStatuses:

- name: ctr

user:

linux:

gid: 3000

supplementalGroups:

- 3000

- 4000

uid: 1000

...

说明:

请注意,status.containerStatuses[].user.linux 字段中的值是首次挂接到容器中第一个容器进程的进程身份。

如果容器具有足够的权限调用与进程身份相关的系统调用(例如

setuid(2)、

setgid(2) 或

setgroups(2) 等),

则容器进程可以更改其身份。因此,实际的进程身份将是动态的。

特性可用性

要启用 supplementalGroupsPolicy 字段,必须使用以下组件:

- Kubernetes:v1.31 或更高版本,启用

SupplementalGroupsPolicy特性门控。 截至 v1.31,此门控标记为 Alpha。 - CRI 运行时:

- containerd:v2.0 或更高版本

- CRI-O:v1.31 或更高版本

你可以在 Node 的 .status.features.supplementalGroupsPolicy 字段中查看此特性是否受支持。

apiVersion: v1

kind: Node

...

status:

features:

supplementalGroupsPolicy: true

接下来

Kubernetes SIG Node 希望并期待此特性将在 Kubernetes 后续版本中进阶至 Beta, 并最终进阶至正式发布(GA),以便用户不再需要手动启用特性门控。

当 supplementalGroupsPolicy 未被指定时,将应用 Merge 策略,以保持向后兼容性。

我如何了解更多?

- 为 Pod 或容器配置安全上下文以获取有关

supplementalGroupsPolicy的更多细节 - KEP-3619:细粒度 SupplementalGroups 控制

如何参与?

此特性由 SIG Node 社区推动。请加入我们,与社区保持联系, 分享你对上述特性及其他方面的想法和反馈。我们期待听到你的声音!

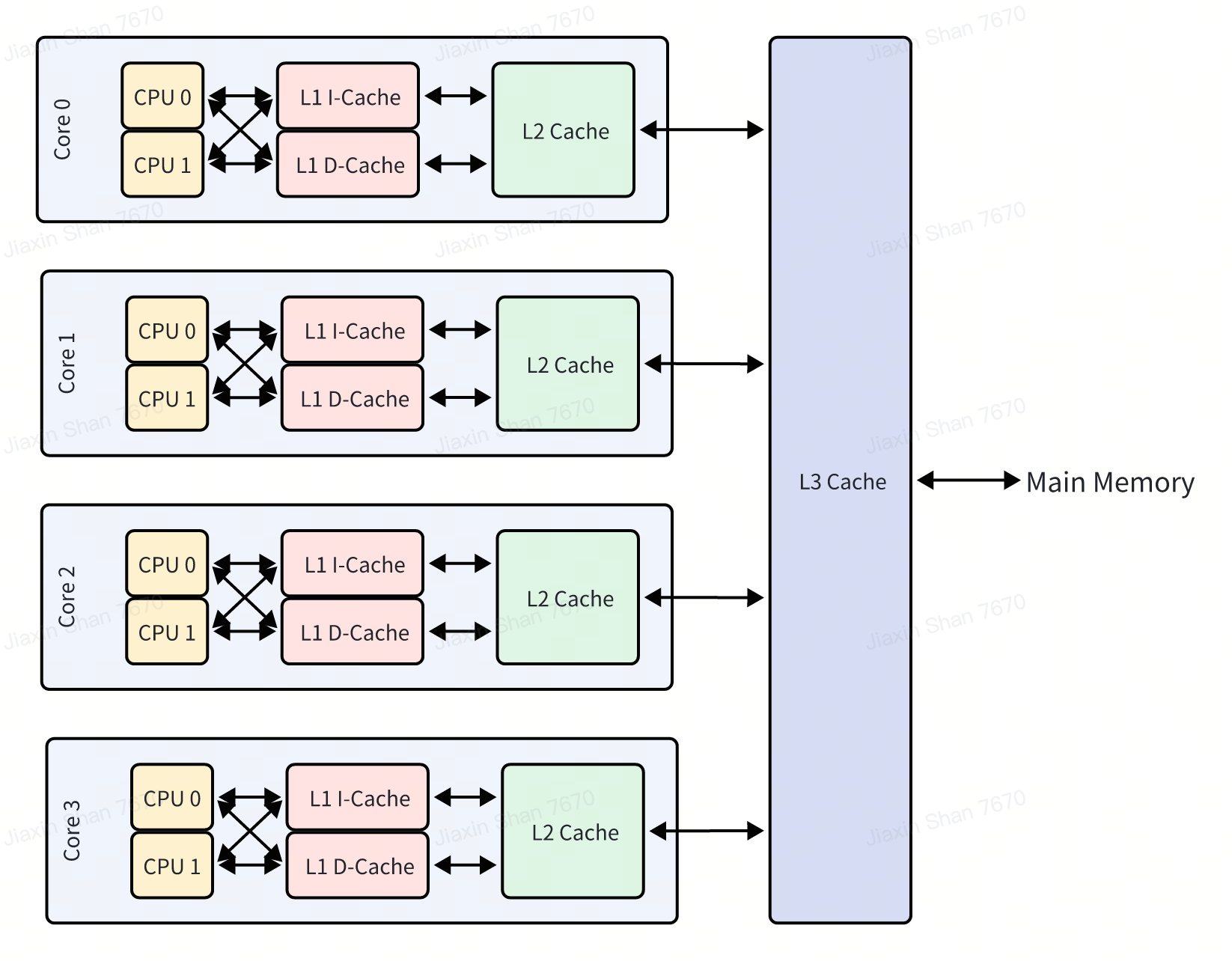

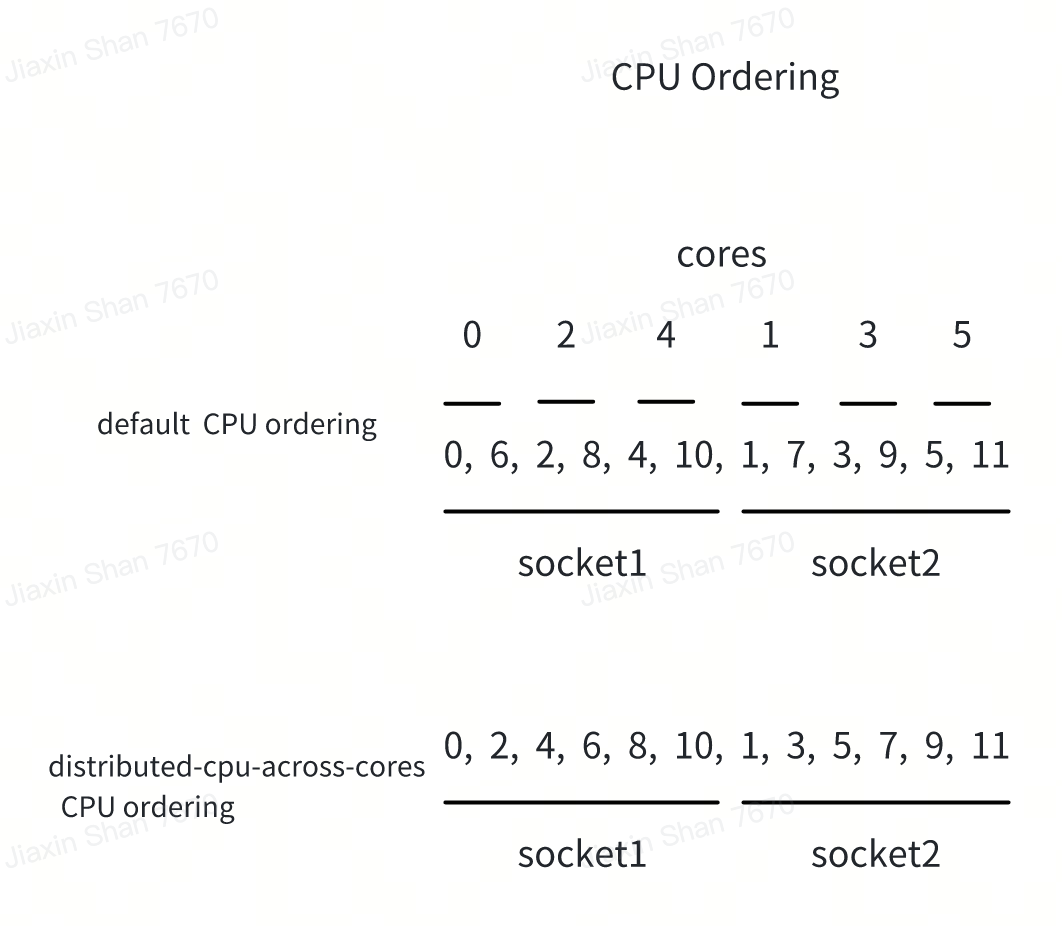

Kubernetes v1.31:全新的 Kubernetes CPUManager 静态策略:跨核分发 CPU

在 Kubernetes v1.31 中,我们很高兴引入了对 CPU 管理能力的重大增强:针对

CPUManager 静态策略的

distribute-cpus-across-cores 选项。此特性目前处于 Alpha 阶段,

默认被隐藏,标志着旨在优化 CPU 利用率和改善多核处理器系统性能的战略转变。

理解这一特性

传统上,Kubernetes 的 CPUManager 倾向于尽可能紧凑地分配 CPU,通常将这些 CPU 打包到尽可能少的物理核上。 然而,分配策略很重要,因为同一物理主机上的 CPU 仍然共享一些物理核的资源,例如缓存和执行单元等。

虽然默认方法可以最小化核间通信,并在某些情况下是有益的,但也带来了挑战。 在同一物理核上共享的 CPU 可能导致资源竞争,从而可能造成性能瓶颈,这在 CPU 密集型应用中尤为明显。

全新的 distribute-cpus-across-cores 特性通过修改分配策略来解决这个问题。

当此特性被启用时,此策略选项指示 CPUManager 尽可能将 CPU(硬件线程)分发到尽可能多的物理核上。

这种分发旨在最小化共享同一物理核的 CPU 之间的争用,从而通过为应用提供专用的核资源来潜在提高性能。

从技术上讲,在这个静态策略中,可用的 CPU 列表按照图示的方式重新排序,旨在从不同的物理核分配 CPU。

启用此特性

要启用此特性,用户首先需要在 kubelet 配置中添加 --cpu-manager-policy=static kubelet 标志或 cpuManagerPolicy: static 字段。

然后用户可以在 Kubernetes 配置中添加 --cpu-manager-policy-options distribute-cpus-across-cores=true 或

distribute-cpus-across-cores=true 到自己的 CPUManager 策略选项中。此设置指示 CPUManager 采用新的分发策略。

需要注意的是,目前此策略选项无法与 full-pcpus-only 或 distribute-cpus-across-numa 选项一起使用。

当前限制和未来方向

与所有新特性一样,尤其是处于 Alpha 阶段的特性,此特性也存在一些限制,很多方面还有待后续改进。

当前一个显著的限制是 distribute-cpus-across-cores 不能与可能在 CPU 分配策略上存在冲突的其他策略选项结合使用。

这一限制可能会影响与(依赖于更专业的资源管理的)某些工作负载和部署场景的兼容性。

展望未来,我们将致力于增强 distribute-cpus-across-cores 选项的兼容性和特性。

未来的更新将专注于解决这些兼容性问题,使此策略能够与其他 CPUManager 策略无缝结合。

我们的目标是提供一个更灵活和强大的 CPU 分配框架,能够适应各种工作负载和性能需求。

结论

在 Kubernetes CPUManager 中引入 distribute-cpus-across-cores 策略是我们持续努力改进资源管理和提升应用性能而向前迈出的一步。

通过减少物理核上的争用,此特性提供了更加平衡的 CPU 资源分配方法,特别有利于运行异构工作负载的环境。

我们鼓励 Kubernetes 用户测试这一新特性并提供反馈,这将对其未来发展至关重要。

本文旨在清晰地解释这一新特性,同时设定对其当前阶段和未来改进的期望。

进一步阅读

请查阅节点上的 CPU 管理策略任务页面, 以了解有关 CPU 管理器的更多信息,以及 CPU 管理器与其他节点级资源管理器的关系。

参与其中

此特性由 SIG Node 推动。 如果你有兴趣帮助开发此特性、分享反馈或参与其他目前 SIG Node 项目的工作,请参加 SIG Node 会议了解更多细节。

Kubernetes 1.31: 节点 Cgroup 驱动程序的自动配置 (beta)

一直以来,为新运行的 Kubernetes 集群配置正确的 cgroup 驱动程序是用户的一个痛点。

在 Linux 系统中,存在两种不同的 cgroup 驱动程序:cgroupfs 和 systemd。

过去,kubelet 和 CRI

实现(如 CRI-O 或 containerd)需要配置为使用相同的 cgroup 驱动程序, 否则 kubelet 会报错并退出。

这让许多集群管理员头疼不已。不过,现在曙光乍现!

自动检测 cgroup 驱动程序

在 v1.28.0 版本中,SIG Node 社区引入了 KubeletCgroupDriverFromCRI 特性门控,

它指示 kubelet 向 CRI 实现询问使用哪个 cgroup 驱动程序。在两个主要的 CRI 实现(containerd

和 CRI-O)增加对该功能的支持这段期间,Kubernetes 经历了几次小版本发布,但从 v1.31.0 版本开始,此功能现已进入 beta 阶段!

除了设置特性门控之外,集群管理员还需要确保 CRI 实现版本足够新:

- containerd:v2.0.0 版本开始支持

- CRI-O:v1.28.0 版本开始支持

然后,他们应该确保配置其 CRI 实现使用他们想要的 cgroup 驱动程序。

未来工作

最终,kubelet 对 cgroupDriver 配置字段的支持将会被移除,如果 CRI 实现的版本不够新,无法支持此功能,kubelet 将无法启动。

Kubernetes 1.31:流式传输从 SPDY 转换为 WebSocket

在 Kubernetes 1.31 中,kubectl 现在默认使用 WebSocket 协议而不是 SPDY 进行流式传输。

这篇文章介绍了这些变化对你意味着什么以及这些流式传输 API 的重要性。

Kubernetes 中的流式 API

在 Kubernetes 中,某些以 HTTP 或 RESTful 接口公开的某些端点会被升级为流式连接,因而需要使用流式协议。 与 HTTP 这种请求-响应协议不同,流式协议提供了一种持久的双向连接,具有低延迟的特点,并允许实时交互。 流式协议支持在客户端与服务器之间通过同一个连接进行双向的数据读写。 这种类型的连接非常有用,例如,当你从本地工作站在某个运行中的容器内创建 shell 并在该容器中运行命令时。

为什么要改变流式传输协议?

在 v1.31 版本发布之前,Kubernetes 默认使用 SPDY/3.1 协议来升级流式连接。

但是 SPDY/3.1 已经被废弃了八年之久,并且从未被标准化,许多现代代理、网关和负载均衡器已经不再支持该协议。

因此,当你尝试通过代理或网关访问集群时,可能会发现像 kubectl cp、kubectl attach、kubectl exec

和 kubectl port-forward 这样的命令无法正常工作。

从 Kubernetes v1.31 版本开始,SIG API Machinery 修改了 Kubernetes

客户端(如 kubectl)中用于这些命令的流式传输协议,将其改为更现代化的

WebSocket 流式传输协议。

WebSocket 协议是一种当前得到支持的标准流式传输协议,

它可以确保与不同组件及编程语言之间的兼容性和互操作性。

相较于 SPDY,WebSocket 协议更为广泛地被现代代理和网关所支持。

流式 API 的工作原理

Kubernetes 通过在原始的 HTTP 请求中添加特定的升级头字段来将 HTTP 连接升级为流式连接。

例如,在集群内的 nginx 容器上运行 date 命令的 HTTP 升级请求类似于以下内容:

$ kubectl exec -v=8 nginx -- date

GET https://127.0.0.1:43251/api/v1/namespaces/default/pods/nginx/exec?command=date…

Request Headers:

Connection: Upgrade

Upgrade: websocket

Sec-Websocket-Protocol: v5.channel.k8s.io

User-Agent: kubectl/v1.31.0 (linux/amd64) kubernetes/6911225

如果容器运行时支持 WebSocket 流式协议及其至少一个子协议版本(例如 v5.channel.k8s.io),

服务器会以代表成功的 101 Switching Protocols 状态码进行响应,并附带协商后的子协议版本:

Response Status: 101 Switching Protocols in 3 milliseconds

Response Headers:

Upgrade: websocket

Connection: Upgrade

Sec-Websocket-Accept: j0/jHW9RpaUoGsUAv97EcKw8jFM=

Sec-Websocket-Protocol: v5.channel.k8s.io

此时,原本用于 HTTP 协议的 TCP 连接已转换为流式连接。 随后,此 Shell 交互中的标准输入(STDIN)、标准输出(STDOUT)和标准错误输出(STDERR)数据 (以及终端重置大小数据和进程退出码数据)会通过这个升级后的连接进行流式传输。

如何使用新的 WebSocket 流式协议

如果你的集群和 kubectl 版本为 1.29 及以上版本,有两个控制面特性门控以及两个 kubectl 环境变量用来控制启用 WebSocket 而不是 SPDY 作为流式协议。 在 Kubernetes 1.31 中,以下所有特性门控均处于 Beta 阶段,并且默认被启用:

- 特性门控

TranslateStreamCloseWebsocketRequests.../exec.../attach

PortForwardWebsockets.../port-forward

- kubectl 特性控制环境变量

KUBECTL_REMOTE_COMMAND_WEBSOCKETSkubectl execkubectl cpkubectl attach

KUBECTL_PORT_FORWARD_WEBSOCKETSkubectl port-forward

如果你正在使用一个较旧的集群但可以管理其特性门控设置,

那么可以通过开启 TranslateStreamCloseWebsocketRequests(在 Kubernetes v1.29 中添加)

和 PortForwardWebsockets(在 Kubernetes v1.30 中添加)来尝试启用 Websocket 作为流式传输协议。

版本为 1.31 的 kubectl 可以自动使用新的行为,但你需要连接到明确启用了服务器端特性的集群。

了解有关流式 API 的更多信息

Kubernetes 1.31:针对 Job 的 Pod 失效策略进阶至 GA

这篇博文阐述在 Kubernetes 1.31 中进阶至 Stable 的 Pod 失效策略,还介绍如何在你的 Job 中使用此策略。

关于 Pod 失效策略

当你在 Kubernetes 上运行工作负载时,Pod 可能因各种原因而失效。 理想情况下,像 Job 这样的工作负载应该能够忽略瞬时的、可重试的失效,并继续运行直到完成。

要允许这些瞬时的失效,Kubernetes Job 需包含 backoffLimit 字段,

此字段允许你指定在 Job 执行期间你愿意容忍的 Pod 失效次数。然而,

如果你为 backoffLimit 字段设置了一个较大的值,并完全依赖这个字段,

你可能会发现,由于在满足 backoffLimit 条件之前 Pod 重启次数太多,导致运营成本发生不必要的增加。

在运行大规模的、包含跨数千节点且长时间运行的 Pod 的 Job 时,这个问题尤其严重。

Pod 失效策略扩展了回退限制机制,帮助你通过以下方式降低成本:

- 让你在出现不可重试的 Pod 失效时控制 Job 失败。

- 允许你忽略可重试的错误,而不增加

backoffLimit字段。

例如,通过忽略由节点体面关闭引起的 Pod 失效,你可以使用 Pod 失效策略在更实惠的临时机器上运行你的工作负载。

此策略允许你基于失效 Pod 中的容器退出码或 Pod 状况来区分可重试和不可重试的 Pod 失效。

它是如何工作的

你在 Job 规约中指定的 Pod 失效策略是一个规则的列表。

对于每个规则,你基于以下属性之一来定义匹配条件:

- 容器退出码:

onExitCodes属性。 - Pod 状况:

onPodConditions属性。

此外,对于每个规则,你要指定在 Pod 与此规则匹配时应采取的动作,可选动作为以下之一:

Ignore:不将失效计入backoffLimit或backoffLimitPerIndex。FailJob:让整个 Job 失败并终止所有运行的 Pod。FailIndex:与失效 Pod 对应的索引失效。

此动作与逐索引回退限制特性一起使用。Count:将失效计入backoffLimit或backoffLimitPerIndex。这是默认行为。

当在运行的 Job 中发生 Pod 失效时,Kubernetes 按所给的顺序将失效 Pod 的状态与 Pod 失效策略规则的列表进行匹配,并根据匹配的第一个规则采取相应的动作。

请注意,在指定 Pod 失效策略时,你还必须在 Job 的 Pod 模板中设置 restartPolicy: Never。

此字段可以防止在对 Pod 失效计数时在 kubelet 和 Job 控制器之间出现竞争条件。

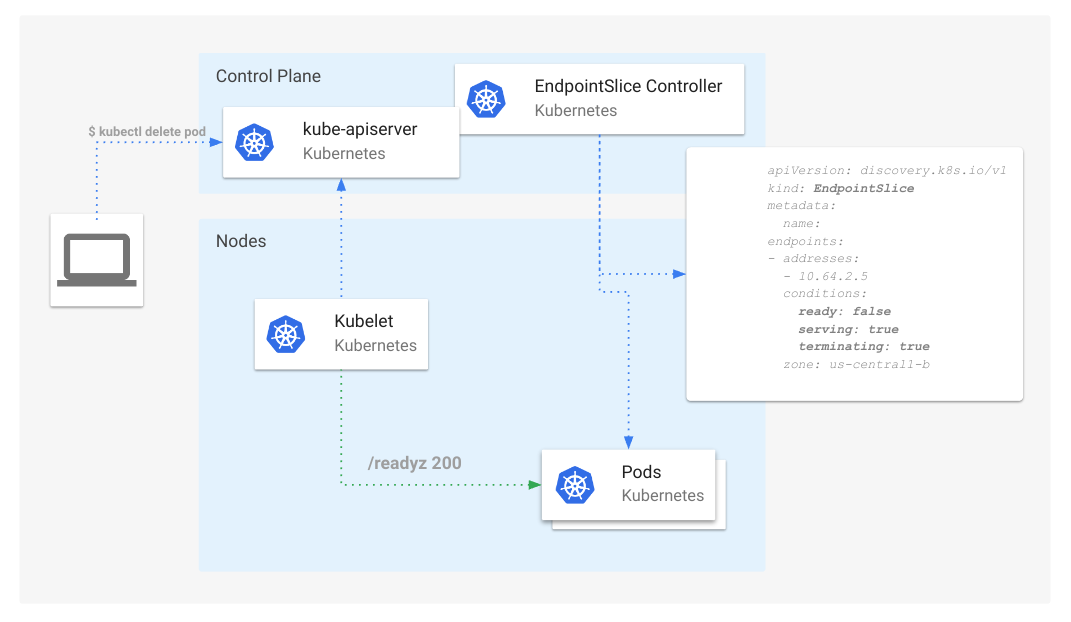

Kubernetes 发起的 Pod 干扰

为了允许将 Pod 失效策略规则与由 Kubernetes 引发的干扰所导致的失效进行匹配,

此特性引入了 DisruptionTarget Pod 状况。

Kubernetes 会将此状况添加到因可重试的干扰场景而失效的所有

Pod,无论其是否由 Job 控制器管理。其中 DisruptionTarget 状况包含与这些干扰场景对应的以下原因之一:

PreemptionByKubeScheduler:由kube-scheduler抢占以接纳更高优先级的新 Pod。DeletionByTaintManager- Pod 因其不容忍的NoExecute污点而被kube-controller-manager删除。EvictionByEvictionAPI- Pod 因为 API 发起的驱逐而被删除。DeletionByPodGC- Pod 被绑定到一个不再存在的节点,并将通过 Pod 垃圾收集而被删除。TerminationByKubelet- Pod 因节点体面关闭、 节点压力驱逐或被系统关键 Pod抢占

在所有其他干扰场景中,例如因超过

Pod 容器限制而驱逐,

Pod 不会收到 DisruptionTarget 状况,因为干扰可能是由 Pod 引起的,并且在重试时会再次发生干扰。

示例

下面的 Pod 失效策略片段演示了一种用法:

podFailurePolicy:

rules:

- action: Ignore

onPodConditions:

- type: DisruptionTarget

- action: FailJob

onPodConditions:

- type: ConfigIssue

- action: FailJob

onExitCodes:

operator: In

values: [ 42 ]

在这个例子中,Pod 失效策略执行以下操作:

- 忽略任何具有内置

DisruptionTarget状况的失效 Pod。这些 Pod 不计入 Job 回退限制。 - 如果任何失效的 Pod 具有用户自定义的、由自定义控制器或 Webhook 添加的

ConfigIssue状况,则让 Job 失败。 - 如果任何容器以退出码 42 退出,则让 Job 失败。

- 将所有其他 Pod 失效计入默认的

backoffLimit(在合适的情况下,计入backoffLimitPerIndex)。

进一步了解

- 有关使用 Pod 失效策略的实践指南, 参见使用 Pod 失效策略处理可重试和不可重试的 Pod 失效

- 阅读文档:Pod 失效策略和逐索引回退限制

- 阅读文档:Pod 干扰状况

- 阅读 KEP:Pod 失效策略

相关工作

基于 Pod 失效策略所引入的概念,正在进行中的进一步工作如下:

- JobSet 集成:可配置的失效策略 API

- 扩展 Pod 失效策略以添加更细粒度的失效原因

- 通过 JobSet 在 Kubeflow Training v2 中支持 Pod 失效策略

- 提案:受干扰的 Pod 应从端点中移除

参与其中

这项工作由 Batch Working Group(批处理工作组) 发起, 与 SIG Apps、 SIG Node 和 SIG Scheduling 社区密切合作。

如果你有兴趣处理这个领域中的新特性,建议你订阅我们的 Slack 频道,并参加定期的社区会议。

感谢

我想感谢在这些年里参与过这个项目的每个人。 这是一段旅程,也是一个社区共同努力的见证! 以下名单是我尽力记住并对此特性产生过影响的人。感谢大家!

- Aldo Culquicondor 在整个过程中提供指导和审查

- Jordan Liggitt 审查 KEP 和 API

- David Eads 审查 API

- Maciej Szulik 从 SIG Apps 角度审查 KEP

- Clayton Coleman 提供指导和 SIG Node 审查

- Sergey Kanzhelev 从 SIG Node 角度审查 KEP

- Dawn Chen 从 SIG Node 角度审查 KEP

- Daniel Smith 从 SIG API Machinery 角度进行审查

- Antoine Pelisse 从 SIG API Machinery 角度进行审查

- John Belamaric 审查 PRR

- Filip Křepinský 从 SIG Apps 角度进行全面审查并修复 Bug

- David Porter 从 SIG Node 角度进行全面审查

- Jensen Lo 进行早期需求讨论、测试和报告问题

- Daniel Vega-Myhre 推进 JobSet 集成并报告问题

- Abdullah Gharaibeh 进行早期设计讨论和指导

- Antonio Ojea 审查测试

- Yuki Iwai 审查并协调相关 Job 特性的实现

- Kevin Hannon 审查并协调相关 Job 特性的实现

- Tim Bannister 审查文档

- Shannon Kularathna 审查文档

- Paola Cortés 审查文档

Kubernetes 1.31:podAffinity 中的 matchLabelKeys 进阶至 Beta

Kubernetes 1.29 在 podAffinity 和 podAntiAffinity 中引入了新的字段 matchLabelKeys 和 mismatchLabelKeys。

在 Kubernetes 1.31 中,此特性进阶至 Beta,并且相应的特性门控(MatchLabelKeysInPodAffinity)默认启用。

matchLabelKeys - 为多样化滚动更新增强了调度

在工作负载(例如 Deployment)的滚动更新期间,集群中可能同时存在多个版本的 Pod。

然而,调度器无法基于 podAffinity 或 podAntiAffinity 中指定的 labelSelector 区分新旧版本。

结果,调度器将并置或分散调度 Pod,不会考虑这些 Pod 的版本。

这可能导致次优的调度结果,例如:

- 新版本的 Pod 与旧版本的 Pod(

podAffinity)并置在一起,这些旧版本的 Pod 最终将在滚动更新后被移除。 - 旧版本的 Pod 被分布在所有可用的拓扑中,导致新版本的 Pod 由于

podAntiAffinity无法找到节点。

matchLabelKeys 是一组 Pod 标签键,可以解决上述问题。

调度器从新 Pod 的标签中查找这些键的值,并将其与 labelSelector 结合,

以便 podAffinity 匹配到具有相同标签键值的 Pod。

通过在 matchLabelKeys 中使用标签

pod-template-hash,

你可以确保对 podAffinity 或 podAntiAffinity 进行评估时仅考虑相同版本的 Pod。

apiVersion: apps/v1

kind: Deployment

metadata:

name: application-server

...

affinity:

podAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchExpressions:

- key: app

operator: In

values:

- database

topologyKey: topology.kubernetes.io/zone

matchLabelKeys:

- pod-template-hash

上述 Pod 中的 matchLabelKeys 将被转换为:

kind: Pod

metadata:

name: application-server

labels:

pod-template-hash: xyz

...

affinity:

podAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchExpressions:

- key: app

operator: In

values:

- database

- key: pod-template-hash # 从 matchLabelKeys 添加; 只有来自同一 ReplicaSet 的 Pod 将与此亲和性匹配

operator: In

values:

- xyz

topologyKey: topology.kubernetes.io/zone

matchLabelKeys:

- pod-template-hash

mismatchLabelKeys - 服务隔离

mismatchLabelKeys 是一组 Pod 标签键,类似于 matchLabelKeys,

它在新 Pod 的标签中查找这些键的值,并将其与 labelSelector 合并为 key notin (value),

以便 podAffinity 不会匹配到具有相同标签键值的 Pod。

假设每个租户的所有 Pod 通过控制器或像 Helm 这样的清单管理工具得到 tenant 标签。

尽管在组合每个工作负载的清单时,tenant 标签的值是未知的,

但集群管理员希望实现租户与域之间形成排他性的 1:1 对应关系,以便隔离租户。

mismatchLabelKeys 适用于这一使用场景;

通过使用变更性质的 Webhook 在全局应用以下亲和性,

集群管理员可以确保来自同一租户的 Pod 将以独占方式落到同一域上,

这意味着来自其他租户的 Pod 不会落到同一域上。

affinity:

podAffinity: # 确保此租户的 Pod 落在同一节点池上

requiredDuringSchedulingIgnoredDuringExecution:

- matchLabelKeys:

- tenant

topologyKey: node-pool

podAntiAffinity: # 确保只有此租户的 Pod 落在同一节点池上

requiredDuringSchedulingIgnoredDuringExecution:

- mismatchLabelKeys:

- tenant

labelSelector:

matchExpressions:

- key: tenant

operator: Exists

topologyKey: node-pool

上述的 matchLabelKeys 和 mismatchLabelKeys 将被转换为:

kind: Pod

metadata:

name: application-server

labels:

tenant: service-a

spec:

affinity:

podAffinity: # 确保此租户的 Pod 落在同一节点池上

requiredDuringSchedulingIgnoredDuringExecution:

- matchLabelKeys:

- tenant

topologyKey: node-pool

labelSelector:

matchExpressions:

- key: tenant

operator: In

values:

- service-a

podAntiAffinity: # 确保只有此租户的 Pod 落在同一节点池上

requiredDuringSchedulingIgnoredDuringExecution:

- mismatchLabelKeys:

- tenant

labelSelector:

matchExpressions:

- key: tenant

operator: Exists

- key: tenant

operator: NotIn

values:

- service-a

topologyKey: node-pool

参与其中

这些特性由 Kubernetes SIG Scheduling 管理。

请加入我们并分享你的反馈。我们期待听到你的声音!

了解更多

Kubernetes 1.31:防止无序删除时 PersistentVolume 泄漏

PersistentVolume(简称 PV)

具有与之关联的回收策略。

回收策略用于确定在删除绑定到 PV 的 PVC 时存储后端需要采取的操作。当回收策略为 Delete 时,

期望存储后端释放为 PV 所分配的存储资源。实际上,在 PV 被删除时就需要执行此回收策略。

在最近发布的 Kubernetes v1.31 版本中,一个 Beta 特性允许你配置集群以这种方式运行并执行你配置的回收策略。

在以前的 Kubernetes 版本中回收是如何工作的?

PersistentVolumeClaim (简称 PVC)是用户对存储的请求。如果新创建了 PV 或找到了匹配的 PV,那么此 PV 和此 PVC 被视为已绑定。 PV 本身是由存储后端所分配的卷支持的。

通常,如果卷要被删除,对应的预期是为一个已绑定的 PV-PVC 对删除其中的 PVC。 不过,对于在删除 PVC 之前可否删除 PV 并没有限制。

首先,我将演示运行旧版本 Kubernetes 的集群的行为。

检索绑定到 PV 的 PVC

检索现有的 PVC example-vanilla-block-pvc:

kubectl get pvc example-vanilla-block-pvc

以下输出显示了 PVC 及其绑定的 PV;此 PV 显示在 VOLUME 列下:

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

example-vanilla-block-pvc Bound pvc-6791fdd4-5fad-438e-a7fb-16410363e3da 5Gi RWO example-vanilla-block-sc 19s

删除 PV

当我尝试删除已绑定的 PV 时,kubectl 会话被阻塞,

且 kubectl 工具不会将控制权返回给 Shell;例如:

kubectl delete pv pvc-6791fdd4-5fad-438e-a7fb-16410363e3da

persistentvolume "pvc-6791fdd4-5fad-438e-a7fb-16410363e3da" deleted

^C

检索 PV

kubectl get pv pvc-6791fdd4-5fad-438e-a7fb-16410363e3da

你可以观察到 PV 处于 Terminating 状态:

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pvc-6791fdd4-5fad-438e-a7fb-16410363e3da 5Gi RWO Delete Terminating default/example-vanilla-block-pvc example-vanilla-block-sc 2m23s

删除 PVC

kubectl delete pvc example-vanilla-block-pvc

如果 PVC 被成功删除,则会看到以下输出:

persistentvolumeclaim "example-vanilla-block-pvc" deleted

集群中的 PV 对象也被删除。当尝试检索 PV 时,你会观察到该 PV 已不再存在:

kubectl get pv pvc-6791fdd4-5fad-438e-a7fb-16410363e3da

Error from server (NotFound): persistentvolumes "pvc-6791fdd4-5fad-438e-a7fb-16410363e3da" not found

尽管 PV 被删除,但下层存储资源并未被删除,需要手动移除。

总结一下,与 PersistentVolume 关联的回收策略在某些情况下会被忽略。

对于 Bound 的 PV-PVC 对,PV-PVC 删除的顺序决定了回收策略是否被执行。

如果 PVC 先被删除,则回收策略被执行;但如果在删除 PVC 之前 PV 被删除,

则回收策略不会被执行。因此,外部基础设施中关联的存储资产未被移除。

Kubernetes v1.31 的 PV 回收策略

新的行为确保当用户尝试手动删除 PV 时,下层存储对象会从后端被删除。

如何启用新的行为?

要利用新的行为,你必须将集群升级到 Kubernetes v1.31 版本,并运行

CSI external-provisioner

v5.0.1 或更高版本。

工作方式

对于 CSI 卷,新的行为是通过在新创建和现有的 PV 上添加

Finalizer

external-provisioner.volume.kubernetes.io/finalizer 来实现的。

只有在后端存储被删除后,Finalizer 才会被移除。

下面是一个带 Finalizer 的 PV 示例,请注意 Finalizer 列表中的新 Finalizer:

kubectl get pv pvc-a7b7e3ba-f837-45ba-b243-dec7d8aaed53 -o yaml

apiVersion: v1

kind: PersistentVolume

metadata:

annotations:

pv.kubernetes.io/provisioned-by: csi.vsphere.vmware.com

creationTimestamp: "2021-11-17T19:28:56Z"

finalizers:

- kubernetes.io/pv-protection

- external-provisioner.volume.kubernetes.io/finalizer

name: pvc-a7b7e3ba-f837-45ba-b243-dec7d8aaed53

resourceVersion: "194711"

uid: 087f14f2-4157-4e95-8a70-8294b039d30e

spec:

accessModes:

- ReadWriteOnce

capacity:

storage: 1Gi

claimRef:

apiVersion: v1

kind: PersistentVolumeClaim

name: example-vanilla-block-pvc

namespace: default

resourceVersion: "194677"

uid: a7b7e3ba-f837-45ba-b243-dec7d8aaed53

csi:

driver: csi.vsphere.vmware.com

fsType: ext4

volumeAttributes:

storage.kubernetes.io/csiProvisionerIdentity: 1637110610497-8081-csi.vsphere.vmware.com

type: vSphere CNS Block Volume

volumeHandle: 2dacf297-803f-4ccc-afc7-3d3c3f02051e

persistentVolumeReclaimPolicy: Delete

storageClassName: example-vanilla-block-sc

volumeMode: Filesystem

status:

phase: Bound

Finalizer 防止此 PersistentVolume 从集群中被移除。如前文所述,Finalizer 仅在从存储后端被成功删除后才会从 PV 对象中被移除。进一步了解 Finalizer, 请参阅使用 Finalizer 控制删除。

同样,Finalizer kubernetes.io/pv-controller 也被添加到动态制备的树内插件卷中。

有关 CSI 迁移的卷

本次修复同样适用于 CSI 迁移的卷。

一些注意事项

本次修复不适用于静态制备的树内插件卷。

参考

我该如何参与?

Kubernetes Slack SIG Storage 交流频道是与 SIG Storage 和迁移工作组团队联系的良好媒介。

特别感谢以下人员的用心评审、周全考虑和宝贵贡献:

- Fan Baofa (carlory)

- Jan Šafránek (jsafrane)

- Xing Yang (xing-yang)

- Matthew Wong (wongma7)

如果你有兴趣参与 CSI 或 Kubernetes Storage 系统任何部分的设计和开发,请加入 Kubernetes Storage SIG。 我们正在快速成长,始终欢迎新的贡献者。

Kubernetes 1.31:基于 OCI 工件的只读卷 (Alpha)

Kubernetes 社区正朝着在未来满足更多人工智能(AI)和机器学习(ML)使用场景的方向发展。 虽然此项目在过去设计为满足微服务架构,但现在是时候听听最终用户的声音并引入更侧重于 AI/ML 的特性了。

其中一项需求是直接支持与开放容器倡议(OCI) 兼容的镜像和工件(称为 OCI 对象)作为原生卷源。 这使得用户能够专注于 OCI 标准,且能够使用 OCI 镜像仓库存储和分发任何内容。 与此类似的特性让 Kubernetes 项目有机会扩大其使用场景,不再局限于运行特定镜像。

在这一背景下,Kubernetes 社区自豪地展示在 v1.31 中引入的一项新的 Alpha 特性: 镜像卷源(KEP-4639)。 此特性允许用户在 Pod 中指定一个镜像引用作为卷,并在容器内将其作为卷挂载进行复用:

…

kind: Pod

spec:

containers:

- …

volumeMounts:

- name: my-volume

mountPath: /path/to/directory

volumes:

- name: my-volume

image:

reference: my-image:tag

上述示例的结果是将 my-image:tag 挂载到 Pod 的容器中的 /path/to/directory。

使用场景

此增强特性的目标是在尽可能贴近 kubelet 中现有的容器镜像实现的同时, 引入新的 API 接口以支持更广泛的使用场景。

例如,用户可以在 Pod 中的多个容器之间共享一个配置文件,而无需将此文件包含在主镜像中, 这样用户就可以将安全风险最小化和并缩减整体镜像大小。用户还可以使用 OCI 镜像打包和分发二进制工件, 并直接将它们挂载到 Kubernetes Pod 中,例如用户这样就可以简化其 CI/CD 流水线。

数据科学家、MLOps 工程师或 AI 开发者可以与模型服务器一起在 Pod 中挂载大语言模型权重或机器学习模型权重数据, 从而可以更高效地提供服务,且无需将这些模型包含在模型服务器容器镜像中。 他们可以将这些模型打包在 OCI 对象中,以利用 OCI 分发机制,还可以确保高效的模型部署。 这一新特性允许他们将模型规约/内容与处理它们的可执行文件分开。

另一个使用场景是安全工程师可以使用公共镜像作为恶意软件扫描器,并将私有的(商业的)恶意软件签名挂载到卷中, 这样他们就可以加载这些签名且无需制作自己的组合镜像(公共镜像的版权要求可能不允许这样做)。 签名数据文件与操作系统或扫描器软件版本无关,总是可以被使用。

但就长期而言,作为此项目的最终用户的你要负责为这一新特性的其他重要使用场景给出规划。 SIG Node 乐于接收与进一步增强此特性以适应更高级的使用场景有关的所有反馈或建议。你可以通过使用 Kubernetes Slack(#sig-node) 频道或 SIG Node 邮件列表提供反馈。

详细示例

你需要在 API 服务器以及

kubelet 上启用

Kubernetes Alpha 特性门控 ImageVolume,

才能使其正常工作。如果启用了此特性,

并且容器运行时支持此特性

(如 CRI-O ≥ v1.31),那就可以创建这样一个示例 pod.yaml:

apiVersion: v1

kind: Pod

metadata:

name: pod

spec:

containers:

- name: test

image: registry.k8s.io/e2e-test-images/echoserver:2.3

volumeMounts:

- name: volume

mountPath: /volume

volumes:

- name: volume

image:

reference: quay.io/crio/artifact:v1

pullPolicy: IfNotPresent

此 Pod 使用值为 quay.io/crio/artifact:v1 的 image.reference 声明一个新卷,

该字段值引用了一个包含两个文件的 OCI 对象。pullPolicy 的行为与容器镜像相同,允许以下值:

Always:kubelet 总是尝试拉取引用,如果拉取失败,容器创建将失败。Never:kubelet 从不拉取引用,只使用本地镜像或工件。如果引用不存在,容器创建将失败。IfNotPresent:kubelet 会在引用已不在磁盘上时进行拉取。如果引用不存在且拉取失败,容器创建将失败。

volumeMounts 字段表示名为 test 的容器应将卷挂载到 /volume 路径下。

如果你现在创建 Pod:

kubectl apply -f pod.yaml

然后通过 exec 进入此 Pod:

kubectl exec -it pod -- sh

那么你就能够查看已挂载的内容:

/ # ls /volume

dir file

/ # cat /volume/file

2

/ # ls /volume/dir

file

/ # cat /volume/dir/file

1

你已经成功地使用 Kubernetes 访问了 OCI 工件!

容器运行时拉取镜像(或工件),将其挂载到容器中,并最终使其可被直接使用。 在实现中有很多细节,这些细节与 kubelet 现有的镜像拉取行为密切相关。例如:

- 如果提供给

reference的值包含:latest标签,pullPolicy将默认为Always, 而在任何其他情况下,pullPolicy在未被设置的情况下都默认为IfNotPresent。 - 如果 Pod 被删除并重新创建,卷将被重新解析,这意味着在 Pod 重新创建时将可以访问新的远端内容。 如果在 Pod 启动期间未能解析或未能拉取镜像,将会容器启动会被阻止,并可能显著增加延迟。 如果拉取镜像失败,将使用正常的卷回退机制进行重试,并将在 Pod 的原因和消息中报告出错原因。

- 拉取 Secret 的组装方式与容器镜像所用的方式相同,也是通过查找节点凭据、服务账户镜像拉取 Secret 和 Pod 规约中的镜像拉取 Secret 来完成。

- OCI 对象被挂载到单个目录中,清单层的合并方式与容器镜像相同。

- 卷以只读(

ro)和非可执行文件(noexec)的方式被挂载。

- 容器的子路径挂载不被支持(

spec.containers[*].volumeMounts.subpath)。 - 字段

spec.securityContext.fsGroupChangePolicy对这种卷类型没有影响。 - 如果已启用,此特性也将与

AlwaysPullImages准入插件一起工作。

感谢你阅读到这篇博客文章的结尾!对于将此特性作为 Kubernetes v1.31 的一部分交付,SIG Node 感到很高兴也很自豪。

作为这篇博客的作者,我想特别感谢所有参与者!你们都很棒,让我们继续开发之旅!

进一步阅读

Kubernetes 1.31:通过 VolumeAttributesClass 修改卷进阶至 Beta

在 Kubernetes 中,卷由两个属性描述:存储类和容量。存储类是卷的不可变属性, 而容量可以通过卷调整大小进行动态变更。

这使得使用卷的工作负载的垂直扩缩容变得复杂。 虽然云厂商和存储供应商通常提供了一些允许指定注入 IOPS 或吞吐量等 IO 服务质量(性能)参数的卷,并允许在工作负载运行期间调整这些参数,但 Kubernetes 没有提供用来更改这些参数的 API。

我们很高兴地宣布,自 Kubernetes 1.29 起以 Alpha 引入的 VolumeAttributesClass KEP 将在 1.31 中进入 Beta 阶段。这一机制提供了一个通用的、Kubernetes 原生的 API, 可用来修改诸如所提供的 IO 能力这类卷参数。

类似于 Kubernetes 中所有新的卷特性,此 API 是通过容器存储接口(CSI)实现的。 除了 VolumeAttributesClass 特性门控外,特定于制备器的 CSI 驱动还必须支持此特性在 CSI 一侧的全新的 ModifyVolume API。

有关细节请参阅完整文档。 在这里,我们展示了常见的工作流程。

动态修改卷属性

VolumeAttributesClass 是一个集群范围的资源,用来指定特定于制备器的属性。

这些属性由集群管理员创建,方式上与存储类相同。

例如,你可以为卷创建一系列金、银和铜级别的卷属性类,以区隔不同级别的 IO 能力。

apiVersion: storage.k8s.io/v1alpha1

kind: VolumeAttributesClass

metadata:

name: silver

driverName: your-csi-driver

parameters:

provisioned-iops: "500"

provisioned-throughput: "50MiB/s"

---

apiVersion: storage.k8s.io/v1alpha1

kind: VolumeAttributesClass

metadata:

name: gold

driverName: your-csi-driver

parameters:

provisioned-iops: "10000"

provisioned-throughput: "500MiB/s"

属性类的添加方式与存储类类似。

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: test-pv-claim

spec:

storageClassName: any-storage-class

volumeAttributesClassName: silver

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 64Gi

与存储类不同,卷属性类可以被更改:

kubectl patch pvc test-pv-claim -p '{"spec": "volumeAttributesClassName": "gold"}'

Kubernetes 将与 CSI 驱动协作来更新卷的属性。 PVC 的状态将跟踪当前和所需的属性类。 PV 资源也将依据新的卷属性类完成更新,卷属性类也会被依据 PV 当前活跃的属性完成设置。

Beta 阶段的限制

作为一个 Beta 特性,仍有一些特性计划在 GA 阶段推出,但尚未实现。最大的限制是配额支持,详见 KEP 和 sig-storage 中的讨论。

有关此特性在 CSI 驱动中的最新支持信息,请参阅 Kubernetes CSI 驱动列表。

Kubernetes 1.31:对 cgroup v1 的支持转为维护模式

随着 Kubernetes 不断发展,为了适应容器编排全景图的变化,社区决定在 v1.31 中将对 cgroup v1 的支持转为维护模式。 这一转变与行业更广泛地向 cgroup v2 的迁移保持一致,后者的功能更强, 包括可扩展性和更加一致的接口。在我们深入探讨对 Kubernetes 的影响之前, 先回顾一下 cgroup 的概念及其在 Linux 中的重要意义。

理解 cgroup

控制组(Control Group)也称为 cgroup, 是 Linux 内核的一项特性,允许在进程之间分配、划分优先级、拒绝和管理系统资源(如 CPU、内存、磁盘 I/O 和网络带宽)。 这一功能对于维护系统性能至关重要,确保没有单个进程能够垄断系统资源,这在多租户环境中尤其重要。

cgroup 有两个版本: v1 和 v2。 虽然 cgroup v1 提供了足够的资源管理能力,但其局限性促使了 cgroup v2 的开发。 cgroup v2 在更好的资源控制特性之外提供了更统一且更一致的接口。

Kubernetes 中的 cgroup

对于 Linux 节点,Kubernetes 在管理和隔离 Pod 中运行的容器所消耗的资源方面高度依赖 cgroup。 Kubernetes 中的每个容器都放在其自己的 cgroup 中,这使得 Kubernetes 能够强制执行资源限制、 监控使用情况并确保所有容器之间的资源公平分配。

Kubernetes 如何使用 cgroup

- 资源分配

- 确保容器不超过其分配的 CPU 和内存限制。

- 隔离

- 将容器相互隔离,防止资源争用。

- 监控

- 跟踪每个容器的资源使用情况,以提供洞察数据和指标。

向 cgroup v2 过渡

Linux 社区一直在聚焦于为 cgroup v2 提供新特性和各项改进。 主要的 Linux 发行版和像 systemd 这样的项目正在过渡到 cgroup v2。 使用 cgroup v2 相较于使用 cgroup v1 提供了多个好处,例如统一的层次结构、改进的接口、更好的资源控制, 以及 cgroup 感知的 OOM 杀手、 非 root 支持等。

鉴于这些优势,Kubernetes 也正在更全面地转向 cgroup v2。然而, 这一过渡需要谨慎处理,以避免干扰现有的工作负载,并为用户提供平滑的迁移路径。

对 cgroup v1 的支持转入维护模式

维护模式意味着什么?

当 cgroup v1 在 Kubernetes 中被置于维护模式时,这意味着:

- 特性冻结:不会再向 cgroup v1 添加新特性。

- 安全修复:仍将提供关键的安全修复。

- 尽力而为的 Bug 修复:在可行的情况下可能会修复重大 Bug,但某些问题可能保持未解决。

为什么要转入维护模式?

转入维护模式的原因是为了与更广泛的生态体系保持一致,也为了鼓励采用 cgroup v2,后者提供了更好的性能、安全性和可用性。 通过将 cgroup v1 转入维护模式,Kubernetes 可以专注于增强对 cgroup v2 的支持,并确保其满足现代工作负载的需求。 需要注意的是,维护模式并不意味着弃用;cgroup v1 将继续按需进行关键的安全修复和重大 Bug 修复。

这对集群管理员意味着什么

目前强烈鼓励那些依赖 cgroup v1 的用户做好向 cgroup v2 过渡的计划。这一过渡涉及:

- 升级系统:确保底层操作系统和容器运行时支持 cgroup v2。

- 测试工作负载:验证工作负载和应用程序在 cgroup v2 下正常工作。

进一步阅读

Kubernetes v1.31: Elli

编辑: Matteo Bianchi, Yigit Demirbas, Abigail McCarthy, Edith Puclla, Rashan Smith

Kubernetes v1.31:Elli 宣布发布!

与之前的版本类似,Kubernetes v1.31 的发布中引入了新的稳定版、Beta 版和 Alpha 特性功能。 持续提供高质量的版本彰显了我们开发周期的强劲实力以及社区的大力支持。 此版本包含 45 项增强功能。 在这些增强功能中,11 项已升级到稳定版,22 项正在进入 Beta 版,12 项已升级到 Alpha 版。

发布主题和 logo

Kubernetes v1.31 的发布主题是 "Elli"。

Kubernetes v1.31 的 Elli 是一只可爱欢快的小狗,戴着一顶漂亮的水手帽,这是对庞大而多样化的 Kubernetes 贡献者家族的一个俏皮致意。

Kubernetes v1.31 标志着该项目成功庆祝其诞生十周年后的首次发布。 自诞生以来,Kubernetes 已经走过了漫长的道路,并且每次发布都在朝着令人兴奋的新方向前进。 十年后,回顾无数 Kubernetes 贡献者为实现这一目标所付出的努力、奉献、技能、智慧和辛勤工作,令人敬畏。

还有,尽管运营项目需要付出巨大的努力,仍然有大量的人不断以热情、微笑和自豪感出现,为社区做出贡献并成为其中的一员。 我们从新老贡献者那里看到的这种"精神"是一个充满活力的社区的标志,我们可以称之为"欢乐"的社区。

Kubernetes v1.31 的 Elli 就是为了庆祝这种美好的精神!让我们为 Kubernetes 的下一个十年干杯!

晋级为稳定版的功能亮点

以下是 v1.31 发布后晋级为稳定版的部分改进。

AppArmor 支持现已稳定

Kubernetes 对 AppArmor 的支持现已正式发布。通过在容器的 securityContext 中设置 appArmorProfile.type 字段,可以使用 AppArmor 保护您的容器。

请注意,在 Kubernetes v1.30 之前,AppArmor 是通过注解控制的;从 v1.30 开始,它是通过字段控制的。

建议您停止使用注解,开始使用 appArmorProfile.type 字段。

要了解更多信息,请阅读 AppArmor 教程。 这项工作是作为 KEP #24 的一部分由 SIG Node 完成的。

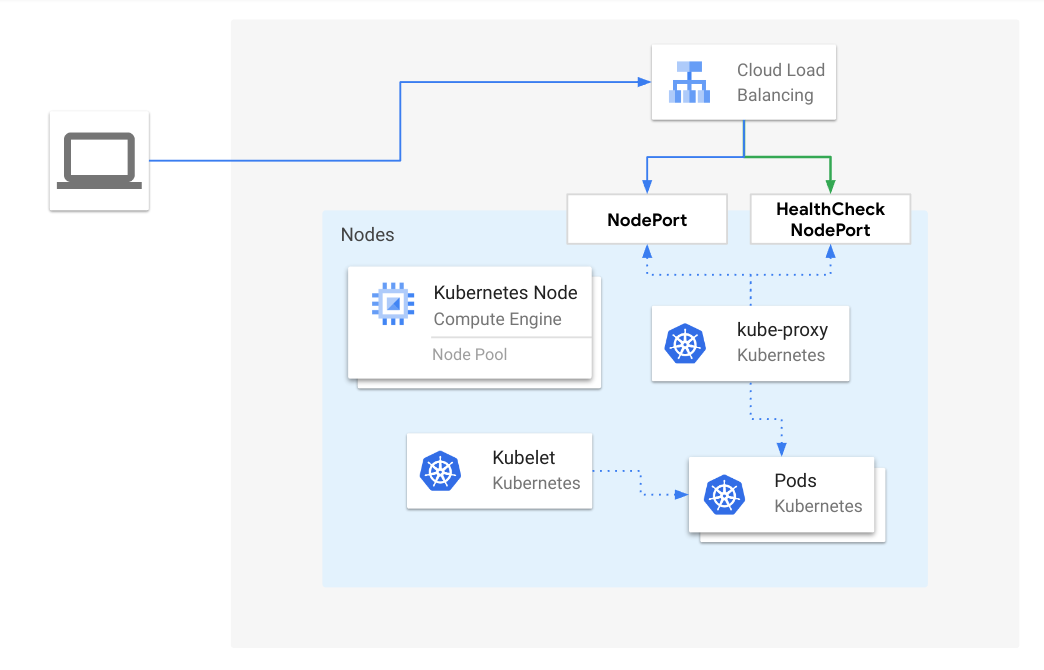

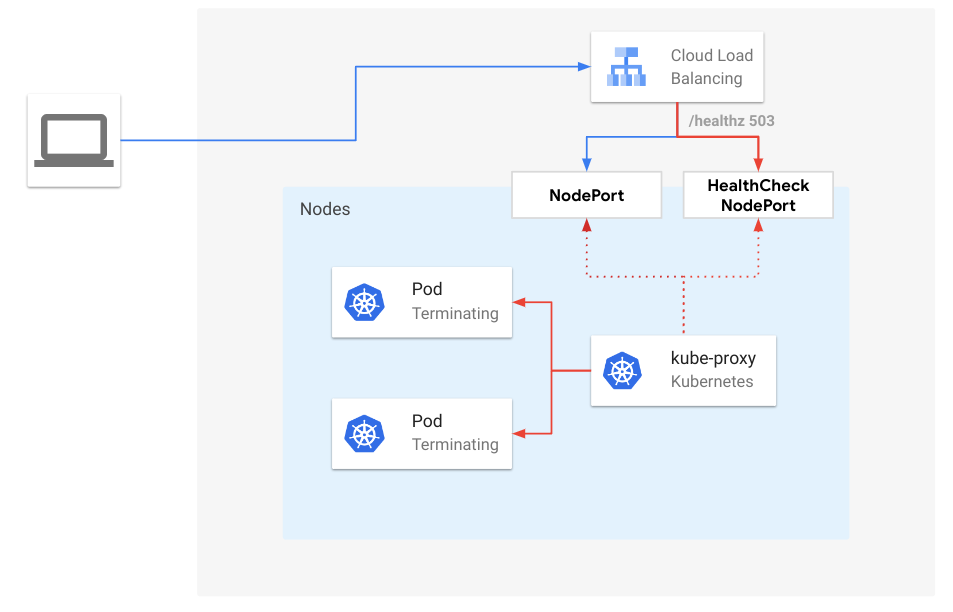

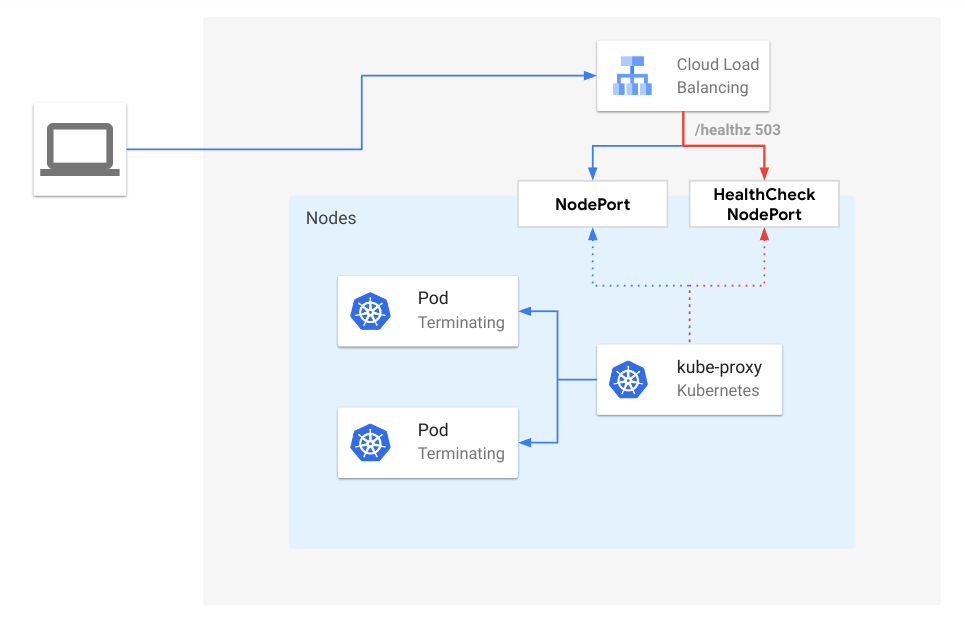

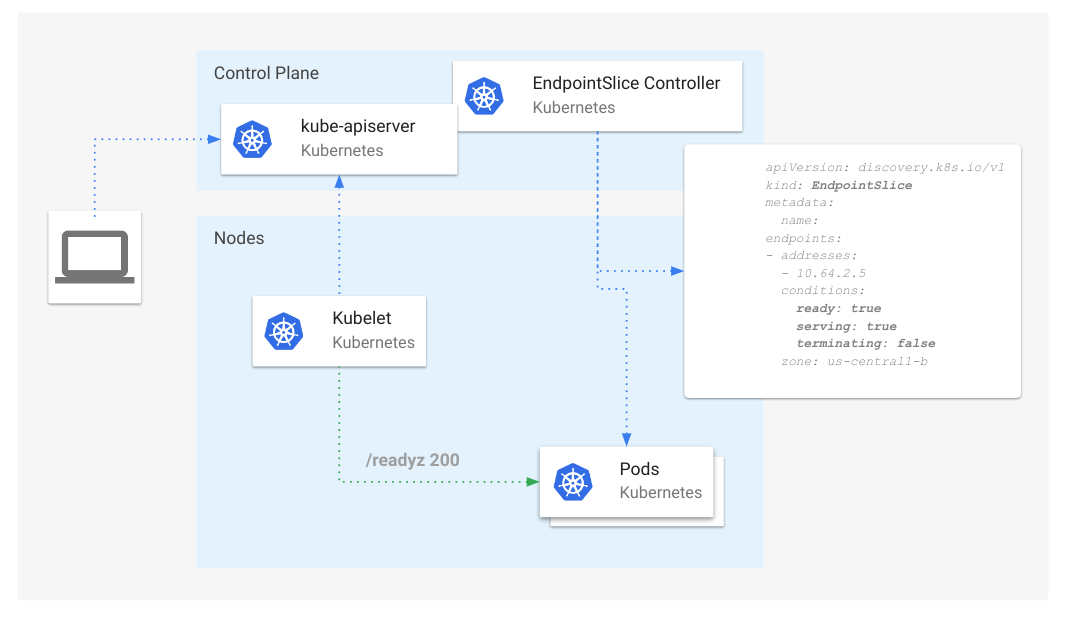

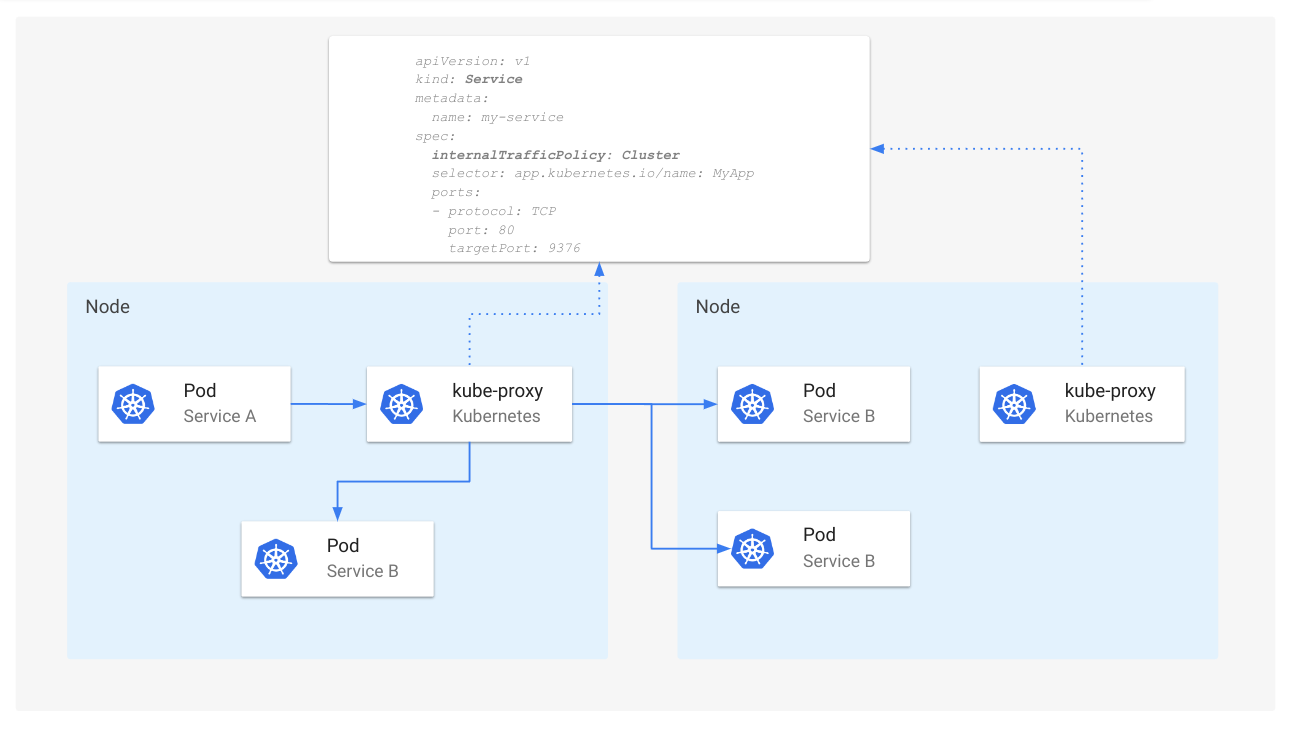

改进 kube-proxy 的入站连接可靠性

kube-proxy 改进的入站连接可靠性在 v1.31 中已稳定。

Kubernetes 中负载均衡器的一个常见问题是为避免流量丢失而在不同组件之间进行同步的机制。

此特性在 kube-proxy 中实现了一种机制,用于负载均衡器对 type: LoadBalancer 和 externalTrafficPolicy: Cluster

服务所公开的、进入终止进程的 Node 进行连接排空,并为云提供商和 Kubernetes 负载均衡器实现建立了一些最佳实践。

要使用此特性,kube-proxy 需要在集群上作为默认服务代理运行,并且负载均衡器需要支持连接排空。 使用此特性不需要进行特定的更改,它自 v1.30 以来在 kube-proxy 中默认启用,并在 v1.31 中晋级为稳定版。

有关此特性的更多详细信息,请访问虚拟 IP 和服务代理文档页面。

这项工作是作为 KEP #3836 的一部分由 SIG Network 完成的。

持久卷最近阶段转换时间

持久卷最近阶段转换时间功能在 v1.31 中晋级为正式版(GA)。

此特性添加了一个 PersistentVolumeStatus 字段,用于保存 PersistentVolume 最近转换到不同阶段的时间戳。

启用此特性后,每个 PersistentVolume 对象将有一个新字段 .status.lastTransitionTime 保存卷最近转换阶段的时间戳。

这种变化并不是立即的;新字段将在 PersistentVolume 更新并在升级到 Kubernetes v1.31 后首次在各阶段(Pending、Bound 或 Released)之间转换时填充。

这允许您测量 PersistentVolume 从 Pending 移动到 Bound 之间的时间。这对于提供指标和 SLO 也很有用。

有关此特性的更多详细信息,请访问 PersistentVolume 文档页面。

这项工作是作为 KEP #3762 的一部分由 SIG Storage 完成的。

晋级为 Beta 版的功能亮点

以下是 v1.31 发布后晋级为 Beta 版的部分改进。

kube-proxy 的 nftables 后端

nftables 后端在 v1.31 中晋级为 Beta 版,由 NFTablesProxyMode 特性门控控制,现在默认启用。

nftables API 是 iptables API 的继任者,旨在提供比 iptables 更好的性能和可扩展性。

nftables 代理模式能够比 iptables 模式更快、更高效地处理服务端点的变化,并且在内核中也能更高效地处理数据包(尽管这只有在拥有数万个服务的集群中才会显著)。

截至 Kubernetes v1.31,nftables 模式仍相对较新,可能与某些网络插件不兼容;请查阅您的网络插件文档。 此代理模式仅在 Linux 节点上可用,并且需要内核 5.13 或更高版本。 在迁移之前,请注意某些功能,特别是与 NodePort 服务相关的功能,在 nftables 模式下的实现方式与 iptables 模式不完全相同。 查看迁移指南以了解是否需要覆盖默认配置。

这项工作是作为 KEP #3866 的一部分由 SIG Network 完成的。

PersistentVolumes 回收策略的变更

始终遵循 PersistentVolume 回收策略这一特性在 Kubernetes v1.31 中晋级为 Beta 版。 这项增强确保即使在所关联的 PersistentVolumeClaim (PVC) 被删除后,PersistentVolume (PV) 回收策略也会被遵循,从而防止卷的泄漏。

在此特性之前,与 PV 相关联的回收策略可能在特定条件下被忽视,这取决于 PV 或 PVC 是否先被删除。 因此,即使回收策略设置为 "Delete",外部基础设施中相应的存储资源也可能不会被删除。 这导致了潜在的不一致性和资源泄漏。

随着这项功能的引入,Kubernetes 现在保证 "Delete" 回收策略将被执行,确保底层存储对象从后端基础设施中删除,无论 PV 和 PVC 的删除顺序如何。

这项工作是作为 KEP #2644 的一部分由 SIG Storage 完成的。

绑定服务账户令牌的改进

ServiceAccountTokenNodeBinding 功能在 v1.31 中晋级为 Beta 版。

此特性允许请求仅绑定到节点而不是 Pod 的令牌,在令牌中包含节点信息的声明,并在使用令牌时验证节点的存在。

有关更多信息,请阅读绑定服务账户令牌文档。

这项工作是作为 KEP #4193 的一部分由 SIG Auth 完成的。

多个 Service CIDR

支持具有多个服务 CIDR 的集群在 v1.31 中晋级为 Beta 版(默认禁用)。

Kubernetes 集群中有多个组件消耗 IP 地址: Node、Pod 和 Service。 Node 和 Pod 的 IP 范围可以动态更改,因为它们分别取决于基础设施或网络插件。 然而,Service IP 范围是在集群创建期间作为 kube-apiserver 中的硬编码标志定义的。 IP 耗尽一直是长期存在或大型集群的问题,因为管理员需要扩展、缩小甚至完全替换分配的服务 CIDR 范围。 这些操作从未得到原生支持,并且是通过复杂和精细的维护操作执行的,经常导致集群无法正常服务。 这个新特性允许用户和集群管理员以零中断时间动态修改服务 CIDR 范围。

有关此特性的更多详细信息,请访问虚拟 IP 和服务代理文档页面。

这项工作是作为 KEP #1880 的一部分由 SIG Network 完成的。

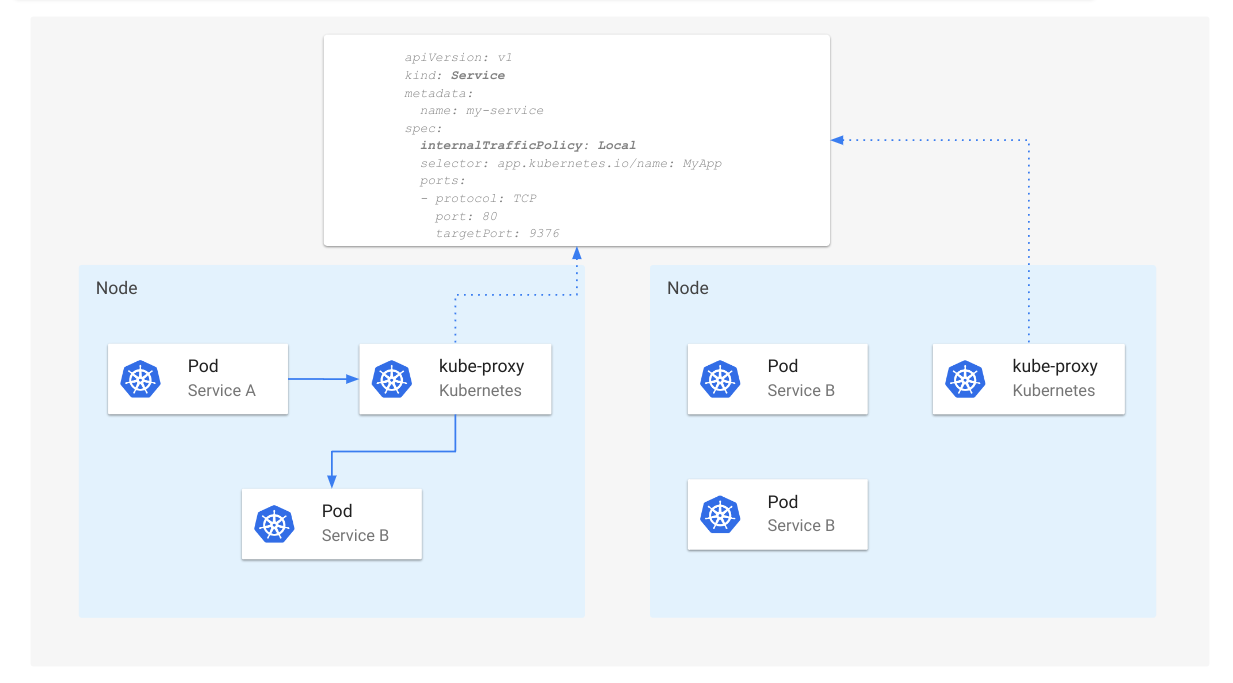

Service 的流量分配

Service 的流量分配在 v1.31 中晋级为 Beta 版,并默认启用。

为实现 Service 联网的最佳用户体验和流量工程能力,经过多次迭代后,SIG Networking 在服务规约中实现了

trafficDistribution 字段,作为底层实现在做出路由决策时考虑的指导原则。

有关此特性的更多详细信息,请阅读 1.30 发布博客 或访问 Service 文档页面。

这项工作是作为 KEP #4444 的一部分由 SIG Network 完成的。

Kubernetes VolumeAttributesClass ModifyVolume

VolumeAttributesClass API 在 v1.31 中晋级为 Beta 版。 VolumeAttributesClass 提供了一个通用的、Kubernetes 原生的 API,用于修改动态卷参数,如所提供的 IO 能力。 这允许工作负载在线垂直扩展其卷,以平衡成本和性能(如果提供商支持)。 该功能自 Kubernetes 1.29 以来一直处于 Alpha 状态。

这项工作是作为 KEP #3751 的一部分完成的,由 SIG Storage 领导。

Alpha 版的新功能

以下是 v1.31 发布后晋级为 Alpha 版的部分改进。

用于更好管理加速器和其他硬件的新 DRA API

Kubernetes v1.31 带来了更新的动态资源分配(DRA)API 和设计。 此次更新的主要焦点是结构化参数,因为它们使资源信息和请求对 Kubernetes 和客户端透明,并能够实现集群自动扩缩容等功能。 kubelet 中的 DRA 支持已更新,使得 kubelet 和控制平面之间的版本偏差成为可能。通过结构化参数,调度器在调度 Pod 时分配 ResourceClaims。 通过现在称为"经典 DRA"的方式,仍然支持由 DRA 驱动程序控制器进行分配。

从 Kubernetes v1.31 开始,经典 DRA 有一个单独的特性门控名为 DRAControlPlaneController,您需要显式启用它。

通过这样的控制平面控制器,DRA 驱动程序可以实现尚未通过结构化参数支持的分配策略。

这项工作是作为 KEP #3063 的一部分由 SIG Node 完成的。

对镜像卷的支持

Kubernetes 社区正在朝着在未来满足更多人工智能(AI)和机器学习(ML)用例的方向发展。

满足这些用例的要求之一是直接将开放容器倡议(OCI)兼容的镜像和工件(称为 OCI 对象)作为原生卷源支持。 这允许用户专注于 OCI 标准,并使他们能够使用 OCI 注册表存储和分发任何内容。

鉴于此,v1.31 添加了一个新的 Alpha 特性,允许在 Pod 中使用 OCI 镜像作为卷。

此特性允许用户在 pod 中指定镜像引用作为卷,同时在容器内重用它作为卷挂载。您需要启用 ImageVolume 特性门控才能尝试此特性。

这项工作是作为 KEP #4639 的一部分由 SIG Node 和 SIG Storage 完成的。

通过 Pod 状态暴露设备健康信息

通过 Pod 状态暴露设备健康信息作为新的 Alpha 特性添加到 v1.31 中,默认被禁用。

在 Kubernetes v1.31 之前,了解 Pod 是否与故障设备关联的方法是使用 PodResources API。

通过启用此特性,字段 allocatedResourcesStatus 将添加到每个容器状态中,在每个 Pod 的 .status 内。

allocatedResourcesStatus 字段报告分配给容器的各个设备的健康信息。

这项工作是作为 KEP #4680 的一部分由 SIG Node 完成的。

基于选择算符的细粒度鉴权

此特性允许 Webhook 鉴权组件和未来(但目前尚未设计)的树内鉴权组件允许 list 和 watch 请求,

前提是这些请求使用标签和/或字段选择算符。

例如,现在鉴权组件可以表达:此用户不能列出所有 Pod,但可以列举所有 .spec.nodeName 匹配某个特定值的 Pod。

或者允许用户监视命名空间中所有未标记为 confidential: true 的 Secret。

结合 CRD 字段选择器(在 v1.31 中也晋级为 Beta 版),可以编写更安全的节点级别扩展。

这项工作是作为 KEP #4601 的一部分由 SIG Auth 完成的。

对匿名 API 访问的限制

通过启用特性门控 AnonymousAuthConfigurableEndpoints,用户现在可以使用身份认证配置文件来配置可以通过匿名请求访问的端点。

这允许用户保护自己免受 RBAC 错误配置的影响;错误的配置可能会给匿名用户提供对集群的更多访问权限。

这项工作是作为 KEP #4633 的一部分由 SIG Auth 完成的。

1.31 中的晋级、弃用和移除

晋级为稳定版

以下列出了所有晋级为稳定版(也称为 正式可用 )的功能。有关包括新功能和从 Alpha 晋级到 Beta 的完整列表,请参阅发行说明。

此版本包括总共 11 项晋级为稳定版的增强:

- PersistentVolume 最后阶段转换时间

- Metric 基数强制执行

- Kube-proxy 改进的入站连接可靠性

- 将 CDI 设备添加到设备插件 API

- 将 cgroup v1 支持移入维护模式

- AppArmor 支持

- PodDisruptionBudget 的 PodHealthyPolicy

- Job 的可重试和不可重试 Pod 失败

- 弹性的带索引的 Job

- 允许 StatefulSet 控制起始副本序号编号

- ReplicaSet 缩小时随机选择 Pod

弃用和移除

随着 Kubernetes 的发展和成熟,某些特性可能会被弃用、移除或替换为更好的特性,以确保项目的整体健康。 有关此过程的更多详细信息,请参阅 Kubernetes 弃用和移除策略。

Cgroup v1 进入维护模式

随着 Kubernetes 继续发展并适应容器编排不断变化的格局,社区决定在 v1.31 中将 cgroup v1 支持移入维护模式。 这一转变与行业中普遍向 cgroup v2 迁移的趋势一致, 提供了改进的功能、可扩展性和更一致的接口。 Kubernetes 维护模式意味着不会向 cgroup v1 支持添加新功能。 社区仍将提供关键的安全修复,但是,错误修复现在是尽力而为。 这意味着如果可行,可能会修复重大错误,但某些问题可能保持未解决状态。

建议您尽快开始切换到使用 cgroup v2。 这种转变取决于您的架构,包括确保底层操作系统和容器运行时支持 cgroup v2,以及测试工作负载以验证工作负载和应用程序在 cgroup v2 下是否正常运行。

如果遇到任何问题,请通过提交 issue 进行报告。

这项工作是作为 KEP #4569 的一部分由 SIG Node 完成的。

关于 SHA-1 签名支持的说明

在 go1.18(2022 年 3 月发布)中,crypto/x509 库开始拒绝使用 SHA-1 哈希函数签名的证书。

虽然 SHA-1 已被确定为不安全,并且公共信任的证书颁发机构自 2015 年以来就不再颁发 SHA-1 证书,

但在 Kubernetes 语境中可能仍然存在用户提供的证书通过私有机构使用 SHA-1 哈希函数签名的情况,

这些证书用于聚合 API 服务器或 Webhook。

如果您依赖基于 SHA-1 的证书,必须通过在环境变量中设置 GODEBUG=x509sha1=1 来明确选择重新启用其支持。

鉴于 Go 的 GODEBUG 兼容性策略,x509sha1 GODEBUG 和对 SHA-1

证书的支持将在 go1.24 中完全消失,

而 go1.24 将在 2025 年上半年发布。

如果您依赖 SHA-1 证书,请开始迁移离开它们。

请查看 Kubernetes issue #125689 以了解有关 SHA-1 支持消失的时间线、Kubernetes 发布计划何时采用 go1.24, 以及如何通过指标和审计日志检测 SHA-1 证书使用情况的更多详细信息。

弃用 Node 节点的 status.nodeInfo.kubeProxyVersion 字段 (KEP 4004)

节点的 .status.nodeInfo.kubeProxyVersion 字段在 Kubernetes v1.31 中已被弃用,

并将在以后的版本中删除。

它被弃用是因为这个字段的值不准确(现在也不准确)。

这个字段是由 kubelet 设置的,而 kubelet 没有关于 kube-proxy 版本或 kube-proxy 是否正在运行的可靠信息。

DisableNodeKubeProxyVersion 特性门控将在 v1.31

中默认设置为 true,kubelet 将不再尝试为其关联的节点设置 .status.kubeProxyVersion 字段。

移除所有树内云提供商集成

正如之前的文章中强调的那样,作为 v1.31 发布的一部分,最后剩余的树内云平台集成支持已被移除。 这并不意味着您不能与云平台集成,但是您现在必须使用推荐的方法使用外部集成。一些集成是 Kubernetes 项目的一部分,而其他则是第三方软件。

这一里程碑标志着所有云提供商集成从 Kubernetes 核心外部化过程的完成(KEP-2395),这个过程始于 Kubernetes v1.26。 这一变化有助于 Kubernetes 更接近成为一个真正供应商中立的平台。

有关云提供商集成的更多详细信息,请阅读我们的 v1.29 云提供商集成功能博客。 有关树内代码移除的额外背景,我们邀请您查看(v1.29 弃用博客)。

后者的博客还包含了需要迁移到 v1.29 及更高版本的用户的有用信息。

移除树内供应商特性门控

在 Kubernetes v1.31 中,以下 Alpha 特性门控 InTreePluginAWSUnregister、InTreePluginAzureDiskUnregister、

InTreePluginAzureFileUnregister、InTreePluginGCEUnregister、InTreePluginOpenStackUnregister

和 InTreePluginvSphereUnregister 已被移除。

这些特性门控的引入是为了便于测试从代码库中移除树内卷插件的场景,而无需实际移除它们。

由于 Kubernetes 1.30 已弃用这些树内卷插件,这些特性门控变得多余,不再有用。

唯一仍然存在的 CSI 迁移门控是 InTreePluginPortworxUnregister,它将保持 Alpha 状态,

直到 Portworx 的 CSI 迁移完成,其树内卷插件准备好被移除。

移除 kubelet 的 --keep-terminated-pod-volumes 命令行标志

作为 v1.31 版本的一部分,已移除 kubelet 标志 --keep-terminated-pod-volumes。该标志于 2017 年被弃用。

您可以在拉取请求 #122082 中找到更多详细信息。

移除 CephFS 卷插件

本次发布中移除了 CephFS 卷插件,cephfs 卷类型变为不可用。

建议您改用 CephFS CSI 驱动 作为第三方存储驱动程序。 如果您在将集群版本升级到 v1.31 之前使用了 CephFS 卷插件,则必须重新部署应用程序以使用新的驱动程序。

CephFS 卷插件在 v1.28 中正式标记为废弃。

移除 Ceph RBD 卷插件

v1.31 版本移除了 Ceph RBD volume plugin 及其 CSI 迁移支持,使 rbd 卷类型变为不可用。

建议您在集群中改用 RBD CSI driver。 如果您在将集群版本升级到 v1.31 之前使用了 Ceph RBD 卷插件,则必须重新部署应用程序以使用新的驱动程序。

Ceph RBD 卷插件在 v1.28 中正式标记为废弃。

废弃 kube-scheduler 中的非 CSI 卷限制插件

v1.31 版本将废弃所有非 CSI 卷限制调度器插件,并将从默认插件中移除一些已废弃的插件,包括:

AzureDiskLimitsCinderLimitsEBSLimitsGCEPDLimits

建议您改用 NodeVolumeLimits 插件,因为自从这些卷类型迁移到 CSI 后,该插件可以处理与已移除插件相同的功能。

如果您在调度器配置中明确使用了已废弃的插件,请将它们替换为 NodeVolumeLimits 插件。

AzureDiskLimits、CinderLimits、EBSLimits 和 GCEPDLimits 插件将在未来的版本中被移除。

这些插件自 Kubernetes v1.14 以来已被废弃,将从默认调度器插件列表中移除。

发布说明和所需的升级操作

请在我们的发布说明中查看 Kubernetes v1.31 版本的完整详细信息。

启用 SchedulerQueueingHints 时,调度器现在使用 QueueingHint

社区为调度器添加了支持,以便在启用 SchedulerQueueingHints 功能门控时,开始使用为 Pod/Updated

事件注册的 QueueingHint,以确定对先前不可调度的 Pod 的更新是否使其变得可调度。

以前,当不可调度的 Pod 被更新时,调度器总是将 Pod 放回队列(activeQ / backoffQ)。

然而,并非所有对 Pod 的更新都会使 Pod 变得可调度,特别是考虑到现在许多调度约束是不可变更的。

在新的行为下,一旦不可调度的 Pod 被更新,调度队列会通过 QueueingHint 检查该更新是否可能使 Pod 变得可调度,

并且只有当至少一个 QueueingHint 返回 Queue 时,才将它们重新排队到 activeQ 或 backoffQ。

自定义调度器插件开发者需要采取的操作:

如果插件的拒绝可以通过更新未调度的 Pod 本身来解决,那么插件必须为 Pod/Update 事件实现 QueueingHint。

例如:假设您开发了一个自定义插件,该插件拒绝具有 schedulable=false 标签的 Pod。

鉴于带有 schedulable=false 标签的 Pod 在移除该标签后将变得可调度,这个插件将为 Pod/Update

事件实现 QueueingHint,当在未调度的 Pod 中进行此类标签更改时返回 Queue。

您可以在 pull request #122234 中找到更多详细信息。

移除 kubelet --keep-terminated-pod-volumes 命令行标志

作为 v1.31 版本的一部分,已移除 kubelet 标志 --keep-terminated-pod-volumes。该标志于 2017 年被弃用。

您可以在拉取请求 #122082 中找到更多详细信息。

可用性

Kubernetes v1.31 可在 GitHub 或 Kubernetes 下载页面上下载。

要开始使用 Kubernetes,请查看这些交互式教程或使用 minikube 运行本地 Kubernetes 集群。您还可以使用 kubeadm 轻松安装 v1.31。

发布团队

Kubernetes 的实现离不开社区的支持、投入和辛勤工作。 每个发布团队由致力于构建 Kubernetes 发布版本各个部分的专门社区志愿者组成。 这需要来自我们社区各个角落的人员的专业技能,从代码本身到文档和项目管理。

我们要感谢整个发布团队为向我们的社区交付 Kubernetes v1.31 版本所付出的时间和努力。 发布团队的成员从首次参与的影子成员到经历多个发布周期的回归团队负责人不等。 特别感谢我们的发布负责人 Angelos Kolaitis,他支持我们完成了一个成功的发布周期,为我们发声,确保我们都能以最佳方式贡献,并挑战我们改进发布过程。

项目速度

CNCF K8s DevStats 项目汇总了许多与 Kubernetes 及各个子项目速度相关的有趣数据点。 这包括从个人贡献到贡献公司数量的所有内容,展示了进化这个生态系统所投入的深度和广度。

在为期 14 周的 v1.31 发布周期(5 月 7 日至 8 月 13 日)中,我们看到来自 113 家不同公司和 528 个个人对 Kubernetes 的贡献。

在整个云原生生态系统中,我们有 379 家公司,共计 2268 名贡献者 - 这意味着相比上一个发布周期,个人贡献者数量惊人地增加了 63%!

数据来源:

贡献指的是当某人进行提交、代码审查、评论、创建问题或 PR、审查 PR(包括博客和文档)或对问题和 PR 进行评论。

如果您有兴趣贡献,请访问此页面开始。

查看 DevStats 以了解更多关于 Kubernetes 项目和社区整体速度的信息。

活动更新

探索 2024 年 8 月至 11 月即将举行的 Kubernetes 和云原生活动,包括 KubeCon、KCD 和其他全球知名会议。保持了解并参与 Kubernetes 社区。

2024 年 8 月

- KubeCon + CloudNativeCon + 开源峰会中国 2024:2024 年 8 月 21-23 日 | 中国香港

- KubeDay Japan:2024 年 8 月 27 日 | 东京,日本

2024 年 9 月

- KCD 拉合尔 - 巴基斯坦 2024: 2024 年 9 月 1 日 | 拉合尔,巴基斯坦

- KuberTENes 生日庆典 斯德哥尔摩: 2024 年 9 月 5 日 | 斯德哥尔摩,瑞典

- KCD Sydney ’24: 2024 年 9 月 5-6 日 | 悉尼,澳大利亚

- KCD Washington DC 2024: 2024 年 9 月 24 日 | 华盛顿特区,美国

- KCD Porto 2024: 2024 年 9 月 27-28 日 | 波尔图,葡萄牙

2024 年 10 月

- KCD Austria 2024: 2024 年 10 月 8-10 日 | 维也纳,奥地利

- KubeDay Australia: 2024 年 10 月 15 日 | 墨尔本,澳大利亚

- KCD UK - London 2024: 2024 年 10 月 22-23 日 | 伦敦,英国

2024 年 11 月

- KubeCon + CloudNativeCon North America 2024: 2024 年 11 月 12-15 日 | 盐湖城,美国

- Kubernetes on EDGE Day North America: 2024 年 11 月 12 日 | 盐湖城,美国

即将举行的发布网络研讨会

加入 Kubernetes v1.31 发布团队成员,于 2024 年 9 月 12 日星期四太平洋时间上午 10 点了解此版本的主要特性,以及废弃和移除的内容,以帮助规划升级。 有关更多信息和注册,请访问 CNCF 在线项目网站上的活动页面。

参与其中

参与 Kubernetes 的最简单方式是加入与您兴趣相符的众多特殊兴趣小组(SIG)之一。 您有什么想向 Kubernetes 社区广播的内容吗? 在我们的每周社区会议上分享您的声音,并通过以下渠道。 感谢您持续的反馈和支持。

- 在 X 上关注我们 @Kubernetesio 获取最新更新

- 在 Discuss 上加入社区讨论

- 在 Slack 上加入社区

- 在 Stack Overflow 上发布问题(或回答问题)

- 分享您的 Kubernetes 故事

- 在博客上阅读更多关于 Kubernetes 的最新动态

- 了解更多关于 Kubernetes 发布团队的信息

向 Client-Go 引入特性门控:增强灵活性和控制力

Kubernetes 组件使用称为“特性门控(Feature Gates)”的开关来管理添加新特性的风险, 特性门控机制使特性能够通过 Alpha、Beta 和 GA 阶段逐步升级。

Kubernetes 组件(例如 kube-controller-manager 和 kube-scheduler)使用 client-go 库与 API 交互, 整个 Kubernetes 生态系统使用相同的库来构建控制器、工具、webhook 等。 client-go 现在包含自己的特性门控机制,使开发人员和集群管理员能够更好地控制如何使用客户端特性。

要了解有关 Kubernetes 中特性门控的更多信息,请参阅特性门控。

动机

在没有 client-go 特性门控的情况下,每个新特性都以自己的方式(如果有的话)将特性可用性与特性的启用分开。 某些特性可通过更新到较新版本的 client-go 来启用,其他特性则需要在每个使用它们的程序中进行主动配置, 其中一些可在运行时使用环境变量进行配置。使用 kube-apiserver 公开的特性门控功能时,有时需要客户端回退机制, 以保持与由于版本新旧或配置不同而不支持该特性服务器的兼容性。 如果在这些回退机制中发现问题,则缓解措施需要更新到 client-go 的固定版本或回滚。

这些方法都无法很好地支持为某些(但不是全部)使用 client-go 的程序默认启用特性。 默认设置的更改不会首先仅为单个组件启用新特性,而是会立即影响所有 Kubernetes 组件的默认设置,从而大大扩大影响半径。

client-go 中的特性门控

为了应对这些挑战,大量的 client-go 特性将使用新的特性门控机制来逐步引入。 这一机制将允许开发人员和用户以类似 Kubernetes 组件特性门控的管理方式启用或禁用特性。

作为一种开箱即用的能力,用户只需使用最新版本的 client-go。这种设计带来多种好处。

对于使用通过 client-go 构建的软件的用户:

- 早期采用者可以针对各个进程分别启用默认关闭的 client-go 特性。

- 无需构建新的二进制文件即可禁用行为不当的特性。

- 所有已知的 client-go 特性门控的状态都会被记录到日志中,允许用户检查。

对于开发使用 client-go 构建的软件的人员:

- 默认情况下,client-go 特性门控覆盖是从环境变量中读取的。 如果在 client-go 特性中发现错误,用户将能够禁用它,而无需等待新版本发布。

- 开发人员可以替换程序中基于默认环境变量的覆盖值以更改默认值、从其他源读取覆盖值或完全禁用运行时覆盖值。

Kubernetes 组件使用这种可定制性将 client-go 特性门控与现有的

--feature-gates命令行标志、特性启用指标和日志记录集成在一起。

覆盖 client-go 特性门控

注意:这描述了在运行时覆盖 client-go 特性门控的默认方法,它可以由特定程序的开发人员禁用或自定义。

在 Kubernetes 组件中,client-go 特性门控覆盖由 --feature-gates 标志控制。

可以通过设置以 KUBE_FEATURE 为前缀的环境变量来启用或禁用 client-go 的特性。

例如,要启用名为 MyFeature 的特性,请按如下方式设置环境变量:

KUBE_FEATURE_MyFeature=true

要禁用特性,可将环境变量设置为 false:

KUBE_FEATURE_MyFeature=false

注意:在某些操作系统上,环境变量区分大小写。

因此,KUBE_FEATURE_MyFeature 和 KUBE_FEATURE_MYFEATURE 将被视为两个不同的变量。

自定义 client-go 特性门控

基于环境变量的默认特性门控覆盖机制足以满足 Kubernetes 生态系统中许多程序的需求,无需特殊集成。 需要不同行为的程序可以用自己的自定义特性门控提供程序替换它。 这允许程序执行诸如强制禁用已知运行不良的特性、直接从远程配置服务读取特性门控或通过命令行选项接受特性门控覆盖等操作。

Kubernetes 组件将 client-go 的默认特性门控提供程序替换为现有 Kubernetes 特性门控提供程序的转换层。

在所有实际应用场合中,client-go 特性门控与其他 Kubernetes 特性门控的处理方式相同:

它们连接到 --feature-gates 命令行标志,包含在特性启用指标中,并在启动时记录。

要替换默认的特性门控提供程序,请实现 Gates 接口并在包初始化时调用 ReplaceFeatureGates,如以下简单示例所示:

import (

"k8s.io/client-go/features"

)

type AlwaysEnabledGates struct{}

func (AlwaysEnabledGates) Enabled(features.Feature) bool {

return true

}

func init() {

features.ReplaceFeatureGates(AlwaysEnabledGates{})

}

需要定义的 client-go 特性完整列表的实现可以通过实现 Registry 接口并调用 AddFeaturesToExistingFeatureGates 来获取它。

完整示例请参考

Kubernetes 内部使用。

总结

随着 client-go v1.30 中特性门控的引入,推出新的 client-go 特性变得更加安全、简单。 用户和开发人员可以控制自己采用 client-go 特性的步伐。 通过为跨 Kubernetes API 边界两侧的特性提供一种通用的培育机制,Kubernetes 贡献者的工作得到了简化。

聚焦 SIG API Machinery

我们最近与 SIG API Machinery 的主席 Federico Bongiovanni(Google)和 David Eads(Red Hat)进行了访谈, 了解一些有关这个 Kubernetes 特别兴趣小组的信息。

介绍

Frederico (FSM):你好,感谢你抽时间参与访谈。首先,你能做个自我介绍以及你是如何参与到 Kubernetes 的?

David:我在 2014 年秋天开始在

OpenShift

(Red Hat 的 Kubernetes 发行版)工作,很快就参与到 API Machinery 的工作中。

我的第一个 PR 是修复 kube-apiserver 的错误消息,然后逐渐扩展到 kubectl(kubeconfigs 是我的杰作!),

auth(RBAC

和 *Review API 是从 OpenShift 移植过来的),apps(例如 workqueues 和 sharedinformers)。

别告诉别人,但 API Machinery 仍然是我的最爱 :)

Federico:我加入 Kubernetes 没有 David 那么早,但现在也已经超过六年了。 在我之前的公司,我们开始为自己的产品使用 Kubernetes,当我有机会直接参与 Kubernetes 的工作时, 我放下了一切,登上了这艘船(无意双关)。我在 2018 年初加入 Google 从事 Kubernetes 的相关工作, 从那时起一直参与其中。

SIG Machinery 的范围

FSM:只需快速浏览一下 SIG API Machinery 的章程,就可以看到它的范围相当广泛, 不亚于 Kubernetes 的控制平面。你能用自己的话描述一下这个范围吗?

David:我们全权负责 kube-apiserver 以及如何高效地使用它。

在后端,这包括它与后端存储的契约以及如何让 API 模式随时间演变。

在前端,这包括模式的最佳实践、序列化、客户端模式以及在其之上的控制器模式。

Federico:Kubernetes 有很多不同的组件,但控制平面有一个非常关键的任务: 它是你与集群的通信层,同时也拥有所有使 Kubernetes 如此强大的可扩展机制。 我们不能犯像回归或不兼容变更这样的错误,因为影响范围太大了。

FSM:鉴于这个广度,你们如何管理它的不同方面?

Federico:我们尝试将大量工作组织成较小的领域。工作组和子项目是其中的一部分。 SIG 中的各位贡献者有各自的专长领域,如果一切都失败了,我们很幸运有像 David、Joe 和 Stefan 这样的人, 他们真的是“全能型”,这种方式让我在这些年里一直感到惊叹。但另一方面, 这也是为什么我们需要更多人来帮助我们在版本变迁之时保持 Kubernetes 的质量和卓越。

不断演变的协作模式

FSM:现有的模式一直是这样,还是随着时间的推移而演变的 - 如果是在演变的,你认为主要的变化以及背后的原因是什么?

David:API Machinery 在随着时间的推移不断发展,既有扩展也有收缩。 在尝试满足客户端访问模式时,它很容易在特性和应用方面扩大范围。

一个范围扩大的好例子是我们认识到需要减少客户端写入控制器时的内存使用率而开发了共享通知器。 在开发共享通知器和使用它们的控制器模式(工作队列、错误处理和列举器)时, 我们大大减少了内存使用率,并消除了许多占用资源较多的列表。 缺点是:我们增加了一套新的权能来提供支持,并有效地从 sig-apps 接管了该领域的所有权。

一个更多共享所有权的例子是:构建出合作的资源管理(服务器端应用的目标),

kubectl 扩展为负责利用服务器端应用的权能。这个过渡尚未完成,

但 SIG CLI 管理其使用情况并拥有它。

FSM:对于方法之间的权衡,你们有什么指导方针吗?

David:我认为这很大程度上取决于影响。如果影响在立即见效中是局部的, 我们会给其他 SIG 提出建议并让他们以自己的节奏推进。 如果影响在立即见效中是全局的且没有自然的激励,我们发现需要直接推动采用。

FSM:仍然在这个话题上,SIG Architecture 有一个 API Governance 子项目, 它与 SIG API Machinery 是否完全独立,还是有重要的连接点?

David:这些项目有相似的名称并对彼此产生一些影响,但有不同的使命和范围。 API Machinery 负责“如何做”,而 API Governance 负责“做什么”。 API 约定、API 审批过程以及对单个 k8s.io API 的最终决定权属于 API Governance。 API Machinery 负责 REST 语义和非 API 特定行为。

Federico:我真得很喜欢 David 的说法: “API Machinery 负责‘如何做’,而 API Governance 负责‘做什么’”: 我们并未拥有实际的 API,但实际的 API 依靠我们存在。

Kubernetes 受欢迎的挑战

FSM:随着 Kubernetes 的采用率上升,我们肯定看到了对控制平面的需求增加:你们对这点的感受如何,它如何影响 SIG 的工作?

David:这对 API Machinery 产生了巨大的影响。多年来,我们经常响应并多次促进了 Kubernetes 的发展阶段。 作为几乎所有 Kubernetes 集群上权能的集中编排中心,我们既领导又跟随社区。 从广义上讲,我看到多年来 API Machinery 经历了一些发展阶段,活跃度一直很高。

寻找目标:从

pre-1.0到v1.3(我们达到了第一个 1000+ 节点/命名空间)。 这段时间以快速变化为特征。我们经历了五个不同版本的模式,并满足了需求。 我们优化了快速、树内 API 的演变(有时以牺牲长期目标为代价),并首次定义了模式。满足需求的扩展:

v1.3-1.9(直到控制器中的共享通知器)。 当我们开始尝试满足客户需求时,我们发现了严重的 CPU 和内存规模限制。 这也是为什么我们将 API Machinery 扩展到包含访问模式,但我们仍然非常关注树内类型。 我们构建了 watch 缓存、protobuf 序列化和共享缓存。

- 培育生态系统:

v1.8-1.21(直到 CRD v1)。这是我们设计和编写 CRD(视为第三方资源的替代品)的时间, 满足我们知道即将到来的即时需求(准入 Webhook),以及我们知道需要的最佳实践演变(API 模式)。 这促成了早期采用者的爆发式增长,他们愿意在约束内非常谨慎地工作,以实现服务 Pod 的用例。 采用速度非常快,有时超出了我们的权能,并形成了新的问题。

- 简化部署:

v1.22+。在不久之前, 我们采用扩展机制来响应运行大规模的 Kubernetes 集群的压力,其中包含大量有时会发生冲突的生态系统项目。 我们投入了许多努力,使平台更易于扩展,管理更安全,就算不是很精通 Kubernetes 的人也能做到。 这些努力始于服务器端应用,并在如今延续到 Webhook 匹配状况和验证准入策略等特性。

API Machinery 的工作对整个项目和生态系统有广泛的影响。 对于那些能够长期投入大量时间的人来说,这是一个令人兴奋的工作领域。

未来发展

FSM:考虑到这些不同的发展阶段,你能说说这个 SIG 的当前首要任务是什么吗?

David:大致的顺序为可靠性、效率和权能。

随着 kube-apiserver 和扩展机制的使用增加,我们发现第一套扩展机制虽然在权能方面相当完整,

但在潜在误用方面存在重大风险,影响范围很大。为了减轻这些风险,我们正在致力于减少事故影响范围的特性

(Webhook 匹配状况)以及为大多数操作提供风险配置较低的替代机制(验证准入策略)。

同时,使用量的增加使我们更加意识到我们可以同时改进服务器端和客户端的扩缩限制。 这里的努力包括更高效的序列化(CBOR),减少 etcd 负载(从缓存中一致读取)和减少峰值内存使用量(流式列表)。

最后,使用量的增加突显了一些长期存在的、我们正在设法填补的差距。这些包括针对 CRD 的字段选择算符, Batch Working Group 渴望利用这些选择算符,并最终构建一种新的方法以防止从有漏洞的节点实施“蹦床式”的 Pod 攻击。

加入有趣的我们

FSM:如果有人想要开始贡献,你有什么建议?

Federico:SIG API Machinery 毫不例外也遵循 Kubernetes 的风格:砍柴和挑水(踏实工作,注重细节)。 有多个每周例会对所有人开放,总是有更多的工作要做,人手总是不够。

我承认 API Machinery 并不容易,入门的坡度会比较陡峭。门槛较高,就像我们所讨论的原因:我们肩负着巨大的责任。 当然凭借激情和毅力,多年来有许多人已经跟了上来,我们希望更多的人加入。

具体的机会方面,每两周有一次 SIG 会议。欢迎所有人参会和听会,了解小组在讨论什么,了解这个版本中发生了什么等等。

此外,每周两次,周二和周四,我们有公开的 Bug 分类管理会,在会上我们会讨论上次会议以来的所有新内容。 我们已经保持这种做法 7 年多了。这是一个很好的机会,你可以志愿审查代码、修复 Bug、改进文档等。 周二的会议在下午 1 点(PST),周四是在 EMEA 友好时间(上午 9:30 PST)。 我们总是在寻找改进的机会,希望能够在未来提供更多具体的参与机会。

FSM:太好了,谢谢!你们还有什么想与我们的读者分享吗?

Federico:正如我提到的,第一步可能较难,但回报也更大。 参与 API Machinery 的工作就是在加入一个影响巨大(百万用户?)的领域, 你的贡献将直接影响 Kubernetes 的工作方式和使用方式。对我来说,这已经足够作为回报和动力了!

Kubernetes v1.31 中的移除和主要变更