管理集群

- 1: 为集群超配节点容量

- 2: 用 kubeadm 进行管理

- 2.1: 添加 Linux 工作节点

- 2.2: 添加 Windows 工作节点

- 2.3: 升级 kubeadm 集群

- 2.4: 升级 Linux 节点

- 2.5: 升级 Windows 节点

- 2.6: 配置 cgroup 驱动

- 2.7: 使用 kubeadm 进行证书管理

- 2.8: 重新配置 kubeadm 集群

- 2.9: 更改 Kubernetes 软件包仓库

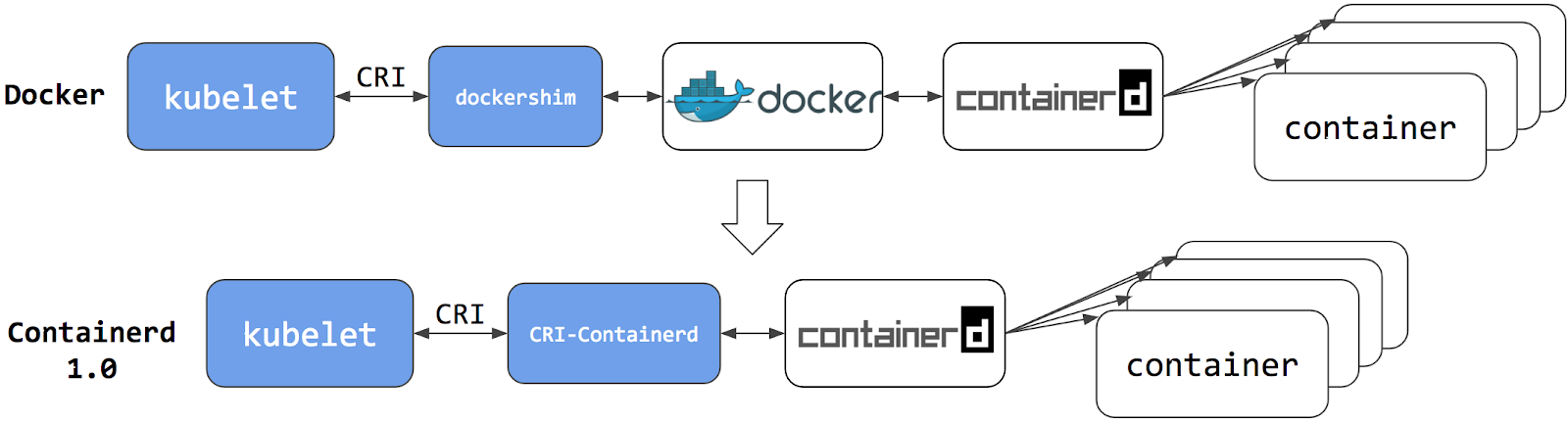

- 3: 从 dockershim 迁移

- 3.1: 将节点上的容器运行时从 Docker Engine 改为 containerd

- 3.2: 将 Docker Engine 节点从 dockershim 迁移到 cri-dockerd

- 3.3: 查明节点上所使用的容器运行时

- 3.4: 排查 CNI 插件相关的错误

- 3.5: 检查移除 Dockershim 是否对你有影响

- 3.6: 从 dockershim 迁移遥测和安全代理

- 4: 手动生成证书

- 5: 管理内存、CPU 和 API 资源

- 5.1: 为命名空间配置默认的内存请求和限制

- 5.2: 为命名空间配置默认的 CPU 请求和限制

- 5.3: 配置命名空间的最小和最大内存约束

- 5.4: 为命名空间配置 CPU 最小和最大约束

- 5.5: 为命名空间配置内存和 CPU 配额

- 5.6: 配置命名空间下 Pod 配额

- 6: 安装网络策略驱动

- 6.1: 使用 Antrea 提供 NetworkPolicy

- 6.2: 使用 Calico 提供 NetworkPolicy

- 6.3: 使用 Cilium 提供 NetworkPolicy

- 6.4: 使用 kube-router 提供 NetworkPolicy

- 6.5: 使用 Romana 提供 NetworkPolicy

- 6.6: 使用 Weave Net 提供 NetworkPolicy

- 7: 使用 Kubernetes API 访问集群

- 8: 为节点发布扩展资源

- 9: 自动扩缩集群 DNS 服务

- 10: 从轮询切换为基于 CRI 事件的更新来获取容器状态

- 11: 改变默认 StorageClass

- 12: 将 PersistentVolume 的访问模式更改为 ReadWriteOncePod

- 13: 更改 PersistentVolume 的回收策略

- 14: Kubernetes 云管理控制器

- 15: 配置 kubelet 镜像凭据提供程序

- 16: 配置 API 对象配额

- 17: 控制节点上的 CPU 管理策略

- 18: 控制节点上的拓扑管理策略

- 19: 自定义 DNS 服务

- 20: 调试 DNS 问题

- 21: 声明网络策略

- 22: 开发云控制器管理器

- 23: 启用/禁用 Kubernetes API

- 24: 静态加密机密数据

- 25: 解密已静态加密的机密数据

- 26: 关键插件 Pod 的调度保证

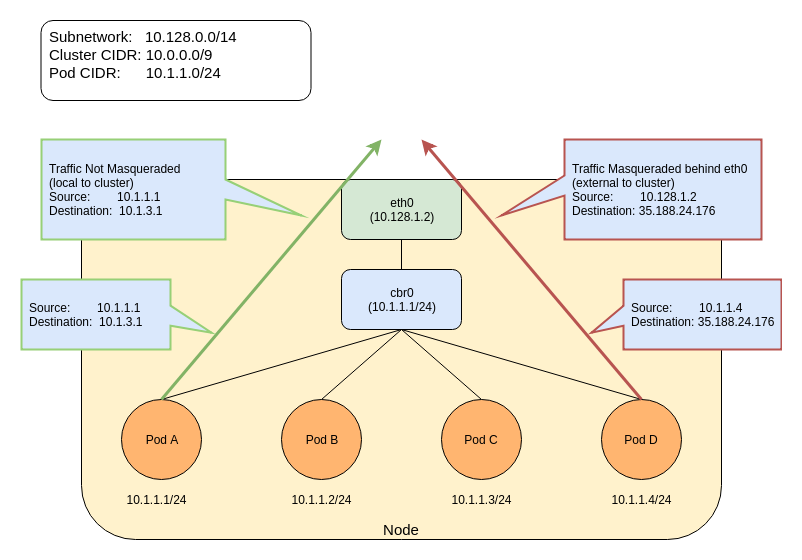

- 27: IP Masquerade Agent 用户指南

- 28: 限制存储使用量

- 29: 迁移多副本的控制面以使用云控制器管理器

- 30: 名字空间演练

- 31: 操作 Kubernetes 中的 etcd 集群

- 32: 为系统守护进程预留计算资源

- 33: 以非 root 用户身份运行 Kubernetes 节点组件

- 34: 安全地清空一个节点

- 35: 保护集群

- 36: 通过配置文件设置 kubelet 参数

- 37: 通过名字空间共享集群

- 38: 升级集群

- 39: 在集群中使用级联删除

- 40: 使用 KMS 驱动进行数据加密

- 41: 使用 CoreDNS 进行服务发现

- 42: 在 Kubernetes 集群中使用 NodeLocal DNSCache

- 43: 在 Kubernetes 集群中使用 sysctl

- 44: 使用 NUMA 感知的内存管理器

- 45: 验证已签名容器镜像

1 - 为集群超配节点容量

本页指导你在 Kubernetes 集群中配置节点超配。 节点超配是一种主动预留部分集群计算资源的策略。这种预留有助于减少在扩缩容事件期间调度新 Pod 所需的时间, 从而增强集群对突发流量或突发工作负载需求的响应能力。

通过保持一些未使用的容量,确保在新 Pod 被创建时资源可以立即可用,防止 Pod 在集群扩缩容时进入 Pending 状态。

准备开始

- 你需要有一个 Kubernetes 集群,并且 kubectl 命令行工具必须被配置为与你的集群通信。

- 你应该已经基本了解了 Deployment、Pod 优先级和 PriorityClass。

- 你的集群必须设置一个基于需求管理节点的自动扩缩程序。

创建 PriorityClass

首先为占位 Pod 定义一个 PriorityClass。 先创建一个优先级值为负数的 PriorityClass,稍后将其分配给占位 Pod。 接下来,你将部署使用此 PriorityClass 的 Deployment。

apiVersion: scheduling.k8s.io/v1

kind: PriorityClass

metadata:

name: placeholder # 这些 Pod 表示占位容量

value: -1000

globalDefault: false

description: "Negative priority for placeholder pods to enable overprovisioning."

然后创建 PriorityClass:

kubectl apply -f https://k8s.io/examples/priorityclass/low-priority-class.yaml

接下来,你将定义一个 Deployment,使用优先级值为负数的 PriorityClass 并运行最小的容器。 当你将此 Deployment 添加到集群中时,Kubernetes 会运行这些占位 Pod 以预留容量。 每当出现容量短缺时,控制面将选择这些占位 Pod 中的一个作为第一个候选者进行抢占。

运行请求节点容量的 Pod

查看样例清单:

apiVersion: apps/v1

kind: Deployment

metadata:

name: capacity-reservation

# 你应决定要将此 Deployment 部署到哪个命名空间

spec:

replicas: 1

selector:

matchLabels:

app.kubernetes.io/name: capacity-placeholder

template:

metadata:

labels:

app.kubernetes.io/name: capacity-placeholder

annotations:

kubernetes.io/description: "Capacity reservation"

spec:

priorityClassName: placeholder

affinity: # 有可能的话,将这些 Pod 开销放到不同的节点

podAntiAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchLabels:

app: placeholder

topologyKey: "kubernetes.io/hostname"

containers:

- name: pause

image: registry.k8s.io/pause:3.6

resources:

requests:

cpu: "50m"

memory: "512Mi"

limits:

memory: "512Mi"

为占位 Pod 挑选一个命名空间

你应选择或创建占位 Pod 要进入的命名空间。

创建占位 Deployment

基于该清单创建 Deployment:

# 你要更改命名空间名称 "example"

kubectl --namespace example apply -f https://k8s.io/examples/deployments/deployment-with-capacity-reservation.yaml

调整占位资源请求

为占位 Pod 配置资源请求和限制,以定义你希望保持的超配资源量。 这种预留确保为新 Pod 保留可以使用的、特定量的 CPU 和内存。

要编辑 Deployment,可以修改 Deployment 清单文件中的 resources 一节,

设置合适的 requests 和 limits。

你可以将该文件下载到本地,然后用自己喜欢的文本编辑器进行编辑。

你也可以使用 kubectl 来编辑 Deployment:

kubectl edit deployment capacity-reservation

例如,要为 5 个占位 Pod 预留 500m CPU 和 1Gi 内存,请为单个占位 Pod 定义以下资源请求和限制:

resources:

requests:

cpu: "100m"

memory: "200Mi"

limits:

cpu: "100m"

设置所需的副本数量

计算总预留资源

例如,有 5 个副本,每个预留 0.1 CPU 和 200MiB 内存:

CPU 预留总量:5 × 0.1 = 0.5(在 Pod 规约中,你将写入数量 500m)

内存预留总量:5 × 200MiB = 1GiB(在 Pod 规约中,你将写入 1 Gi)

要扩缩容 Deployment,请基于集群的大小和预期的工作负载调整副本数:

kubectl scale deployment capacity-reservation --replicas=5

验证扩缩容效果:

kubectl get deployment capacity-reservation

输出应反映出更新后的副本数:

NAME READY UP-TO-DATE AVAILABLE AGE

capacity-reservation 5/5 5 5 2m

说明:

一些自动扩缩组件,特别是 Karpenter, 在考虑节点扩缩容时将偏好的亲和性规则视为硬性规则。如果你使用 Karpenter 或其他使用同样启发式的节点扩缩容组件,你在此处设置的副本数也就是你的集群的最少节点数。

接下来

- 进一步了解 PriorityClass 及其如何影响 Pod 调度。

- 探索节点自动扩缩容, 以基于工作负载需求动态调整集群的大小。

- 了解 Pod 抢占, 这是 Kubernetes 处理资源竞争的关键机制。这篇文档还涵盖了驱逐, 虽然与占位 Pod 方法相关性较小,但也是 Kubernetes 在资源竞争时做出反应的一种机制。

2.1 - 添加 Linux 工作节点

本页介绍如何将 Linux 工作节点添加到 kubeadm 集群。

准备开始

- 每个要加入的工作节点都已安装 安装 kubeadm 中所需的组件,例如 kubeadm、kubelet 和 容器运行时。

- 一个正在运行的、由

kubeadm init命令所创建的 kubeadm 集群,且该集群的创建遵循 使用 kubeadm 创建集群 文档中所给的步骤。 - 你需要对节点拥有超级用户权限。

添加 Linux 工作节点

要将新的 Linux 工作节点添加到集群中,请对每台机器执行以下步骤:

- 通过 SSH 或其他方式连接到该机器。

- 运行

kubeadm init所输出的命令。例如:

sudo kubeadm join --token <token> <control-plane-host>:<control-plane-port> --discovery-token-ca-cert-hash sha256:<hash>

kubeadm join 的额外信息

说明:

要为 <control-plane-host>:<control-plane-port> 指定一个 IPv6 元组,

IPv6 地址必须用方括号括起来,例如:[2001:db8::101]:2073。

如果你没有令牌,可以在控制平面节点上运行以下命令来获取:

# 在控制平面节点上运行此命令

sudo kubeadm token list

命令输出同以下内容类似:

TOKEN TTL EXPIRES USAGES DESCRIPTION EXTRA GROUPS

8ewj1p.9r9hcjoqgajrj4gi 23h 2018-06-12T02:51:28Z authentication, The default bootstrap system:

signing token generated by bootstrappers:

'kubeadm init'. kubeadm:

default-node-token

默认情况下,节点加入令牌会在 24 小时后过期。当前令牌过期后,如果想把节点加入集群, 可以在控制平面节点上运行以下命令来创建新令牌:

# 在控制平面节点上运行此命令

sudo kubeadm token create

命令输出同以下内容类似:

5didvk.d09sbcov8ph2amjw

如果你没有 --discovery-token-ca-cert-hash 的具体值,可以在控制平面节点上运行以下命令来获取:

# 在控制平面节点上运行此命令

sudo cat /etc/kubernetes/pki/ca.crt | openssl x509 -pubkey | openssl rsa -pubin -outform der 2>/dev/null | \

openssl dgst -sha256 -hex | sed 's/^.* //'

命令输出同以下内容类似:

8cb2de97839780a412b93877f8507ad6c94f73add17d5d7058e91741c9d5ec78

kubeadm join 命令的输出应该同下面内容类似:

[preflight] Running pre-flight checks

... (log output of join workflow) ...

Node join complete:

* Certificate signing request sent to control-plane and response

received.

* Kubelet informed of new secure connection details.

Run 'kubectl get nodes' on control-plane to see this machine join.

几秒钟后,你应该在 kubectl get nodes 的输出中看到该节点。

(例如,可以在控制平面节点上运行 kubectl)。

说明:

集群节点通常是按顺序初始化的,因此 CoreDNS Pods 可能会全部运行在第一个控制平面节点上。

为了保证高可用,请在至少一个新节点加入后,使用

kubectl -n kube-system rollout restart deployment coredns 命令重新平衡 CoreDNS Pods。

接下来

- 参见如何添加 Windows 工作节点。

2.2 - 添加 Windows 工作节点

Kubernetes v1.18 [beta]本页介绍如何将 Linux 工作节点添加到 kubeadm 集群。

准备开始

- 一个正在运行的 Windows Server 2022 (或更高版本)实例,且具备管理权限。

- 一个正在运行的、由

kubeadm init命令创建的集群,且集群的创建遵循 使用 kubeadm 创建集群 文档中所给的步骤。

添加 Windows 工作节点

说明:

为了方便将 Windows 工作节点添加到集群,下面会用到代码仓库 https://sigs.k8s.io/sig-windows-tools 里的 PowerShell 脚本。

对每台机器执行以下操作:

- 在机器上打开一个 PowerShell 会话。

- 确保你是管理员或具有特权的用户。

然后继续执行下面的步骤。

安装 Containerd

要安装 Containerd,首先运行以下命令:

curl.exe -LO https://raw.githubusercontent.com/kubernetes-sigs/sig-windows-tools/master/hostprocess/Install-Containerd.ps1

然后运行以下命令,但要首先将 CONTAINERD_VERSION 替换为

Containerd 仓库 中的最新发布版本。

版本号不能带有前缀 v 。例如,使用 1.7.22 而不是 v1.7.22:

.\Install-Containerd.ps1 -ContainerDVersion CONTAINERD_VERSION

- 根据需要调整

Install-Containerd.ps1的所有其他参数,例如netAdapterName。 - 如果你的机器不支持 Hyper-V,且无法托管 Hyper-V 的隔离容器,

请设置

skipHypervisorSupportCheck。 - 如果你要更改

Install-Containerd.ps1中的可选参数CNIBinPath和/或CNIConfigPath,则需要配置已安装的 Windows CNI 插件,使之与这里的值匹配。

安装 kubeadm 和 kubelet

运行以下命令安装 kubeadm 和 kubelet:

curl.exe -LO https://raw.githubusercontent.com/kubernetes-sigs/sig-windows-tools/master/hostprocess/PrepareNode.ps1

.\PrepareNode.ps1 -KubernetesVersion v1.32

- 根据需要调整

PrepareNode.ps1中的参数KubernetesVersion。

运行 kubeadm join

运行 kubeadm init 所输出的命令。例如:

kubeadm join --token <token> <control-plane-host>:<control-plane-port> --discovery-token-ca-cert-hash sha256:<hash>

kubeadm join 的附加信息

说明:

要为 <control-plane-host>:<control-plane-port> 指定一个 IPv6 元组,

IPv6 地址必须用方括号括起来,例如:[2001:db8::101]:2073。

如果你没有令牌,可以在控制平面节点上运行以下命令来获取:

# 在控制平面节点上运行此命令

sudo kubeadm token list

命令输出同以下内容类似:

TOKEN TTL EXPIRES USAGES DESCRIPTION EXTRA GROUPS

8ewj1p.9r9hcjoqgajrj4gi 23h 2018-06-12T02:51:28Z authentication, The default bootstrap system:

signing token generated by bootstrappers:

'kubeadm init'. kubeadm:

default-node-token

默认情况下,节点加入令牌会在 24 小时后过期。当前令牌过期后,如果想把节点加入集群, 可以在控制平面节点上运行以下命令来创建新令牌:

# 在控制平面节点上运行此命令

sudo kubeadm token create

命令输出同以下内容类似:

5didvk.d09sbcov8ph2amjw

如果你没有 --discovery-token-ca-cert-hash 的具体值,可以在控制平面节点上运行以下命令来获取:

sudo cat /etc/kubernetes/pki/ca.crt | openssl x509 -pubkey | openssl rsa -pubin -outform der 2>/dev/null | \

openssl dgst -sha256 -hex | sed 's/^.* //'

命令输出同以下内容类似:

8cb2de97839780a412b93877f8507ad6c94f73add17d5d7058e91741c9d5ec78

kubeadm join 命令的输出应该同以下内容类似:

[preflight] Running pre-flight checks

... (log output of join workflow) ...

Node join complete:

* Certificate signing request sent to control-plane and response

received.

* Kubelet informed of new secure connection details.

Run 'kubectl get nodes' on control-plane to see this machine join.

几秒钟后,你应该在 kubectl get nodes 的输出中看到该节点。

(例如,可以在控制平面节点上运行 kubectl)。

网络配置

在混合了 Linux 和 Windows 节点的集群中,CNI 设置所需的步骤不仅仅是对清单文件运行

kubectl apply。此外,运行在控制平面节点上的 CNI 插件必须能够支持在 Windows 工作节点上

运行的 CNI 插件。

目前只有少数 CNI 插件支持 Windows。以下是它们各自的设置说明:

在 Windows 上安装 kubectl (可选)

接下来

参见如何 添加 Linux 工作节点。

2.3 - 升级 kubeadm 集群

本页介绍如何将 kubeadm 创建的 Kubernetes 集群从 1.31.x 版本

升级到 1.32.x 版本以及从 1.32.x

升级到 1.32.y(其中 y > x)。略过次版本号的升级是

不被支持的。更多详情请访问版本偏差策略。

要查看 kubeadm 创建的有关旧版本集群升级的信息,请参考以下页面:

- 将 kubeadm 集群从 1.30 升级到 1.31

- 将 kubeadm 集群从 1.29 升级到 1.30

- 将 kubeadm 集群从 1.28 升级到 1.29

- 将 kubeadm 集群从 1.27 升级到 1.28

Kubernetes 项目建议立即升级到最新的补丁版本,并确保你运行的是受支持的 Kubernetes 次要版本。 遵循此建议可帮助你保持安全。

升级工作的基本流程如下:

- 升级主控制平面节点

- 升级其他控制平面节点

- 升级工作节点

准备开始

- 务必仔细认真阅读发行说明。

- 集群应使用静态的控制平面和 etcd Pod 或者外部 etcd。

- 务必备份所有重要组件,例如存储在数据库中应用层面的状态。

kubeadm upgrade不会影响你的工作负载,只会涉及 Kubernetes 内部的组件,但备份终究是好的。 - 必须禁用交换分区。

附加信息

- 下述说明了在升级过程中何时腾空每个节点。如果你正在对任何 kubelet 进行小版本升级, 你需要先腾空待升级的节点(或多个节点)。对于控制面节点,其上可能运行着 CoreDNS Pod 或者其它非常重要的负载。更多信息见腾空节点。

- Kubernetes 项目推荐你使用版本匹配的 kubelet 和 kubeadm。 但你也可以使用比 kubeadm 版本更低的 kubelet 版本,前提是该版本仍处于支持的版本范围内。 欲了解更多信息,请访问 kubeadm 与 kubelet 的版本差异。

- 升级后,因为容器规约的哈希值已更改,所有容器都会被重新启动。

- 要验证 kubelet 服务在升级后是否成功重启,可以执行

systemctl status kubelet或journalctl -xeu kubelet查看服务日志。 kubeadm upgrade支持--config和UpgradeConfigurationAPI 类型 可用于配置升级过程。kubeadm upgrade不支持重新配置现有集群。 请按照重新配置 kubeadm 集群中的步骤来进行。

升级 etcd 时的注意事项

由于 kube-apiserver 静态 Pod 始终在运行(即使你已经执行了腾空节点的操作),

因此当你执行包括 etcd 升级在内的 kubeadm 升级时,对服务器正在进行的请求将停滞,

因为要重新启动新的 etcd 静态 Pod。作为一种解决方法,可以在运行 kubeadm upgrade apply

命令之前主动停止 kube-apiserver 进程几秒钟。这样可以允许正在进行的请求完成处理并关闭现有连接,

并最大限度地减少 etcd 停机的后果。此操作可以在控制平面节点上按如下方式完成:

killall -s SIGTERM kube-apiserver # 触发 kube-apiserver 体面关闭

sleep 20 # 等待一下,以完成进行中的请求

kubeadm upgrade ... # 执行 kubeadm 升级命令

更改软件包仓库

如果你正在使用社区版的软件包仓库(pkgs.k8s.io),

你需要启用所需的 Kubernetes 小版本的软件包仓库。

这一点在更改 Kubernetes 软件包仓库文档中有详细说明。

apt.kubernetes.io 和yum.kubernetes.io)。

强烈建议使用托管在 pkgs.k8s.io 上的新软件包仓库来安装 2023 年 9 月 13 日之后发布的 Kubernetes 版本。

旧版软件包仓库已被弃用,其内容可能在未来的任何时间被删除,恕不另行通知。新的软件包仓库提供了从 Kubernetes v1.24.0 版本开始的下载。确定要升级到哪个版本

使用操作系统的包管理器找到最新的补丁版本 Kubernetes 1.32:

# 在列表中查找最新的 1.32 版本

# 它看起来应该是 1.32.x-*,其中 x 是最新的补丁版本

sudo apt update

sudo apt-cache madison kubeadm

# 在列表中查找最新的 1.32 版本

# 它看起来应该是 1.32.x-*,其中 x 是最新的补丁版本

sudo yum list --showduplicates kubeadm --disableexcludes=kubernetes

升级控制平面节点

控制面节点上的升级过程应该每次处理一个节点。

首先选择一个要先行升级的控制面节点。该节点上必须拥有

/etc/kubernetes/admin.conf 文件。

执行 “kubeadm upgrade”

对于第一个控制面节点

升级 kubeadm:

# 用最新的补丁版本号替换 1.32.x-* 中的 x sudo apt-mark unhold kubeadm && \ sudo apt-get update && sudo apt-get install -y kubeadm='1.32.x-*' && \ sudo apt-mark hold kubeadm# 用最新的补丁版本号替换 1.32.x-* 中的 x sudo yum install -y kubeadm-'1.32.x-*' --disableexcludes=kubernetes

验证下载操作正常,并且 kubeadm 版本正确:

kubeadm version

验证升级计划:

sudo kubeadm upgrade plan此命令检查你的集群是否可被升级,并取回你要升级的目标版本。 命令也会显示一个包含组件配置版本状态的表格。

说明:

kubeadm upgrade也会自动对 kubeadm 在节点上所管理的证书执行续约操作。 如果需要略过证书续约操作,可以使用标志--certificate-renewal=false。 更多的信息,可参阅证书管理指南。

选择要升级到的目标版本,运行合适的命令。例如:

# 将 x 替换为你为此次升级所选择的补丁版本号 sudo kubeadm upgrade apply v1.32.x一旦该命令结束,你应该会看到:

[upgrade/successful] SUCCESS! Your cluster was upgraded to "v1.32.x". Enjoy! [upgrade/kubelet] Now that your control plane is upgraded, please proceed with upgrading your kubelets if you haven't already done so.说明:

对于 v1.28 之前的版本,kubeadm 默认采用这样一种模式:在

kubeadm upgrade apply期间立即升级插件(包括 CoreDNS 和 kube-proxy),而不管是否还有其他尚未升级的控制平面实例。 这可能会导致兼容性问题。从 v1.28 开始,kubeadm 默认采用这样一种模式: 在开始升级插件之前,先检查是否已经升级所有的控制平面实例。 你必须按顺序执行控制平面实例的升级,或者至少确保在所有其他控制平面实例已完成升级之前不启动最后一个控制平面实例的升级, 并且在最后一个控制平面实例完成升级之后才执行插件的升级。

手动升级你的 CNI 驱动插件。

你的容器网络接口(CNI)驱动应该提供了程序自身的升级说明。 参阅插件页面查找你的 CNI 驱动, 并查看是否需要其他升级步骤。

如果 CNI 驱动作为 DaemonSet 运行,则在其他控制平面节点上不需要此步骤。

对于其它控制面节点

与第一个控制面节点相同,但是使用:

sudo kubeadm upgrade node

而不是:

sudo kubeadm upgrade apply

此外,不需要执行 kubeadm upgrade plan 和更新 CNI 驱动插件的操作。

腾空节点

将节点标记为不可调度并驱逐所有负载,准备节点的维护:

# 将 <node-to-drain> 替换为你要腾空的控制面节点名称

kubectl drain <node-to-drain> --ignore-daemonsets

升级 kubelet 和 kubectl

升级 kubelet 和 kubectl:

# 用最新的补丁版本替换 1.32.x-* 中的 x sudo apt-mark unhold kubelet kubectl && \ sudo apt-get update && sudo apt-get install -y kubelet='1.32.x-*' kubectl='1.32.x-*' && \ sudo apt-mark hold kubelet kubectl# 用最新的补丁版本号替换 1.32.x-* 中的 x sudo yum install -y kubelet-'1.32.x-*' kubectl-'1.32.x-*' --disableexcludes=kubernetes

重启 kubelet:

sudo systemctl daemon-reload sudo systemctl restart kubelet

解除节点的保护

通过将节点标记为可调度,让其重新上线:

# 将 <node-to-uncordon> 替换为你的节点名称

kubectl uncordon <node-to-uncordon>

升级工作节点

工作节点上的升级过程应该一次执行一个节点,或者一次执行几个节点, 以不影响运行工作负载所需的最小容量。

以下内容演示如何升级 Linux 和 Windows 工作节点:

验证集群的状态

在所有节点上升级 kubelet 后,通过从 kubectl 可以访问集群的任何位置运行以下命令, 验证所有节点是否再次可用:

kubectl get nodes

STATUS 应显示所有节点为 Ready 状态,并且版本号已经被更新。

从故障状态恢复

如果 kubeadm upgrade 失败并且没有回滚,例如由于执行期间节点意外关闭,

你可以再次运行 kubeadm upgrade。

此命令是幂等的,并最终确保实际状态是你声明的期望状态。

要从故障状态恢复,你还可以运行 sudo kubeadm upgrade apply --force 而无需更改集群正在运行的版本。

在升级期间,kubeadm 向 /etc/kubernetes/tmp 目录下的如下备份文件夹写入数据:

kubeadm-backup-etcd-<date>-<time>kubeadm-backup-manifests-<date>-<time>

kubeadm-backup-etcd 包含当前控制面节点本地 etcd 成员数据的备份。

如果 etcd 升级失败并且自动回滚也无法修复,则可以将此文件夹中的内容复制到

/var/lib/etcd 进行手工修复。如果使用的是外部的 etcd,则此备份文件夹为空。

kubeadm-backup-manifests 包含当前控制面节点的静态 Pod 清单文件的备份版本。

如果升级失败并且无法自动回滚,则此文件夹中的内容可以复制到

/etc/kubernetes/manifests 目录实现手工恢复。

如果由于某些原因,在升级前后某个组件的清单未发生变化,则 kubeadm 也不会为之生成备份版本。

说明:

集群通过 kubeadm 升级后,备份目录 /etc/kubernetes/tmp 将保留,这些备份文件需要手动清理。

工作原理

kubeadm upgrade apply 做了以下工作:

- 检查你的集群是否处于可升级状态:

- API 服务器是可访问的

- 所有节点处于

Ready状态 - 控制面是健康的

- 强制执行版本偏差策略。

- 确保控制面的镜像是可用的或可拉取到服务器上。

- 如果组件配置要求版本升级,则生成替代配置与/或使用用户提供的覆盖版本配置。

- 升级控制面组件或回滚(如果其中任何一个组件无法启动)。

- 应用新的

CoreDNS和kube-proxy清单,并强制创建所有必需的 RBAC 规则。 - 如果旧文件在 180 天后过期,将创建 API 服务器的新证书和密钥文件并备份旧文件。

kubeadm upgrade node 在其他控制平节点上执行以下操作:

- 从集群中获取 kubeadm

ClusterConfiguration。 - (可选操作)备份 kube-apiserver 证书。

- 升级控制平面组件的静态 Pod 清单。

- 为本节点升级 kubelet 配置

kubeadm upgrade node 在工作节点上完成以下工作:

- 从集群取回 kubeadm

ClusterConfiguration。 - 为本节点升级 kubelet 配置。

2.4 - 升级 Linux 节点

本页讲述了如何升级用 kubeadm 创建的 Linux 工作节点。

准备开始

你必须有 Shell 能访问所有节点,且必须配置 kubectl 命令行工具让其与你的集群通信。 建议运行本教程的集群至少有两个节点,且这两个节点不能作为控制平面主机。

要获知版本信息,请输入kubectl version.- 你自己要熟悉升级剩余 kubeadm 集群的过程。 你需要先升级控制面节点,再升级 Linux 工作节点。

更改软件包仓库

如果你正在使用社区自治的软件包仓库(pkgs.k8s.io),

你需要启用所需的 Kubernetes 小版本的软件包仓库。

这一点在更改 Kubernetes 软件包仓库文档中有详细说明。

apt.kubernetes.io 和yum.kubernetes.io)。

强烈建议使用托管在 pkgs.k8s.io 上的新软件包仓库来安装 2023 年 9 月 13 日之后发布的 Kubernetes 版本。

旧版软件包仓库已被弃用,其内容可能在未来的任何时间被删除,恕不另行通知。新的软件包仓库提供了从 Kubernetes v1.24.0 版本开始的下载。升级工作节点

升级 kubeadm

升级 kubeadm:

# 将 1.32.x-* 中的 x 替换为最新的补丁版本

sudo apt-mark unhold kubeadm && \

sudo apt-get update && sudo apt-get install -y kubeadm='1.32.x-*' && \

sudo apt-mark hold kubeadm

# 将 1.32.x-* 中的 x 替换为最新的补丁版本

sudo yum install -y kubeadm-'1.32.x-*' --disableexcludes=kubernetes

执行 "kubeadm upgrade"

对于工作节点,下面的命令会升级本地的 kubelet 配置:

sudo kubeadm upgrade node

腾空节点

将节点标记为不可调度并驱逐所有负载,准备节点的维护:

# 在控制平面节点上执行此命令

# 将 <node-to-drain> 替换为你正腾空的节点的名称

kubectl drain <node-to-drain> --ignore-daemonsets

升级 kubelet 和 kubectl

升级 kubelet 和 kubectl:

# 将 1.32.x-* 中的 x 替换为最新的补丁版本 sudo apt-mark unhold kubelet kubectl && \ sudo apt-get update && sudo apt-get install -y kubelet='1.32.x-*' kubectl='1.32.x-*' && \ sudo apt-mark hold kubelet kubectl# 将 1.32.x-* 中的 x 替换为最新的补丁版本 sudo yum install -y kubelet-'1.32.x-*' kubectl-'1.32.x-*' --disableexcludes=kubernetes

重启 kubelet:

sudo systemctl daemon-reload sudo systemctl restart kubelet

取消对节点的保护

通过将节点标记为可调度,让节点重新上线:

# 在控制平面节点上执行此命令

# 将 <node-to-uncordon> 替换为你的节点名称

kubectl uncordon <node-to-uncordon>

接下来

- 查阅如何升级 Windows 节点。

2.5 - 升级 Windows 节点

Kubernetes v1.18 [beta]本页解释如何升级用 kubeadm 创建的 Windows 节点。

准备开始

你必须有 Shell 能访问所有节点,且必须配置 kubectl 命令行工具让其与你的集群通信。 建议运行本教程的集群至少有两个节点,且这两个节点不能作为控制平面主机。

你的 Kubernetes 服务器版本必须不低于版本 1.17. 要获知版本信息,请输入kubectl version.- 熟悉更新 kubeadm 集群中的其余组件。 在升级你的 Windows 节点之前你会想要升级控制面节点。

升级工作节点

升级 kubeadm

在 Windows 节点上升级 kubeadm:

# 将 1.32.0 替换为你希望的版本 curl.exe -Lo <kubeadm.exe 路径> "https://dl.k8s.io/v1.32.0/bin/windows/amd64/kubeadm.exe"

腾空节点

在一个能访问到 Kubernetes API 的机器上,将 Windows 节点标记为不可调度并 驱逐其上的所有负载,以便准备节点维护操作:

# 将 <要腾空的节点> 替换为你要腾空的节点的名称 kubectl drain <要腾空的节点> --ignore-daemonsets你应该会看到类似下面的输出:

node/ip-172-31-85-18 cordoned node/ip-172-31-85-18 drained

升级 kubelet 配置

在 Windows 节点上,执行下面的命令来同步新的 kubelet 配置:

kubeadm upgrade node

升级 kubelet 和 kube-proxy

在 Windows 节点上升级并重启 kubelet:

stop-service kubelet curl.exe -Lo <kubelet.exe 路径> "https://dl.k8s.io/v1.32.0/bin/windows/amd64/kubelet.exe" restart-service kubelet

在 Windows 节点上升级并重启 kube-proxy:

stop-service kube-proxy curl.exe -Lo <kube-proxy.exe 路径> "https://dl.k8s.io/v1.32.0/bin/windows/amd64/kube-proxy.exe" restart-service kube-proxy

说明:

如果你是在 Pod 内的 HostProcess 容器中运行 kube-proxy,而不是作为 Windows 服务, 你可以通过应用更新版本的 kube-proxy 清单文件来升级 kube-proxy。

对节点执行 uncordon 操作

从一台能够访问到 Kubernetes API 的机器上,通过将节点标记为可调度,使之 重新上线:

# 将 <要腾空的节点> 替换为你的节点名称 kubectl uncordon <要腾空的节点>

接下来

- 查看如何升级 Linux 节点。

2.6 - 配置 cgroup 驱动

本页阐述如何配置 kubelet 的 cgroup 驱动以匹配 kubeadm 集群中的容器运行时的 cgroup 驱动。

准备开始

你应该熟悉 Kubernetes 的容器运行时需求。

配置容器运行时 cgroup 驱动

容器运行时页面提到,

由于 kubeadm 把 kubelet 视为一个

系统服务来管理,

所以对基于 kubeadm 的安装, 我们推荐使用 systemd 驱动,

不推荐 kubelet 默认的 cgroupfs 驱动。

此页还详述了如何安装若干不同的容器运行时,并将 systemd 设为其默认驱动。

配置 kubelet 的 cgroup 驱动

kubeadm 支持在执行 kubeadm init 时,传递一个 KubeletConfiguration 结构体。

KubeletConfiguration 包含 cgroupDriver 字段,可用于控制 kubelet 的 cgroup 驱动。

说明:

在版本 1.22 及更高版本中,如果用户没有在 KubeletConfiguration 中设置 cgroupDriver 字段,

kubeadm 会将它设置为默认值 systemd。

在 Kubernetes v1.28 中,你可以以 Alpha 功能启用 cgroup 驱动的自动检测。 有关更多详情,请查看 systemd cgroup 驱动。

这是一个最小化的示例,其中显式的配置了此字段:

# kubeadm-config.yaml

kind: ClusterConfiguration

apiVersion: kubeadm.k8s.io/v1beta4

kubernetesVersion: v1.21.0

---

kind: KubeletConfiguration

apiVersion: kubelet.config.k8s.io/v1beta1

cgroupDriver: systemd

这样一个配置文件就可以传递给 kubeadm 命令了:

kubeadm init --config kubeadm-config.yaml

说明:

Kubeadm 对集群所有的节点,使用相同的 KubeletConfiguration。

KubeletConfiguration 存放于 kube-system 命名空间下的某个

ConfigMap 对象中。

执行 init、join 和 upgrade 等子命令会促使 kubeadm

将 KubeletConfiguration 写入到文件 /var/lib/kubelet/config.yaml 中,

继而把它传递给本地节点的 kubelet。

使用 cgroupfs 驱动

如仍需使用 cgroupfs 且要防止 kubeadm upgrade 修改现有系统中

KubeletConfiguration 的 cgroup 驱动,你必须显式声明它的值。

此方法应对的场景为:在将来某个版本的 kubeadm 中,你不想使用默认的 systemd 驱动。

参阅以下章节“修改 kubelet 的 ConfigMap ”,了解显式设置该值的方法。

如果你希望配置容器运行时来使用 cgroupfs 驱动,

则必须参考所选容器运行时的文档。

迁移到 systemd 驱动

要将现有 kubeadm 集群的 cgroup 驱动从 cgroupfs 就地升级为 systemd,

需要执行一个与 kubelet 升级类似的过程。

该过程必须包含下面两个步骤:

说明:

还有一种方法,可以用已配置了systemd 的新节点替换掉集群中的老节点。

按这种方法,在加入新节点、确保工作负载可以安全迁移到新节点、及至删除旧节点这一系列操作之前,

只需执行以下第一个步骤。修改 kubelet 的 ConfigMap

运行

kubectl edit cm kubelet-config -n kube-system。修改现有

cgroupDriver的值,或者新增如下式样的字段:cgroupDriver: systemd该字段必须出现在 ConfigMap 的

kubelet:小节下。

更新所有节点的 cgroup 驱动

对于集群中的每一个节点:

- 执行命令

kubectl drain <node-name> --ignore-daemonsets,以 腾空节点 - 执行命令

systemctl stop kubelet,以停止 kubelet - 停止容器运行时

- 修改容器运行时 cgroup 驱动为

systemd - 在文件

/var/lib/kubelet/config.yaml中添加设置cgroupDriver: systemd - 启动容器运行时

- 执行命令

systemctl start kubelet,以启动 kubelet - 执行命令

kubectl uncordon <node-name>,以 取消节点隔离

在节点上依次执行上述步骤,确保工作负载有充足的时间被调度到其他节点。

流程完成后,确认所有节点和工作负载均健康如常。

2.7 - 使用 kubeadm 进行证书管理

Kubernetes v1.15 [stable]由 kubeadm 生成的客户端证书在 1 年后到期。 本页说明如何使用 kubeadm 管理证书续订,同时也涵盖其他与 kubeadm 证书管理相关的说明。

Kubernetes 项目建议及时升级到最新的补丁版本,并确保你正在运行受支持的 Kubernetes 次要版本。 遵循这一建议有助于你确保安全。

准备开始

你应该熟悉 Kubernetes 中的 PKI 证书和要求。

你应该熟悉如何将一个配置文件传递给 kubeadm 命令。

本指南将介绍如何使用 openssl 命令(用于手动证书签名),但你可以使用你喜欢的工具。

这里的一些步骤使用 sudo 来获取管理员访问权限。你可以使用任何等效的工具。

使用自定义的证书

默认情况下,kubeadm 会生成运行一个集群所需的全部证书。 你可以通过提供你自己的证书来改变这个行为策略。

如果要这样做,你必须将证书文件放置在通过 --cert-dir 命令行参数或者 kubeadm 配置中的

certificatesDir 配置项指明的目录中。默认的值是 /etc/kubernetes/pki。

如果在运行 kubeadm init 之前存在给定的证书和私钥对,kubeadm 将不会重写它们。

例如,这意味着你可以将现有的 CA 复制到 /etc/kubernetes/pki/ca.crt 和

/etc/kubernetes/pki/ca.key 中,而 kubeadm 将使用此 CA 对其余证书进行签名。

选择加密算法

kubeadm 允许你选择用于创建公钥和私钥的加密算法。这可以通过使用

kubeadm 配置中的 encryptionAlgorithm 字段来实现。

apiVersion: kubeadm.k8s.io/v1beta4

kind: ClusterConfiguration

encryptionAlgorithm: <ALGORITHM>

<ALGORITHM> 可以是 RSA-2048(默认)、RSA-3072、RSA-4096

或 ECDSA-P256 之一。

选择证书有效期

kubeadm 允许你选择 CA 和 leaf 证书的有效期。

这可以通过使用 kubeadm 配置的 certificateValidityPeriod 和 caCertificateValidityPeriod

字段来完成:

apiVersion: kubeadm.k8s.io/v1beta4

kind: ClusterConfiguration

certificateValidityPeriod: 8760h # 默认:365 天 × 24 小时 = 1 年

caCertificateValidityPeriod: 87600h # 默认:365 天 × 24 小时 * 10 = 10 年

字段的值遵循 Go 语言的 time.Duration 格式,

支持的最长单位为 h(小时)。

外部 CA 模式

只提供了 ca.crt 文件但是不提供 ca.key 文件也是可以的

(这只对 CA 根证书可用,其它证书不可用)。

如果所有的其它证书和 kubeconfig 文件已就绪,kubeadm 检测到满足以上条件就会激活

"外部 CA" 模式。kubeadm 将会在没有 CA 密钥文件的情况下继续执行。

否则,kubeadm 将独立运行 controller-manager,附加一个

--controllers=csrsigner 的参数,并且指明 CA 证书和密钥。

使用外部 CA 模式时,有多种方法可以准备组件证书。

手动准备组件证书

PKI 证书和要求包含有关如何手动准备 kubeadm 组件证书所需的所有信息。

本指南将介绍如何使用 openssl 命令(用于手动证书签名),但你可以使用你喜欢的工具。

通过签署 kubeadm 生成的 CSR 来准备证书

kubeadm 可以生成 CSR 文件,你可以使用 openssl 和外部 CA 等工具手动签署这些文件。

这些 CSR 文件将包含 kubeadm 部署的组件所需的所有证书规范。

使用 kubeadm 阶段自动准备组件证书

或者,可以使用 kubeadm 阶段命令来自动化此过程。

- 登录到将作为具有外部 CA 的 kubeadm 控制平面节点的主机。

- 将外部 CA 文件

ca.crt和ca.key复制到节点上的/etc/kubernetes/pki目录中。 - 准备一个名为

config.yaml的临时 kubeadm 配置文件, 该文件可以用在kubeadm init命令中。确保此文件包含可包含在证书中的集群范围或特定于主机的所有重要信息, 例如ClusterConfiguration.controlPlaneEndpoint、ClusterConfiguration.certSANs和InitConfiguration.APIEndpoint。 - 在同一主机上执行命令

kubeadm init stage kubeconfig all --config config.yaml和kubeadm init stage certs all --config config.yaml。 这些操作将在/etc/kubernetes/及其pki子目录下生成所有必需的 kubeconfig 文件和证书。

- 检查所生成的文件。删除

/etc/kubernetes/pki/ca.key,删除或移动/etc/kubernetes/super-admin.conf文件到安全的位置。 - 在将执行

kubeadm join的节点上还需要删除/etc/kubernetes/kubelet.conf, 仅在将执行kubeadm init的第一个节点上需要此文件。 - 请注意,一些文件如

pki/sa.*、pki/front-proxy-ca.*和pki/etc/ca.*在控制平面各节点上是相同的,你可以一次性生成它们并手动将其分发到将执行kubeadm join的节点,或者你可以使用kubeadm init的--upload-certs和kubeadm join的--certificate-key特性来执行自动分发。

在所有节点上准备好证书后,调用 kubeadm init 和 kubeadm join 命令将这些节点加入集群。

kubeadm 将使用 /etc/kubernetes/ 及其 pki 子目录下现有的 kubeconfig 和证书文件。

证书过期和管理

说明:

kubeadm 不能管理由外部 CA 签名的证书。

你可以使用 check-expiration 子命令来检查证书何时过期:

kubeadm certs check-expiration

输出类似于以下内容:

CERTIFICATE EXPIRES RESIDUAL TIME CERTIFICATE AUTHORITY EXTERNALLY MANAGED

admin.conf Dec 30, 2020 23:36 UTC 364d no

apiserver Dec 30, 2020 23:36 UTC 364d ca no

apiserver-etcd-client Dec 30, 2020 23:36 UTC 364d etcd-ca no

apiserver-kubelet-client Dec 30, 2020 23:36 UTC 364d ca no

controller-manager.conf Dec 30, 2020 23:36 UTC 364d no

etcd-healthcheck-client Dec 30, 2020 23:36 UTC 364d etcd-ca no

etcd-peer Dec 30, 2020 23:36 UTC 364d etcd-ca no

etcd-server Dec 30, 2020 23:36 UTC 364d etcd-ca no

front-proxy-client Dec 30, 2020 23:36 UTC 364d front-proxy-ca no

scheduler.conf Dec 30, 2020 23:36 UTC 364d no

CERTIFICATE AUTHORITY EXPIRES RESIDUAL TIME EXTERNALLY MANAGED

ca Dec 28, 2029 23:36 UTC 9y no

etcd-ca Dec 28, 2029 23:36 UTC 9y no

front-proxy-ca Dec 28, 2029 23:36 UTC 9y no

该命令显示 /etc/kubernetes/pki 文件夹中的客户端证书以及

kubeadm(admin.conf、controller-manager.conf 和 scheduler.conf)

使用的 kubeconfig 文件中嵌入的客户端证书的到期时间/剩余时间。

另外,kubeadm 会通知用户证书是否由外部管理; 在这种情况下,用户应该小心的手动/使用其他工具来管理证书更新。

上面的列表中没有包含 kubelet.conf 配置文件,因为 kubeadm 将 kubelet

配置为自动更新证书。

轮换的证书位于目录 /var/lib/kubelet/pki。

要修复过期的 kubelet 客户端证书,请参阅

kubelet 客户端证书轮换失败。

说明:

在通过 kubeadm 1.17 之前的版本以 kubeadm init 创建的节点上,

有一个缺陷,

该缺陷使得你必须手动修改 kubelet.conf 文件的内容。

kubeadm init 操作结束之后,你必须更新 kubelet.conf 文件将 client-certificate-data

和 client-key-data 改为如下所示的内容以便使用轮换后的 kubelet 客户端证书:

client-certificate: /var/lib/kubelet/pki/kubelet-client-current.pem

client-key: /var/lib/kubelet/pki/kubelet-client-current.pem

自动更新证书

kubeadm 会在控制面升级的时候更新所有证书。

这个功能旨在解决最简单的用例;如果你对此类证书的更新没有特殊要求, 并且定期执行 Kubernetes 版本升级(每次升级之间的间隔时间少于 1 年), 则 kubeadm 将确保你的集群保持最新状态并保持合理的安全性。

如果你对证书更新有更复杂的需求,则可通过将 --certificate-renewal=false 传递给

kubeadm upgrade apply 或者 kubeadm upgrade node,从而选择不采用默认行为。

手动更新证书

你能随时通过 kubeadm certs renew 命令手动更新你的证书,只需带上合适的命令行选项。

如果你正在运行的集群具有多副本的控制平面,则需要在所有控制平面节点上执行此命令。

此命令用 CA(或者 front-proxy-CA )证书和存储在 /etc/kubernetes/pki 中的密钥执行更新。

kubeadm certs renew 使用现有的证书作为属性(Common Name、Organization、SAN 等)的权威来源,

而不依赖于 kubeadm-config ConfigMap。强烈建议使它们保持同步。

即便如此,Kubernetes 项目仍然建议使用的证书与 ConfigMap 中的关联值保持同步,以避免任何混淆的风险。

执行完此命令之后你需要重启控制面 Pod。因为动态证书重载目前还不被所有组件和证书支持,所有这项操作是必须的。

静态 Pod 是被本地 kubelet

而不是 API 服务器管理,所以 kubectl 不能用来删除或重启他们。

要重启静态 Pod 你可以临时将清单文件从 /etc/kubernetes/manifests/ 移除并等待 20 秒

(参考 KubeletConfiguration 结构中的

fileCheckFrequency 值)。如果 Pod 不在清单目录里,kubelet 将会终止它。

在另一个 fileCheckFrequency 周期之后你可以将文件移回去,kubelet 可以完成 Pod

的重建,而组件的证书更新操作也得以完成。

kubeadm certs renew 可以更新任何特定的证书,或者使用子命令 all 更新所有的证书:

# 如果你运行的集群具有多副本的控制平面,则需要在所有控制平面节点上执行这条命令

kubeadm certs renew all

复制管理员证书(可选)

使用 kubeadm 构建的集群通常会将 admin.conf 证书复制到 $HOME/.kube/config,

参阅使用 kubeadm 创建集群。

在这样的系统上,若要在更新 admin.conf 后更新 $HOME/.kube/config 的内容,你可以运行以下命令:

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

用 Kubernetes 证书 API 更新证书

本节提供有关如何使用 Kubernetes 证书 API 执行手动证书更新的更多详细信息。

注意:

这些是针对需要将其组织的证书基础结构集成到 kubeadm 构建的集群中的用户的高级主题。 如果默认的 kubeadm 配置满足了你的需求,则应让 kubeadm 管理证书。

设置一个签名者(Signer)

Kubernetes 证书颁发机构不是开箱即用。你可以配置外部签名者,例如 cert-manager, 也可以使用内置签名者。

内置签名者是

kube-controller-manager

的一部分。

要激活内置签名者,请传递 --cluster-signing-cert-file 和 --cluster-signing-key-file 参数。

如果你正在创建一个新的集群,你可以使用 kubeadm 的配置文件:

apiVersion: kubeadm.k8s.io/v1beta4

kind: ClusterConfiguration

controllerManager:

extraArgs:

- name: "cluster-signing-cert-file"

value: "/etc/kubernetes/pki/ca.crt"

- name: "cluster-signing-key-file"

value: "/etc/kubernetes/pki/ca.key"

创建证书签名请求(CSR)

有关使用 Kubernetes API 创建 CSR 的信息, 请参见创建 CertificateSigningRequest。

通过外部 CA 更新证书

本节提供有关如何使用外部 CA 执行手动更新证书的更多详细信息。

为了更好的与外部 CA 集成,kubeadm 还可以生成证书签名请求(CSR)。 CSR 表示向 CA 请求客户的签名证书。 在 kubeadm 术语中,通常由磁盘 CA 签名的任何证书都可以作为 CSR 生成。但是,CA 不能作为 CSR 生成。

使用证书签名请求(CSR)续订

可以通过生成新的 CSR 并使用外部 CA 对其进行签名来对证书进行续约。 有关使用 kubeadm 生成的 CSR 的更多详细信息,请参阅对 kubeadm 生成的证书签名请求(CSR)进行签名部分。

证书机构(CA)轮换

kubeadm 并不直接支持对 CA 证书的轮换或者替换。

关于手动轮换或者置换 CA 的更多信息, 可参阅手动轮换 CA 证书。

启用已签名的 kubelet 服务证书

默认情况下,kubeadm 所部署的 kubelet 服务证书是自签名(Self-Signed)。 这意味着从 metrics-server 这类外部服务发起向 kubelet 的链接时无法使用 TLS 来完成保护。

要在新的 kubeadm 集群中配置 kubelet 以使用被正确签名的服务证书,

你必须向 kubeadm init 传递如下最小配置数据:

apiVersion: kubeadm.k8s.io/v1beta4

kind: ClusterConfiguration

---

apiVersion: kubelet.config.k8s.io/v1beta1

kind: KubeletConfiguration

serverTLSBootstrap: true

如果你已经创建了集群,你必须通过执行下面的操作来完成适配:

- 找到

kube-system名字空间中名为kubelet-config-1.32的 ConfigMap 并编辑之。 在该 ConfigMap 中,kubelet键下面有一个 KubeletConfiguration 文档作为其取值。编辑该 KubeletConfiguration 文档以设置serverTLSBootstrap: true。 - 在每个节点上,在

/var/lib/kubelet/config.yaml文件中添加serverTLSBootstrap: true字段,并使用systemctl restart kubelet来重启 kubelet。

字段 serverTLSBootstrap 将允许启动引导 kubelet 的服务证书,方式是从

certificates.k8s.io API 处读取。这种方式的一种局限在于这些证书的

CSR(证书签名请求)不能被 kube-controller-manager 中默认的签名组件

kubernetes.io/kubelet-serving

批准。需要用户或者第三方控制器来执行此操作。

可以使用下面的命令来查看 CSR:

kubectl get csr

NAME AGE SIGNERNAME REQUESTOR CONDITION

csr-9wvgt 112s kubernetes.io/kubelet-serving system:node:worker-1 Pending

csr-lz97v 1m58s kubernetes.io/kubelet-serving system:node:control-plane-1 Pending

你可以执行下面的操作来批准这些请求:

kubectl certificate approve <CSR-名称>

默认情况下,这些服务证书会在一年后过期。

kubeadm 将 KubeletConfiguration 的 rotateCertificates 字段设置为

true;这意味着证书快要过期时,会生成一组针对服务证书的新的 CSR,而这些

CSR 也要被批准才能完成证书轮换。要进一步了解这里的细节,

可参阅证书轮换文档。

如果你在寻找一种能够自动批准这些 CSR 的解决方案,建议你与你的云提供商联系, 询问他们是否有 CSR 签名组件,用来以带外(out-of-band)的方式检查节点的标识符。

也可以使用第三方定制的控制器:

除非既能够验证 CSR 中的 CommonName,也能检查请求的 IP 和域名, 这类控制器还算不得安全的机制。 只有完成彻底的检查,才有可能避免有恶意的、能够访问 kubelet 客户端证书的第三方为任何 IP 或域名请求服务证书。

为其他用户生成 kubeconfig 文件

在集群创建过程中,kubeadm init 对 super-admin.conf 中的证书进行签名时,将其配置为

Subject: O = system:masters, CN = kubernetes-super-admin。

system:masters

是一个例外的超级用户组,可以绕过鉴权层(例如 RBAC)。

文件 admin.conf 也由 kubeadm 在控制平面节点上创建,此文件包含设为

Subject: O = kubeadm:cluster-admins, CN = kubernetes-admin 的证书。

kubeadm:cluster-admins 是一个逻辑上属于 kubeadm 的组。

如果你的集群使用 RBAC(kubeadm 的默认设置),则 kubeadm:cluster-admins

组被绑定到 cluster-admin ClusterRole。

警告:

避免共享 super-admin.conf 或 admin.conf 文件。

实际上,即使是管理员等工作人员,也只为其创建最小访问权限,

这种最小权限的方案适用于除例外(应急)访问之外的所有场景。

你可以使用 kubeadm kubeconfig user

命令为其他用户生成 kubeconfig 文件,这个命令支持命令行参数和

kubeadm 配置结构。

以上命令会将 kubeconfig 打印到终端上,也可以使用 kubeadm kubeconfig user ... > somefile.conf

输出到一个文件中。

如下 kubeadm 可以在 --config 后加的配置文件示例:

# example.yaml

apiVersion: kubeadm.k8s.io/v1beta4

kind: ClusterConfiguration

# kubernetes 将作为 kubeconfig 中集群名称

clusterName: "kubernetes"

# some-dns-address:6443 将作为集群 kubeconfig 文件中服务地址(IP 或者 DNS 名称)

controlPlaneEndpoint: "some-dns-address:6443"

# 从本地挂载集群的 CA 秘钥和 CA 证书

certificatesDir: "/etc/kubernetes/pki"

确保这些设置与所需的目标集群设置相匹配。可以使用以下命令查看现有集群的设置:

kubectl get cm kubeadm-config -n kube-system -o=jsonpath="{.data.ClusterConfiguration}"

以下示例将为在 appdevs 组的 johndoe 用户创建一个有效期为 24 小时的 kubeconfig 文件:

kubeadm kubeconfig user --config example.yaml --org appdevs --client-name johndoe --validity-period 24h

以下示例将为管理员创建一个有效期有一周的 kubeconfig 文件:

kubeadm kubeconfig user --config example.yaml --client-name admin --validity-period 168h

签署由 kubeadm 生成的证书签名请求(CSR)

kubeadm certs generate-csr 命令为 kubeadm 所了解并管理的所有证书生成 CSR。

调用此命令将为常规证书生成 .csr / .key 文件对。

对于嵌入在 kubeconfig 文件中的证书,该命令将生成一个 .csr / .conf 对,

其中密钥已嵌入在 .conf 文件中。

CSR 文件包含 CA 签署证书的所有相关信息。 kubeadm 对其所有证书和 CSR 使用明确定义的规约。

默认证书目录是 /etc/kubernetes/pki,而 kubeconfig 文件的默认目录是 /etc/kubernetes。

这些默认值可以分别使用标志 --cert-dir 和 --kubeconfig-dir 覆盖。

要将自定义选项传递给 kubeadm certs generate-csr,可以使用 --config 标志,

此标志接受 kubeadm 配置文件,

与诸如 kubeadm init 这类命令相似。

所有规约(例如额外的 SAN 和自定义 IP 地址)都必须存储在同一配置文件中,

并通过将其作为 --config 传递来用于所有相关的 kubeadm 命令。

说明:

本指南使用默认的 Kubernetes 目录 /etc/kubernetes,需要超级用户权限。

如果你按照本指南使用你可以写入的目录

(通常这意味着使用 --cert-dir 和 --kubeconfig-dir 运行 kubeadm),你可以省略 sudo 命令。

然后,你必须将生成的文件复制到 /etc/kubernetes 目录下,以便 kubeadm init

或 kubeadm join 能够找到它们。

准备 CA 和服务帐户文件

在将执行 kubeadm init 的主控制平面节点上,执行以下命令:

sudo kubeadm init phase certs ca

sudo kubeadm init phase certs etcd-ca

sudo kubeadm init phase certs front-proxy-ca

sudo kubeadm init phase certs sa

这些操作将使用 kubeadm 所需的所有自签名 CA 文件(证书和密钥)

以及服务帐户(公钥和私钥)填充控制平面节点的 /etc/kubernetes/pki

和 /etc/kubernetes/pki/etcd 目录。

说明:

如果你使用外部 CA,则你必须在带外生成相同的文件,并手动将它们复制到主控制平面节点上的 /etc/kubernetes。

所有 CSR 被签名后,你可以删除根 CA 密钥(ca.key),如外部 CA 模式部分中所述。

对于辅助控制平面节点(kubeadm join --control-plane),无需执行前述命令。

根据你部署高可用集群的方式,

你要么从主控制平面节点手动复制相同的文件,要么使用 kubeadm init 的 --upload-certs 特性实现自动化分发。

生成 CSR

kubeadm certs generate-csr 命令为 kubeadm 所了解并管理的所有证书生成 CSR。

命令完成后,你必须手动删除不需要的 .csr、.conf 或 .key 文件。

kubelet.conf 的注意事项

本节适用于控制平面和工作节点。

如果你从控制平面节点(外部 CA 模式)上删除了 ca.key 文件,

则该集群中的运行的 kube-controller-manager 将无法签署 kubelet 客户端证书。

如果你的设置中不存在用于签署这些证书的外部方法

(例如外部签名者),你可以按照本指南中的说明手动签署 kubelet.conf.csr。

请注意,这也意味着自动

kubelet 客户端证书轮换将被禁用。

如果是这样,在证书即将到期时,你必须生成新的 kubelet.conf.csr,签署证书,

将其嵌入到 kubelet.conf 中并重新启动 kubelet。

如果这不适用于你的配置,你可以跳过在辅助控制平面和工作节点

(调用 kubeadm join ... 的所有节点)上处理 kubelet.conf.csr。

这是因为所运行的 kube-controller-manager 将负责签署新的 kubelet 客户端证书。

说明:

你必须在主控制平面节点(你最初运行 kubeadm init 的主机)上处理 kubelet.conf.csr,

这是因为 kubeadm 将该节点视为引导集群的节点,并且需要预先填充的 kubelet.conf。

控制平面节点

在主(kubeadm init)和辅助(kubeadm join --control-plane)

控制平面节点上执行以下命令以生成所有 CSR 文件:

sudo kubeadm certs generate-csr

如果要使用外部 etcd,请阅读 kubeadm 使用外部 etcd

指南了解 kubeadm 和 etcd 节点上需要哪些 CSR 文件。

你可以删除 /etc/kubernetes/pki/etcd 下的其他 .csr 和 .key 文件。

根据 kubelet.conf 的注意事项中的说明,

你可以决定保留或删除 kubelet.conf 和 kubelet.conf.csr 文件。

工作节点

根据 kubelet.conf 的注意事项中的解释,可以选择执行:

sudo kubeadm certs generate-csr

并仅保留 kubelet.conf 和 kubelet.conf.csr 文件,

或者完全跳过工作节点的步骤。

签署所有证书的 CSR

说明:

如果你使用外部 CA 并且已经拥有 openssl 的 CA 序列号文件(.srl),

你可以将此类文件复制到将处理 CSR 的 kubeadm 节点。

要复制的 .srl 文件有 /etc/kubernetes/pki/ca.srl、/etc/kubernetes/pki/front-proxy-ca.srl

和 /etc/kubernetes/pki/etcd/ca.srl。

然后可以将文件移动到将处理 CSR 文件的新节点。

如果节点上的 CA 缺少 .srl 文件,下面的脚本将生成一个具有随机起始序列号的新 SRL 文件。

要了解有关 .srl 文件的更多信息,请参阅

openssl

关于 --CAserial 标志的文档。

对具有 CSR 文件的所有节点重复此步骤。

在 /etc/kubernetes 目录中编写以下脚本,进入该目录并执行该脚本。

该脚本将为 /etc/kubernetes 目录下存在的所有 CSR 文件生成证书。

#!/bin/bash

# 设置证书过期时间(以天为单位)

DAYS=365

# 处理除 front-proxy 和 etcd 之外的所有 CSR 文件

find ./ -name "*.csr" | grep -v "pki/etcd" | grep -v "front-proxy" | while read -r FILE;

do

echo "* Processing ${FILE} ..."

FILE=${FILE%.*} # 修剪扩展名

if [ -f "./pki/ca.srl" ]; then

SERIAL_FLAG="-CAserial ./pki/ca.srl"

else

SERIAL_FLAG="-CAcreateserial"

fi

openssl x509 -req -days "${DAYS}" -CA ./pki/ca.crt -CAkey ./pki/ca.key ${SERIAL_FLAG} \

-in "${FILE}.csr" -out "${FILE}.crt"

sleep 2

done

# 处理所有 etcd CSR

find ./pki/etcd -name "*.csr" | while read -r FILE;

do

echo "* Processing ${FILE} ..."

FILE=${FILE%.*} # 修剪扩展名

if [ -f "./pki/etcd/ca.srl" ]; then

SERIAL_FLAG=-CAserial ./pki/etcd/ca.srl

else

SERIAL_FLAG=-CAcreateserial

fi

openssl x509 -req -days "${DAYS}" -CA ./pki/etcd/ca.crt -CAkey ./pki/etcd/ca.key ${SERIAL_FLAG} \

-in "${FILE}.csr" -out "${FILE}.crt"

done

# 处理前端代理 CSR

echo "* Processing ./pki/front-proxy-client.csr ..."

openssl x509 -req -days "${DAYS}" -CA ./pki/front-proxy-ca.crt -CAkey ./pki/front-proxy-ca.key -CAcreateserial \

-in ./pki/front-proxy-client.csr -out ./pki/front-proxy-client.crt

在 kubeconfig 文件中嵌入证书

对具有 CSR 文件的所有节点重复此步骤。

在 /etc/kubernetes 目录中编写以下脚本,进入该目录并执行脚本。

此脚本将基于上一步从 CSR 中得到为 kubeconfig 文件签名的 .crt 文件,

并将它们嵌入到 kubeconfig 文件中。

#!/bin/bash

CLUSTER=kubernetes

find ./ -name "*.conf" | while read -r FILE;

do

echo "* Processing ${FILE} ..."

KUBECONFIG="${FILE}" kubectl config set-cluster "${CLUSTER}" --certificate-authority ./pki/ca.crt --embed-certs

USER=$(KUBECONFIG="${FILE}" kubectl config view -o jsonpath='{.users[0].name}')

KUBECONFIG="${FILE}" kubectl config set-credentials "${USER}" --client-certificate "${FILE}.crt" --embed-certs

done

执行清理

在具有 CSR 文件的所有节点上执行此步骤。

在 /etc/kubernetes 目录中编写以下脚本,进入该目录并执行脚本。

#!/bin/bash

# 清理 CSR 文件

rm -f ./*.csr ./pki/*.csr ./pki/etcd/*.csr # 清理所有 CSR 文件

# 清理已嵌入 kubeconfig 文件中的 CRT 文件

rm -f ./*.crt

(可选)将 .srl 文件移动到下一个要处理的节点。

或者,如果使用外部 CA,请删除 /etc/kubernetes/pki/ca.key 文件,

如外部 CA 节点部分中所述。

kubeadm 节点初始化

一旦 CSR 文件被签名并且所需的证书在要用作节点的主机上就位,你就可以使用命令

kubeadm init 和 kubeadm join 使用这些节点创建 Kubernetes 集群。

在 init 和 join 期间,kubeadm 使用在主机本地文件系统的

/etc/kubernetes 目录中找到的现有证书、加密密钥和 kubeconfig 文件。

2.8 - 重新配置 kubeadm 集群

kubeadm 不支持自动重新配置部署在托管节点上的组件的方式。 一种自动化的方法是使用自定义的 operator。

要修改组件配置,你必须手动编辑磁盘上关联的集群对象和文件。 本指南展示了实现 kubeadm 集群重新配置所需执行的正确步骤顺序。

准备开始

- 你需要一个使用 kubeadm 部署的集群

- 拥有管理员凭据(

/etc/kubernetes/admin.conf) 和从安装了 kubectl 的主机到集群中正在运行的 kube-apiserver 的网络连接 - 在所有主机上安装文本编辑器

重新配置集群

kubeadm 在 ConfigMap 和其他对象中写入了一组集群范围的组件配置选项。

这些对象必须手动编辑,可以使用命令 kubectl edit。

kubectl edit 命令将打开一个文本编辑器,你可以在其中直接编辑和保存对象。

你可以使用环境变量 KUBECONFIG 和 KUBE_EDITOR 来指定 kubectl

使用的 kubeconfig 文件和首选文本编辑器的位置。

例如:

KUBECONFIG=/etc/kubernetes/admin.conf KUBE_EDITOR=nano kubectl edit <parameters>

说明:

保存对这些集群对象的任何更改后,节点上运行的组件可能不会自动更新。 以下步骤将指导你如何手动执行该操作。

警告:

ConfigMaps 中的组件配置存储为非结构化数据(YAML 字符串)。 这意味着在更新 ConfigMap 的内容时不会执行验证。 你必须小心遵循特定组件配置的文档化 API 格式, 并避免引入拼写错误和 YAML 缩进错误。

应用集群配置更改

更新 ClusterConfiguration

在集群创建和升级期间,kubeadm 将其

ClusterConfiguration

写入 kube-system 命名空间中名为 kubeadm-config 的 ConfigMap。

要更改 ClusterConfiguration 中的特定选项,你可以使用以下命令编辑 ConfigMap:

kubectl edit cm -n kube-system kubeadm-config

配置位于 data.ClusterConfiguration 键下。

说明:

ClusterConfiguration 包括各种影响单个组件配置的选项, 例如

kube-apiserver、kube-scheduler、kube-controller-manager、

CoreDNS、etcd 和 kube-proxy。 对配置的更改必须手动反映在节点组件上。

在控制平面节点上反映 ClusterConfiguration 更改

kubeadm 将控制平面组件作为位于 /etc/kubernetes/manifests

目录中的静态 Pod 清单进行管理。

对 apiServer、controllerManager、scheduler 或 etcd键下的

ClusterConfiguration 的任何更改都必须反映在控制平面节点上清单目录中的关联文件中。

此类更改可能包括:

extraArgs- 需要更新传递给组件容器的标志列表extraVolumes- 需要更新组件容器的卷挂载*SANs- 需要使用更新的主题备用名称编写新证书

在继续进行这些更改之前,请确保你已备份目录 /etc/kubernetes/。

要编写新证书,你可以使用:

kubeadm init phase certs <component-name> --config <config-file>

要在 /etc/kubernetes/manifests 中编写新的清单文件,你可以使用以下命令:

# Kubernetes 控制平面组件

kubeadm init phase control-plane <component-name> --config <config-file>

# 本地 etcd

kubeadm init phase etcd local --config <config-file>

<config-file> 内容必须与更新后的 ClusterConfiguration 匹配。

<component-name> 值必须是一个控制平面组件(apiserver、controller-manager 或 scheduler)的名称。

说明:

更新 /etc/kubernetes/manifests 中的文件将告诉 kubelet 重新启动相应组件的静态 Pod。

尝试一次对一个节点进行这些更改,以在不停机的情况下离开集群。

应用 kubelet 配置更改

更新 KubeletConfiguration

在集群创建和升级期间,kubeadm 将其

KubeletConfiguration

写入 kube-system 命名空间中名为 kubelet-config 的 ConfigMap。

你可以使用以下命令编辑 ConfigMap:

kubectl edit cm -n kube-system kubelet-config

配置位于 data.kubelet 键下。

反映 kubelet 的更改

要反映 kubeadm 节点上的更改,你必须执行以下操作:

- 登录到 kubeadm 节点

- 运行

kubeadm upgrade node phase kubelet-config下载最新的kubelet-configConfigMap 内容到本地文件/var/lib/kubelet/config.yaml - 编辑文件

/var/lib/kubelet/kubeadm-flags.env以使用标志来应用额外的配置 - 使用

systemctl restart kubelet重启 kubelet 服务

说明:

一次执行一个节点的这些更改,以允许正确地重新安排工作负载。

说明:

在 kubeadm upgrade 期间,kubeadm 从 kubelet-config ConfigMap

下载 KubeletConfiguration 并覆盖 /var/lib/kubelet/config.yaml 的内容。

这意味着节点本地配置必须通过/var/lib/kubelet/kubeadm-flags.env中的标志或在

kubeadm upgrade后手动更新/var/lib/kubelet/config.yaml` 的内容来应用,

然后重新启动 kubelet。

应用 kube-proxy 配置更改

更新 KubeProxyConfiguration

在集群创建和升级期间,kubeadm 将其写入

KubeProxyConfiguration

在名为 kube-proxy 的 kube-system 命名空间中的 ConfigMap 中。

此 ConfigMap 由 kube-system 命名空间中的 kube-proxy DaemonSet 使用。

要更改 KubeProxyConfiguration 中的特定选项,你可以使用以下命令编辑 ConfigMap:

kubectl edit cm -n kube-system kube-proxy

配置位于 data.config.conf 键下。

反映 kube-proxy 的更改

更新 kube-proxy ConfigMap 后,你可以重新启动所有 kube-proxy Pod:

使用以下命令删除 Pod:

kubectl delete po -n kube-system -l k8s-app=kube-proxy

将创建使用更新的 ConfigMap 的新 Pod。

说明:

由于 kubeadm 将 kube-proxy 部署为 DaemonSet,因此不支持特定于节点的配置。

应用 CoreDNS 配置更改

更新 CoreDNS 的 Deployment 和 Service

kubeadm 将 CoreDNS 部署为名为 coredns 的 Deployment,并使用 Service kube-dns,

两者都在 kube-system 命名空间中。

要更新任何 CoreDNS 设置,你可以编辑 Deployment 和 Service:

kubectl edit deployment -n kube-system coredns

kubectl edit service -n kube-system kube-dns

反映 CoreDNS 的更改

应用 CoreDNS 更改后,你可以删除 CoreDNS Pod。

获取 Pod 名称:

kubectl get po -n kube-system | grep coredns

使用以下命令删除 Pod:

kubectl delete po -n kube-system <pod-name>

将创建具有更新的 CoreDNS 配置的新 Pod。

说明:

kubeadm 不允许在集群创建和升级期间配置 CoreDNS。

这意味着如果执行了 kubeadm upgrade apply,你对

CoreDNS 对象的更改将丢失并且必须重新应用。

持久化重新配置

在受管节点上执行 kubeadm upgrade 期间,kubeadm

可能会覆盖在创建集群(重新配置)后应用的配置。

持久化 Node 对象重新配置

kubeadm 在特定 Kubernetes 节点的 Node 对象上写入标签、污点、CRI 套接字和其他信息。要更改此 Node 对象的任何内容,你可以使用:

kubectl edit no <node-name>

在 kubeadm upgrade 期间,此类节点的内容可能会被覆盖。

如果你想在升级后保留对 Node 对象的修改,你可以准备一个

kubectl patch

并将其应用到 Node 对象:

kubectl patch no <node-name> --patch-file <patch-file>

持久化控制平面组件重新配置

控制平面配置的主要来源是存储在集群中的 ClusterConfiguration 对象。

要扩展静态 Pod 清单配置,可以使用

patches。

这些补丁文件必须作为文件保留在控制平面节点上,以确保它们可以被

kubeadm upgrade ... --patches <directory> 使用。

如果对 ClusterConfiguration 和磁盘上的静态 Pod 清单进行了重新配置,则必须相应地更新节点特定补丁集。

持久化 kubelet 重新配置

对存储在 /var/lib/kubelet/config.yaml 中的 KubeletConfiguration

所做的任何更改都将在 kubeadm upgrade 时因为下载集群范围内的 kubelet-config

ConfigMap 的内容而被覆盖。

要持久保存 kubelet 节点特定的配置,文件 /var/lib/kubelet/config.yaml

必须在升级后手动更新,或者文件 /var/lib/kubelet/kubeadm-flags.env 可以包含标志。

kubelet 标志会覆盖相关的 KubeletConfiguration 选项,但请注意,有些标志已被弃用。

更改 /var/lib/kubelet/config.yaml 或 /var/lib/kubelet/kubeadm-flags.env

后需要重启 kubelet。

接下来

2.9 - 更改 Kubernetes 软件包仓库

本页介绍了如何在升级集群时启用包含 Kubernetes 次要版本的软件包仓库。

这仅适用于使用托管在 pkgs.k8s.io 上社区自治软件包仓库的用户。

启用新的 Kubernetes 小版本的软件包仓库。与传统的软件包仓库不同,

社区自治的软件包仓库所采用的结构为每个 Kubernetes 小版本都有一个专门的软件包仓库。

说明:

本指南仅介绍 Kubernetes 升级过程的一部分。 有关升级 Kubernetes 集群的更多信息, 请参阅升级指南。

说明:

仅在将集群升级到另一个次要版本时才需要执行此步骤。 如果你要升级到同一次要版本中的另一个补丁版本(例如:v1.32.5 到 v1.32.7)则不需要遵循本指南。 但是,如果你仍在使用旧的软件包仓库,则需要在升级之前迁移到社区自治的新软件包仓库 (有关如何执行此操作的更多详细信息,请参阅下一节)。

准备开始

本文假设你已经在使用社区自治的软件包仓库(pkgs.k8s.io)。如果不是这种情况,

强烈建议按照官方公告中所述,

迁移到社区自治的软件包仓库。

apt.kubernetes.io 和yum.kubernetes.io)。

强烈建议使用托管在 pkgs.k8s.io 上的新软件包仓库来安装 2023 年 9 月 13 日之后发布的 Kubernetes 版本。

旧版软件包仓库已被弃用,其内容可能在未来的任何时间被删除,恕不另行通知。新的软件包仓库提供了从 Kubernetes v1.24.0 版本开始的下载。验证是否正在使用 Kubernetes 软件包仓库

如果你不确定自己是在使用社区自治的软件包仓库还是在使用老旧的软件包仓库, 可以执行以下步骤进行验证:

打印定义 Kubernetes apt 仓库的文件的内容:

# 在你的系统上,此配置文件可能具有不同的名称

pager /etc/apt/sources.list.d/kubernetes.list

如果你看到类似以下的一行:

deb [signed-by=/etc/apt/keyrings/kubernetes-apt-keyring.gpg] https://pkgs.k8s.io/core:/stable:/v1.31/deb/ /

你正在使用 Kubernetes 软件包仓库,本指南适用于你。 否则,强烈建议按照官方公告中所述, 迁移到 Kubernetes 软件包仓库。

打印定义 Kubernetes yum 仓库的文件的内容:

# 在你的系统上,此配置文件可能具有不同的名称

cat /etc/yum.repos.d/kubernetes.repo

如果你看到的 baseurl 类似以下输出中的 baseurl:

[kubernetes]

name=Kubernetes

baseurl=https://pkgs.k8s.io/core:/stable:/v1.31/rpm/

enabled=1

gpgcheck=1

gpgkey=https://pkgs.k8s.io/core:/stable:/v1.31/rpm/repodata/repomd.xml.key

exclude=kubelet kubeadm kubectl

你正在使用 Kubernetes 软件包仓库,本指南适用于你。 否则,强烈建议按照官方公告中所述, 迁移到 Kubernetes 软件包仓库。

打印定义 Kubernetes zypper 仓库的文件的内容:

# 在你的系统上,此配置文件可能具有不同的名称

cat /etc/zypp/repos.d/kubernetes.repo

如果你看到的 baseurl 类似以下输出中的 baseurl:

[kubernetes]

name=Kubernetes

baseurl=https://pkgs.k8s.io/core:/stable:/v1.31/rpm/

enabled=1

gpgcheck=1

gpgkey=https://pkgs.k8s.io/core:/stable:/v1.31/rpm/repodata/repomd.xml.key

exclude=kubelet kubeadm kubectl

你正在使用 Kubernetes 软件包仓库,本指南适用于你。 否则,强烈建议按照官方公告中所述, 迁移到 Kubernetes 软件包仓库。

说明:

Kubernetes 软件包仓库所用的 URL 不仅限于 pkgs.k8s.io,还可以是以下之一:

pkgs.k8s.iopkgs.kubernetes.iopackages.kubernetes.io

切换到其他 Kubernetes 软件包仓库

在从一个 Kubernetes 小版本升级到另一个版本时,应执行此步骤以获取所需 Kubernetes 小版本的软件包访问权限。

使用你所选择的文本编辑器打开定义 Kubernetes

apt仓库的文件:nano /etc/apt/sources.list.d/kubernetes.list你应该看到一行包含当前 Kubernetes 小版本的 URL。 例如,如果你正在使用 v1.31,你应该看到类似以下的输出:

deb [signed-by=/etc/apt/keyrings/kubernetes-apt-keyring.gpg] https://pkgs.k8s.io/core:/stable:/v1.31/deb/ /

将 URL 中的版本更改为下一个可用的小版本,例如:

deb [signed-by=/etc/apt/keyrings/kubernetes-apt-keyring.gpg] https://pkgs.k8s.io/core:/stable:/v1.32/deb/ /

- 保存文件并退出文本编辑器。继续按照相关的升级说明进行操作。

使用你所选择的文本编辑器打开定义 Kubernetes

yum仓库的文件:nano /etc/yum.repos.d/kubernetes.repo你应该看到一个文件包含当前 Kubernetes 小版本的两个 URL。 例如,如果你正在使用 v1.31,你应该看到类似以下的输出:

[kubernetes] name=Kubernetes baseurl=https://pkgs.k8s.io/core:/stable:/v1.31/rpm/ enabled=1 gpgcheck=1 gpgkey=https://pkgs.k8s.io/core:/stable:/v1.31/rpm/repodata/repomd.xml.key exclude=kubelet kubeadm kubectl cri-tools kubernetes-cni

将这些 URL 中的版本更改为下一个可用的小版本,例如:

[kubernetes] name=Kubernetes baseurl=https://pkgs.k8s.io/core:/stable:/v1.32/rpm/ enabled=1 gpgcheck=1 gpgkey=https://pkgs.k8s.io/core:/stable:/v1.32/rpm/repodata/repomd.xml.key exclude=kubelet kubeadm kubectl cri-tools kubernetes-cni

- 保存文件并退出文本编辑器。继续按照相关的升级说明进行操作。

接下来

- 参见如何升级 Linux 节点的说明。

- 参见如何升级 Windows 节点的说明。

3 - 从 dockershim 迁移

本节提供从 dockershim 迁移到其他容器运行时的必备知识。

自从 Kubernetes 1.20 宣布 弃用 dockershim, 各类疑问随之而来:这对各类工作负载和 Kubernetes 部署会产生什么影响。 我们的弃用 Dockershim 常见问题可以帮助你更好地理解这个问题。

Dockershim 在 Kubernetes v1.24 版本已经被移除。 如果你集群内是通过 dockershim 使用 Docker Engine 作为容器运行时,并希望 Kubernetes 升级到 v1.24, 建议你迁移到其他容器运行时或使用其他方法以获得 Docker 引擎支持。

请参阅容器运行时 一节以了解可用的备选项。

带 dockershim 的 Kubernetes 版本 (1.23) 已不再支持, v1.24 很快也将不再支持。

当在迁移过程中遇到麻烦,请上报问题。 那么问题就可以及时修复,你的集群也可以进入移除 dockershim 前的就绪状态。 在 v1.24 支持结束后,如果出现影响集群的严重问题, 你需要联系你的 Kubernetes 供应商以获得支持或一次升级多个版本。

你的集群中可以有不止一种类型的节点,尽管这不是常见的情况。

下面这些任务可以帮助你完成迁移:

接下来

3.1 - 将节点上的容器运行时从 Docker Engine 改为 containerd

本任务给出将容器运行时从 Docker 改为 containerd 所需的步骤。 此任务适用于运行 1.23 或更早版本 Kubernetes 的集群操作人员。 同时,此任务也涉及从 dockershim 迁移到 containerd 的示例场景。 有关其他备选的容器运行时,可查阅 此页面进行拣选。

准备开始

安装 containerd。进一步的信息可参见 containerd 的安装文档。 关于一些特定的环境准备工作,请遵循 containerd 指南。

腾空节点

kubectl drain <node-to-drain> --ignore-daemonsets

将 <node-to-drain> 替换为你所要腾空的节点的名称。

停止 Docker 守护进程

systemctl stop kubelet

systemctl disable docker.service --now

安装 Containerd

遵循此指南 了解安装 containerd 的详细步骤。

- 从官方的 Docker 仓库安装

containerd.io包。关于为你所使用的 Linux 发行版来设置 Docker 仓库,以及安装containerd.io包的详细说明, 可参见开始使用 containerd。

配置 containerd:

sudo mkdir -p /etc/containerd containerd config default | sudo tee /etc/containerd/config.toml

重启 containerd:

sudo systemctl restart containerd

启动一个 Powershell 会话,将 $Version 设置为期望的版本(例如:$Version="1.4.3"),

之后运行下面的命令:

下载 containerd:

curl.exe -L https://github.com/containerd/containerd/releases/download/v$Version/containerd-$Version-windows-amd64.tar.gz -o containerd-windows-amd64.tar.gz tar.exe xvf .\containerd-windows-amd64.tar.gz

解压缩并执行配置:

Copy-Item -Path ".\bin\" -Destination "$Env:ProgramFiles\containerd" -Recurse -Force cd $Env:ProgramFiles\containerd\ .\containerd.exe config default | Out-File config.toml -Encoding ascii # 请审查配置信息。取决于你的安装环境,你可能需要调整: # - sandbox_image (Kubernetes pause 镜像) # - CNI 的 bin_dir 和 conf_dir 的位置 Get-Content config.toml # (可选步骤,但强烈建议执行)将 containerd 排除在 Windows Defender 扫描之外 Add-MpPreference -ExclusionProcess "$Env:ProgramFiles\containerd\containerd.exe"

启动 containerd:

.\containerd.exe --register-service Start-Service containerd

配置 kubelet 使用 containerd 作为其容器运行时

编辑文件 /var/lib/kubelet/kubeadm-flags.env,将 containerd 运行时添加到标志中;

--container-runtime-endpoint=unix:///run/containerd/containerd.sock。

使用 kubeadm 的用户应该知道,kubeadm 工具将每个主机的 CRI 套接字保存在该主机对应的

Node 对象的注解中。

要更改这一注解信息,你可以在一台包含 kubeadm /etc/kubernetes/admin.conf 文件的机器上执行以下命令:

kubectl edit no <node-name>

这一命令会打开一个文本编辑器,供你在其中编辑 Node 对象。

要选择不同的文本编辑器,你可以设置 KUBE_EDITOR 环境变量。

更改

kubeadm.alpha.kubernetes.io/cri-socket值,将其从/var/run/dockershim.sock改为你所选择的 CRI 套接字路径 (例如:unix:///run/containerd/containerd.sock)。注意新的 CRI 套接字路径必须带有

unix://前缀。保存文本编辑器中所作的修改,这会更新 Node 对象。

重启 kubelet

systemctl start kubelet

验证节点处于健康状态

运行 kubectl get nodes -o wide,containerd 会显示为我们所更改的节点上的运行时。

移除 Docker Engine

如果节点显示正常,删除 Docker。

sudo yum remove docker-ce docker-ce-cli

sudo apt-get purge docker-ce docker-ce-cli

sudo dnf remove docker-ce docker-ce-cli

sudo apt-get purge docker-ce docker-ce-cli

上面的命令不会移除你的主机上的镜像、容器、卷或者定制的配置文件。 要删除这些内容,参阅 Docker 的指令来卸载 Docker Engine。

注意:

Docker 所提供的卸载 Docker Engine 命令指导中,存在删除 containerd 的风险。 在执行命令时要谨慎。

uncordon 节点

kubectl uncordon <node-to-uncordon>

将 <node-to-uncordon> 替换为你之前腾空的节点的名称。

3.2 - 将 Docker Engine 节点从 dockershim 迁移到 cri-dockerd

本页面为你展示如何迁移你的 Docker Engine 节点,使之使用 cri-dockerd 而不是 dockershim。

在以下场景中,你可以遵从这里的步骤执行操作:

- 你期望不再使用 dockershim,但仍然使用 Docker Engine 来在 Kubernetes 中运行容器。

- 你希望升级到 Kubernetes v1.32 且你的现有集群依赖于 dockershim,

因此你必须放弃 dockershim,而

cri-dockerd是你的一种选项。

要进一步了解 dockershim 的移除,请阅读 FAQ 页面。

cri-dockerd 是什么?

在 Kubernetes v1.24 及更早版本中,你可以在 Kubernetes 中使用 Docker Engine,

依赖于一个称作 dockershim 的内置 Kubernetes 组件。

dockershim 组件在 Kubernetes v1.24 发行版本中已被移除;不过,一种来自第三方的替代品,

cri-dockerd 是可供使用的。cri-dockerd 适配器允许你通过

容器运行时接口(Container Runtime Interface,CRI)

来使用 Docker Engine。

说明:

如果你已经在使用 cri-dockerd,那么你不会被 dockershim 的移除影响到。

在开始之前,检查你的节点是否在使用 dockershim。

如果你想要迁移到 cri-dockerd 以便继续使用 Docker Engine 作为你的容器运行时,

你需要在所有被影响的节点上执行以下操作:

- 安装

cri-dockerd; - 隔离(Cordon)并腾空(Drain)该节点;

- 配置 kubelet 使用

cri-dockerd; - 重新启动 kubelet;

- 验证节点处于健康状态。

首先在非关键节点上测试这一迁移过程。

你应该针对所有希望迁移到 cri-dockerd 的节点执行以下步骤。

准备开始

- 安装了

cri-dockerd并且该服务已经在各节点上启动; - 一个网络插件。

隔离并腾空节点

隔离节点,阻止新的 Pod 被调度到节点上:

kubectl cordon <NODE_NAME>将

<NODE_NAME>替换为节点名称。

腾空节点以安全地逐出所有运行中的 Pod:

kubectl drain <NODE_NAME> --ignore-daemonsets

配置 kubelet 使用 cri-dockerd

下面的步骤适用于用 kubeadm 工具安装的集群。如果你使用不同的工具, 你需要使用针对该工具的配置指令来修改 kubelet。

- 在每个被影响的节点上,打开

/var/lib/kubelet/kubeadm-flags.env文件; - 将

--container-runtime-endpoint标志,将其设置为unix:///var/run/cri-dockerd.sock。 - 将

--container-runtime标志修改为remote(在 Kubernetes v1.27 及更高版本中不可用)。

kubeadm 工具将节点上的套接字存储为控制面上 Node 对象的注解。

要为每个被影响的节点更改此套接字:

编辑

Node对象的 YAML 表示:KUBECONFIG=/path/to/admin.conf kubectl edit no <NODE_NAME>根据下面的说明执行替换:

/path/to/admin.conf:指向 kubectl 配置文件admin.conf的路径;<NODE_NAME>:你要修改的节点的名称。

将

kubeadm.alpha.kubernetes.io/cri-socket标志从/var/run/dockershim.sock更改为unix:///var/run/cri-dockerd.sock;保存所作更改。保存时,

Node对象被更新。

重启 kubelet

systemctl restart kubelet

验证节点处于健康状态

要检查节点是否在使用 cri-dockerd 端点,

按照找出你所使用的运行时页面所给的指令操作。

kubelet 的 --container-runtime-endpoint 标志取值应该是 unix:///var/run/cri-dockerd.sock。

解除节点隔离

kubectl uncordon <NODE_NAME>

接下来

3.3 - 查明节点上所使用的容器运行时

本页面描述查明集群中节点所使用的容器运行时 的步骤。

取决于你运行集群的方式,节点所使用的容器运行时可能是事先配置好的,

也可能需要你来配置。如果你在使用托管的 Kubernetes 服务,

可能存在特定于厂商的方法来检查节点上配置的容器运行时。

本页描述的方法应该在能够执行 kubectl 的场合下都可以工作。

准备开始

安装并配置 kubectl。参见安装工具 节了解详情。

查明节点所使用的容器运行时

使用 kubectl 来读取并显示节点信息:

kubectl get nodes -o wide

输出如下面所示。CONTAINER-RUNTIME 列给出容器运行时及其版本。

对于 Docker Engine,输出类似于:

NAME STATUS VERSION CONTAINER-RUNTIME

node-1 Ready v1.16.15 docker://19.3.1

node-2 Ready v1.16.15 docker://19.3.1

node-3 Ready v1.16.15 docker://19.3.1

如果你的容器运行时显示为 Docker Engine,你仍然可能不会被 v1.24 中 dockershim 的移除所影响。 通过检查运行时端点,可以查看你是否在使用 dockershim。 如果你没有使用 dockershim,你就不会被影响。

对于 containerd,输出类似于这样:

# For containerd

NAME STATUS VERSION CONTAINER-RUNTIME

node-1 Ready v1.19.6 containerd://1.4.1

node-2 Ready v1.19.6 containerd://1.4.1

node-3 Ready v1.19.6 containerd://1.4.1

你可以在容器运行时 页面找到与容器运行时相关的更多信息。

检查当前使用的运行时端点

容器运行时使用 Unix Socket 与 kubelet 通信,这一通信使用基于 gRPC 框架的 CRI 协议。kubelet 扮演客户端,运行时扮演服务器端。 在某些情况下,你可能想知道你的节点使用的是哪个 socket。 如若集群是 Kubernetes v1.24 及以后的版本, 或许你想知道当前运行时是否是使用 dockershim 的 Docker Engine。

说明:

如果你的节点在通过 cri-dockerd 使用 Docker Engine,

那么集群不会受到 Kubernetes 移除 dockershim 的影响。

可以通过检查 kubelet 的参数得知当前使用的是哪个 socket。

查看 kubelet 进程的启动命令

tr \\0 ' ' < /proc/"$(pgrep kubelet)"/cmdline如有节点上没有

tr或者pgrep,就需要手动检查 kubelet 的启动命令

在命令的输出中,查找

--container-runtime和--container-runtime-endpoint标志。- 如果你的节点使用 Kubernetes v1.23 或更早的版本,这两个参数不存在,

或者

--container-runtime标志值不是remote,则你在通过 dockershim 套接字使用 Docker Engine。 在 Kubernetes v1.27 及以后的版本中,--container-runtime命令行参数不再可用。 - 如果设置了

--container-runtime-endpoint参数,查看套接字名称即可得知当前使用的运行时。 如若套接字unix:///run/containerd/containerd.sock是 containerd 的端点。

- 如果你的节点使用 Kubernetes v1.23 或更早的版本,这两个参数不存在,

或者

如果你将节点上的容器运行时从 Docker Engine 改变为 containerd,可在

迁移到不同的运行时

找到更多信息。或者,如果你想在 Kubernetes v1.24 及以后的版本仍使用 Docker Engine,

可以安装 CRI 兼容的适配器实现,如 cri-dockerd。

3.4 - 排查 CNI 插件相关的错误

为了避免 CNI 插件相关的错误,需要验证你正在使用或升级到一个经过测试的容器运行时, 该容器运行时能够在你的 Kubernetes 版本上正常工作。

关于 "Incompatible CNI versions" 和 "Failed to destroy network for sandbox" 错误

在 containerd v1.6.0-v1.6.3 中,当配置或清除 Pod CNI 网络时,如果 CNI 插件没有升级和/或 CNI 配置文件中没有声明 CNI 配置版本时,会出现服务问题。containerd 团队报告说: “这些问题在 containerd v1.6.4 中得到了解决。”

在使用 containerd v1.6.0-v1.6.3 时,如果你不升级 CNI 插件和/或声明 CNI 配置版本, 你可能会遇到以下 "Incompatible CNI versions" 或 "Failed to destroy network for sandbox" 错误状况。

Incompatible CNI versions 错误

如果因为配置版本比插件版本新,导致你的 CNI 插件版本与配置中的插件版本无法正确匹配时, 在启动 Pod 时,containerd 日志可能会显示类似的错误信息:

incompatible CNI versions; config is \"1.0.0\", plugin supports [\"0.1.0\" \"0.2.0\" \"0.3.0\" \"0.3.1\" \"0.4.0\"]"

为了解决这个问题,需要更新你的 CNI 插件和 CNI 配置文件。

Failed to destroy network for sandbox 错误

如果 CNI 插件配置中未给出插件的版本, Pod 可能可以运行。但是,停止 Pod 时会产生类似于以下错误:

ERROR[2022-04-26T00:43:24.518165483Z] StopPodSandbox for "b" failed

error="failed to destroy network for sandbox \"bbc85f891eaf060c5a879e27bba9b6b06450210161dfdecfbb2732959fb6500a\": invalid version \"\": the version is empty"

此错误使 Pod 处于未就绪状态,且仍然挂接到某网络名字空间上。 为修复这一问题,编辑 CNI 配置文件以添加缺失的版本信息。 下一次尝试停止 Pod 应该会成功。

更新你的 CNI 插件和 CNI 配置文件

如果你使用 containerd v1.6.0-v1.6.3 并遇到 "Incompatible CNI versions" 或者 "Failed to destroy network for sandbox" 错误,考虑更新你的 CNI 插件并编辑 CNI 配置文件。

以下是针对各节点要执行的典型步骤的概述:

- 停止容器运行时和 kubelet 服务后,执行以下升级操作:

- 如果你正在运行 CNI 插件,请将它们升级到最新版本。

- 如果你使用的是非 CNI 插件,请将它们替换为 CNI 插件,并使用最新版本的插件。

- 更新插件配置文件以指定或匹配 CNI 规范支持的插件版本, 如后文 "containerd 配置文件示例"章节所示。

- 对于

containerd,请确保你已安装 CNI loopback 插件的最新版本(v1.0.0 或更高版本)。 - 将节点组件(例如 kubelet)升级到 Kubernetes v1.24

- 升级到或安装最新版本的容器运行时。

- 通过重新启动容器运行时和 kubelet 将节点重新加入到集群。取消节点隔离(

kubectl uncordon <nodename>)。

containerd 配置文件示例

以下示例显示了 containerd 运行时 v1.6.x 的配置,

它支持最新版本的 CNI 规范(v1.0.0)。

请参阅你的插件和网络提供商的文档,以获取有关你系统配置的进一步说明。

在 Kubernetes 中,作为其默认行为,containerd 运行时为 Pod 添加一个本地回路接口:lo。

containerd 运行时通过 CNI 插件 loopback 配置本地回路接口。loopback 插件作为 containerd 发布包的一部分,扮演 cni 角色。

containerd v1.6.0 及更高版本包括与 CNI v1.0.0 兼容的 loopback 插件以及其他默认 CNI 插件。

loopback 插件的配置由 containerd 内部完成,并被设置为使用 CNI v1.0.0。

这也意味着当这个更新版本的 containerd 启动时,loopback 插件的版本必然是 v1.0.0 或更高版本。

以下 Bash 命令生成一个 CNI 配置示例。这里,cniVersion 字段被设置为配置版本值 1.0.0,

以供 containerd 调用 CNI 桥接插件时使用。

cat << EOF | tee /etc/cni/net.d/10-containerd-net.conflist

{

"cniVersion": "1.0.0",

"name": "containerd-net",

"plugins": [

{

"type": "bridge",

"bridge": "cni0",

"isGateway": true,

"ipMasq": true,

"promiscMode": true,

"ipam": {

"type": "host-local",

"ranges": [

[{

"subnet": "10.88.0.0/16"

}],

[{

"subnet": "2001:db8:4860::/64"

}]

],

"routes": [

{ "dst": "0.0.0.0/0" },

{ "dst": "::/0" }

]

}

},

{

"type": "portmap",

"capabilities": {"portMappings": true},

"externalSetMarkChain": "KUBE-MARK-MASQ"

}

]

}

EOF

基于你的用例和网络地址规划,将前面示例中的 IP 地址范围更新为合适的值。

3.5 - 检查移除 Dockershim 是否对你有影响

Kubernetes 的 dockershim 组件使得你可以把 Docker 用作 Kubernetes 的

容器运行时。

在 Kubernetes v1.24 版本中,内建组件 dockershim 被移除。

本页讲解你的集群把 Docker 用作容器运行时的运作机制,

并提供使用 dockershim 时,它所扮演角色的详细信息,

继而展示了一组操作,可用来检查移除 dockershim 对你的工作负载是否有影响。

检查你的应用是否依赖于 Docker

即使你是通过 Docker 创建的应用容器,也不妨碍你在其他任何容器运行时上运行这些容器。 这种使用 Docker 的方式并不构成对 Docker 作为一个容器运行时的依赖。

当用了别的容器运行时之后,Docker 命令可能不工作,或者产生意外的输出。 下面是判定你是否依赖于 Docker 的方法。

- 确认没有特权 Pod 执行 Docker 命令(如

docker ps)、重新启动 Docker 服务(如systemctl restart docker.service)或修改 Docker 配置文件/etc/docker/daemon.json。 - 检查 Docker 配置文件(如

/etc/docker/daemon.json)中容器镜像仓库的镜像(mirror)站点设置。 这些配置通常需要针对不同容器运行时来重新设置。 - 检查确保在 Kubernetes 基础设施之外的节点上运行的脚本和应用程序没有执行 Docker 命令。

可能的情况有:

- SSH 到节点排查故障;

- 节点启动脚本;

- 直接安装在节点上的监控和安全代理。

- 检查执行上述特权操作的第三方工具。 详细操作请参考从 dockershim 迁移遥测和安全代理。

- 确认没有对 dockershim 行为的间接依赖。这是一种极端情况,不太可能影响你的应用。 一些工具很可能被配置为使用了 Docker 特性,比如,基于特定指标发警报, 或者在故障排查指令的一个环节中搜索特定的日志信息。 如果你有此类配置的工具,需要在迁移之前,在测试集群上测试这类行为。

Docker 依赖详解

容器运行时是一个软件, 用来运行组成 Kubernetes Pod 的容器。 Kubernetes 负责编排和调度 Pod;在每一个节点上,kubelet 使用抽象的容器运行时接口,所以你可以任意选用兼容的容器运行时。

在早期版本中,Kubernetes 提供的兼容性支持一个容器运行时:Docker。

在 Kubernetes 后来的发展历史中,集群运营人员希望采用别的容器运行时。

于是 CRI 被设计出来满足这类灵活性需求 - 而 kubelet 亦开始支持 CRI。

然而,因为 Docker 在 CRI 规范创建之前就已经存在,Kubernetes 就创建了一个适配器组件 dockershim。

dockershim 适配器允许 kubelet 与 Docker 交互,就好像 Docker 是一个 CRI 兼容的运行时一样。

你可以阅读博文 Kubernetes 正式支持集成 Containerd。

切换到 Containerd 容器运行时可以消除掉中间环节。 所有相同的容器都可由 Containerd 这类容器运行时来运行。 但是现在,由于直接用容器运行时调度容器,它们对 Docker 是不可见的。 因此,你以前用来检查这些容器的 Docker 工具或漂亮的 UI 都不再可用。

你不能再使用 docker ps 或 docker inspect 命令来获取容器信息。

由于你不能列出容器,因此你不能获取日志、停止容器,甚至不能通过 docker exec 在容器中执行命令。

说明:

如果你在用 Kubernetes 运行工作负载,最好通过 Kubernetes API 停止容器, 而不是通过容器运行时来停止它们(此建议适用于所有容器运行时,不仅仅是针对 Docker)。

你仍然可以下载镜像,或者用 docker build 命令创建它们。

但用 Docker 创建、下载的镜像,对于容器运行时和 Kubernetes,均不可见。

为了在 Kubernetes 中使用,需要把镜像推送(push)到某镜像仓库。

已知问题

一些文件系统指标缺失并且指标格式不同

Kubelet /metrics/cadvisor 端点提供 Prometheus 指标,

如 Kubernetes 系统组件指标 中所述。

如果你安装了一个依赖该端点的指标收集器,你可能会看到以下问题:

Docker 节点上的指标格式为

k8s_<container-name>_<pod-name>_<namespace>_<pod-uid>_<restart-count>, 但其他运行时的格式不同。例如,在 containerd 节点上它是<container-id>。一些文件系统指标缺失,如下所示:

container_fs_inodes_free container_fs_inodes_total container_fs_io_current container_fs_io_time_seconds_total container_fs_io_time_weighted_seconds_total container_fs_limit_bytes container_fs_read_seconds_total container_fs_reads_merged_total container_fs_sector_reads_total container_fs_sector_writes_total container_fs_usage_bytes container_fs_write_seconds_total container_fs_writes_merged_total

解决方法

你可以通过使用 cAdvisor 作为一个独立的守护程序来缓解这个问题。

- 找到名称格式为

vX.Y.Z-containerd-cri的最新 cAdvisor 版本(例如v0.42.0-containerd-cri)。 - 按照 cAdvisor Kubernetes Daemonset 中的步骤来创建守护进程。

- 将已安装的指标收集器指向使用 cAdvisor 的

/metrics端点。 该端点提供了全套的 Prometheus 容器指标。

替代方案:

- 使用替代的第三方指标收集解决方案。

- 从 Kubelet 摘要 API 收集指标,该 API 在

/stats/summary提供服务。

接下来

- 阅读从 dockershim 迁移, 以了解你的下一步工作。

- 阅读弃用 Dockershim 的常见问题,了解更多信息。

3.6 - 从 dockershim 迁移遥测和安全代理

Kubernetes 对与 Docker Engine 直接集成的支持已被弃用且已经被删除。 大多数应用程序不直接依赖于托管容器的运行时。但是,仍然有大量的遥测和监控代理依赖 docker 来收集容器元数据、日志和指标。 本文汇总了一些信息和链接:信息用于阐述如何探查这些依赖,链接用于解释如何迁移这些代理去使用通用的工具或其他容器运行。

遥测和安全代理

在 Kubernetes 集群中,有几种不同的方式来运行遥测或安全代理。 一些代理在以 DaemonSet 的形式运行或直接在节点上运行时,直接依赖于 Docker Engine。

为什么有些遥测代理会与 Docker Engine 通信?

从历史上看,Kubernetes 是专门为与 Docker Engine 一起工作而编写的。 Kubernetes 负责网络和调度,依靠 Docker Engine 在节点上启动并运行容器(在 Pod 内)。一些与遥测相关的信息,例如 pod 名称, 只能从 Kubernetes 组件中获得。其他数据,例如容器指标,不是容器运行时的责任。 早期遥测代理需要查询容器运行时和 Kubernetes 以报告准确的信息。 随着时间的推移,Kubernetes 获得了支持多种运行时的能力, 现在支持任何兼容容器运行时接口的运行时。

一些代理和 Docker 工具紧密绑定。比如代理会用到

docker ps

或 docker top

这类命令来列出容器和进程,用

docker logs

订阅 Docker 的日志。

如果现有集群中的节点使用 Docker Engine,在你切换到其它容器运行时的时候,

这些命令将不再起作用。

识别依赖于 Docker Engine 的 DaemonSet

如果某 Pod 想调用运行在节点上的 dockerd,该 Pod 必须满足以下两个条件之一:

- 将包含 Docker 守护进程特权套接字的文件系统挂载为一个卷;或

- 直接以卷的形式挂载 Docker 守护进程特权套接字的特定路径。

举例来说:在 COS 镜像中,Docker 通过 /var/run/docker.sock 开放其 Unix 域套接字。

这意味着 Pod 的规约中需要包含 hostPath 卷以挂载 /var/run/docker.sock。

下面是一个 shell 示例脚本,用于查找包含直接映射 Docker 套接字的挂载点的 Pod。

你也可以删掉 grep '/var/run/docker.sock' 这一代码片段以查看其它挂载信息。

kubectl get pods --all-namespaces \

-o=jsonpath='{range .items[*]}{"\n"}{.metadata.namespace}{":\t"}{.metadata.name}{":\t"}{range .spec.volumes[*]}{.hostPath.path}{", "}{end}{end}' \

| sort \

| grep '/var/run/docker.sock'

检测节点代理对 Docker 的依赖性

在你的集群节点被定制、且在各个节点上均安装了额外的安全和遥测代理的场景下, 一定要和代理的供应商确认:该代理是否依赖于 Docker。

遥测和安全代理的供应商

本节旨在汇总有关可能依赖于容器运行时的各种遥测和安全代理的信息。

我们通过 谷歌文档 提供了为各类遥测和安全代理供应商准备的持续更新的迁移指导。 请与供应商联系,获取从 dockershim 迁移的最新说明。

从 dockershim 迁移

Aqua

无需更改:在运行时变更时可以无缝切换运行。

Datadog

如何迁移: Kubernetes 中对于 Docker 的弃用 名字中包含以下字符串的 Pod 可能访问 Docker Engine:

datadog-agentdatadogdd-agent

Dynatrace

如何迁移: 在 Dynatrace 上从 Docker-only 迁移到通用容器指标

Containerd 支持公告:在基于 containerd 的 Kubernetes 环境的获取容器的自动化全栈可见性 CRI-O 支持公告:在基于 CRI-O 的 Kubernetes 环境获取容器的自动化全栈可见性(测试版)

名字中包含以下字符串的 Pod 可能访问 Docker:

dynatrace-oneagent

Falco

如何迁移: 迁移 Falco 从 dockershim Falco 支持任何与 CRI 兼容的运行时(默认配置中使用 containerd);该文档解释了所有细节。

名字中包含以下字符串的 Pod 可能访问 Docker:

falco

Prisma Cloud Compute

在依赖于 CRI(非 Docker)的集群上安装 Prisma Cloud 时,查看 Prisma Cloud 提供的文档。

名字中包含以下字符串的 Pod 可能访问 Docker:

twistlock-defender-ds

SignalFx (Splunk)

SignalFx Smart Agent(已弃用)在 Kubernetes 集群上使用了多种不同的监视器,

包括 kubernetes-cluster,kubelet-stats/kubelet-metrics,docker-container-stats。

kubelet-stats 监视器此前已被供应商所弃用,现支持 kubelet-metrics。

docker-container-stats 监视器受 dockershim 移除的影响。

不要为 docker-container-stats 监视器使用 Docker Engine 之外的运行时。

如何从依赖 dockershim 的代理迁移:

- 从所配置的监视器中移除

docker-container-stats。 注意,若节点上已经安装了 Docker,在非 dockershim 环境中启用此监视器后会导致报告错误的指标; 如果节点未安装 Docker,则无法获得指标。 - 启用和配置

kubelet-metrics监视器。

说明:

收集的指标会发生变化。具体请查看你的告警规则和仪表盘。名字中包含以下字符串的 Pod 可能访问 Docker:

signalfx-agent

Yahoo Kubectl Flame

Flame 不支持 Docker 以外的容器运行时,具体可见 https://github.com/yahoo/kubectl-flame/issues/51

4 - 手动生成证书

在使用客户端证书认证的场景下,你可以通过 easyrsa、

openssl 或 cfssl

等工具以手工方式生成证书。

easyrsa

easyrsa 支持以手工方式为你的集群生成证书。

下载、解压、初始化打过补丁的

easyrsa3。curl -LO https://dl.k8s.io/easy-rsa/easy-rsa.tar.gz tar xzf easy-rsa.tar.gz cd easy-rsa-master/easyrsa3 ./easyrsa init-pki

生成新的证书颁发机构(CA)。参数

--batch用于设置自动模式; 参数--req-cn用于设置新的根证书的通用名称(CN)。./easyrsa --batch "--req-cn=${MASTER_IP}@`date +%s`" build-ca nopass

生成服务器证书和秘钥。

参数

--subject-alt-name设置 API 服务器的 IP 和 DNS 名称。MASTER_CLUSTER_IP用于 API 服务器和控制器管理器,通常取 CIDR 的第一个 IP, 由--service-cluster-ip-range的参数提供。 参数--days用于设置证书的过期时间。 下面的示例假定你的默认 DNS 域名为cluster.local。./easyrsa --subject-alt-name="IP:${MASTER_IP},"\ "IP:${MASTER_CLUSTER_IP},"\ "DNS:kubernetes,"\ "DNS:kubernetes.default,"\ "DNS:kubernetes.default.svc,"\ "DNS:kubernetes.default.svc.cluster,"\ "DNS:kubernetes.default.svc.cluster.local" \ --days=10000 \ build-server-full server nopass

- 拷贝文件

pki/ca.crt、pki/issued/server.crt和pki/private/server.key到你的目录中。

在 API 服务器的启动参数中添加以下参数:

--client-ca-file=/yourdirectory/ca.crt --tls-cert-file=/yourdirectory/server.crt --tls-private-key-file=/yourdirectory/server.key

openssl

openssl 支持以手工方式为你的集群生成证书。

生成一个 2048 位的 ca.key 文件

openssl genrsa -out ca.key 2048

在 ca.key 文件的基础上,生成 ca.crt 文件(用参数

-days设置证书有效期)openssl req -x509 -new -nodes -key ca.key -subj "/CN=${MASTER_IP}" -days 10000 -out ca.crt

生成一个 2048 位的 server.key 文件:

openssl genrsa -out server.key 2048

创建一个用于生成证书签名请求(CSR)的配置文件。 保存文件(例如:

csr.conf)前,记得用真实值替换掉尖括号中的值(例如:<MASTER_IP>)。 注意:MASTER_CLUSTER_IP就像前一小节所述,它的值是 API 服务器的服务集群 IP。 下面的例子假定你的默认 DNS 域名为cluster.local。[ req ] default_bits = 2048 prompt = no default_md = sha256 req_extensions = req_ext distinguished_name = dn [ dn ] C = <country> ST = <state> L = <city> O = <organization> OU = <organization unit> CN = <MASTER_IP> [ req_ext ] subjectAltName = @alt_names [ alt_names ] DNS.1 = kubernetes DNS.2 = kubernetes.default DNS.3 = kubernetes.default.svc DNS.4 = kubernetes.default.svc.cluster DNS.5 = kubernetes.default.svc.cluster.local IP.1 = <MASTER_IP> IP.2 = <MASTER_CLUSTER_IP> [ v3_ext ] authorityKeyIdentifier=keyid,issuer:always basicConstraints=CA:FALSE keyUsage=keyEncipherment,dataEncipherment extendedKeyUsage=serverAuth,clientAuth subjectAltName=@alt_names

基于上面的配置文件生成证书签名请求:

openssl req -new -key server.key -out server.csr -config csr.conf

基于 ca.key、ca.crt 和 server.csr 等三个文件生成服务端证书:

openssl x509 -req -in server.csr -CA ca.crt -CAkey ca.key \ -CAcreateserial -out server.crt -days 10000 \ -extensions v3_ext -extfile csr.conf -sha256

查看证书签名请求:

openssl req -noout -text -in ./server.csr

查看证书:

openssl x509 -noout -text -in ./server.crt

最后,为 API 服务器添加相同的启动参数。

cfssl

cfssl 是另一个用于生成证书的工具。

下载、解压并准备如下所示的命令行工具。

注意:你可能需要根据所用的硬件体系架构和 cfssl 版本调整示例命令。

curl -L https://github.com/cloudflare/cfssl/releases/download/v1.5.0/cfssl_1.5.0_linux_amd64 -o cfssl chmod +x cfssl curl -L https://github.com/cloudflare/cfssl/releases/download/v1.5.0/cfssljson_1.5.0_linux_amd64 -o cfssljson chmod +x cfssljson curl -L https://github.com/cloudflare/cfssl/releases/download/v1.5.0/cfssl-certinfo_1.5.0_linux_amd64 -o cfssl-certinfo chmod +x cfssl-certinfo

创建一个目录,用它保存所生成的构件和初始化 cfssl:

mkdir cert cd cert ../cfssl print-defaults config > config.json ../cfssl print-defaults csr > csr.json

创建一个 JSON 配置文件来生成 CA 文件,例如:

ca-config.json:{ "signing": { "default": { "expiry": "8760h" }, "profiles": { "kubernetes": { "usages": [ "signing", "key encipherment", "server auth", "client auth" ], "expiry": "8760h" } } } }

创建一个 JSON 配置文件,用于 CA 证书签名请求(CSR),例如:

ca-csr.json。 确认用你需要的值替换掉尖括号中的值。{ "CN": "kubernetes", "key": { "algo": "rsa", "size": 2048 }, "names":[{ "C": "<country>", "ST": "<state>", "L": "<city>", "O": "<organization>", "OU": "<organization unit>" }] }

生成 CA 秘钥文件(

ca-key.pem)和证书文件(ca.pem):../cfssl gencert -initca ca-csr.json | ../cfssljson -bare ca

创建一个 JSON 配置文件,用来为 API 服务器生成秘钥和证书,例如:

server-csr.json。 确认用你需要的值替换掉尖括号中的值。MASTER_CLUSTER_IP是为 API 服务器 指定的服务集群 IP,就像前面小节描述的那样。 以下示例假定你的默认 DNS 域名为cluster.local。{ "CN": "kubernetes", "hosts": [ "127.0.0.1", "<MASTER_IP>", "<MASTER_CLUSTER_IP>", "kubernetes", "kubernetes.default", "kubernetes.default.svc", "kubernetes.default.svc.cluster", "kubernetes.default.svc.cluster.local" ], "key": { "algo": "rsa", "size": 2048 }, "names": [{ "C": "<country>", "ST": "<state>", "L": "<city>", "O": "<organization>", "OU": "<organization unit>" }] }

为 API 服务器生成秘钥和证书,默认会分别存储为

server-key.pem和server.pem两个文件。../cfssl gencert -ca=ca.pem -ca-key=ca-key.pem \ --config=ca-config.json -profile=kubernetes \ server-csr.json | ../cfssljson -bare server

分发自签名的 CA 证书

客户端节点可能不认可自签名 CA 证书的有效性。 对于非生产环境,或者运行在公司防火墙后的环境,你可以分发自签名的 CA 证书到所有客户节点,并刷新本地列表以使证书生效。

在每一个客户节点,执行以下操作:

sudo cp ca.crt /usr/local/share/ca-certificates/kubernetes.crt

sudo update-ca-certificates

Updating certificates in /etc/ssl/certs...

1 added, 0 removed; done.

Running hooks in /etc/ca-certificates/update.d....

done.

证书 API

你可以通过 certificates.k8s.io API 提供 x509 证书,用来做身份验证,

如管理集群中的 TLS 认证文档所述。

5 - 管理内存、CPU 和 API 资源

5.1 - 为命名空间配置默认的内存请求和限制

本章介绍如何为命名空间配置默认的内存请求和限制。

一个 Kubernetes 集群可被划分为多个命名空间。 如果你在具有默认内存限制 的命名空间内尝试创建一个 Pod,并且这个 Pod 中的容器没有声明自己的内存资源限制, 那么控制面会为该容器设定默认的内存限制。

Kubernetes 还为某些情况指定了默认的内存请求,本章后面会进行介绍。

准备开始

你必须拥有一个 Kubernetes 的集群,且必须配置 kubectl 命令行工具让其与你的集群通信。 建议运行本教程的集群至少有两个节点,且这两个节点不能作为控制平面主机。 如果你还没有集群,你可以通过 Minikube 构建一个你自己的集群,或者你可以使用下面的 Kubernetes 练习环境之一:

在你的集群里你必须要有创建命名空间的权限。

你的集群中的每个节点必须至少有 2 GiB 的内存。

创建命名空间

创建一个命名空间,以便本练习中所建的资源与集群的其余资源相隔离。

kubectl create namespace default-mem-example

创建 LimitRange 和 Pod

以下为 LimitRange 的示例清单。 清单中声明了默认的内存请求和默认的内存限制。

apiVersion: v1

kind: LimitRange

metadata:

name: mem-limit-range

spec:

limits:

- default:

memory: 512Mi

defaultRequest:

memory: 256Mi

type: Container

在 default-mem-example 命名空间创建限制范围:

kubectl apply -f https://k8s.io/examples/admin/resource/memory-defaults.yaml --namespace=default-mem-example

现在如果你在 default-mem-example 命名空间中创建一个 Pod, 并且该 Pod 中所有容器都没有声明自己的内存请求和内存限制, 控制面 会将内存的默认请求值 256MiB 和默认限制值 512MiB 应用到 Pod 上。

以下为只包含一个容器的 Pod 的清单。该容器没有声明内存请求和限制。

apiVersion: v1

kind: Pod

metadata:

name: default-mem-demo

spec:

containers:

- name: default-mem-demo-ctr

image: nginx

创建 Pod:

kubectl apply -f https://k8s.io/examples/admin/resource/memory-defaults-pod.yaml --namespace=default-mem-example

查看 Pod 的详情:

kubectl get pod default-mem-demo --output=yaml --namespace=default-mem-example

输出内容显示该 Pod 的容器有 256 MiB 的内存请求和 512 MiB 的内存限制。 这些都是 LimitRange 设置的默认值。

containers:

- image: nginx

imagePullPolicy: Always

name: default-mem-demo-ctr

resources:

limits:

memory: 512Mi

requests:

memory: 256Mi

删除你的 Pod:

kubectl delete pod default-mem-demo --namespace=default-mem-example

声明容器的限制而不声明它的请求会怎么样?

以下为只包含一个容器的 Pod 的清单。该容器声明了内存限制,而没有声明内存请求。

apiVersion: v1

kind: Pod

metadata:

name: default-mem-demo-2

spec:

containers:

- name: default-mem-demo-2-ctr

image: nginx

resources:

limits:

memory: "1Gi"

创建 Pod:

kubectl apply -f https://k8s.io/examples/admin/resource/memory-defaults-pod-2.yaml --namespace=default-mem-example

查看 Pod 的详情:

kubectl get pod default-mem-demo-2 --output=yaml --namespace=default-mem-example

输出结果显示容器的内存请求被设置为它的内存限制相同的值。注意该容器没有被指定默认的内存请求值 256MiB。

resources:

limits:

memory: 1Gi

requests:

memory: 1Gi

声明容器的内存请求而不声明内存限制会怎么样?

以下为只包含一个容器的 Pod 的清单。该容器声明了内存请求,但没有内存限制:

apiVersion: v1

kind: Pod

metadata:

name: default-mem-demo-3

spec:

containers:

- name: default-mem-demo-3-ctr

image: nginx

resources:

requests:

memory: "128Mi"

创建 Pod:

kubectl apply -f https://k8s.io/examples/admin/resource/memory-defaults-pod-3.yaml --namespace=default-mem-example

查看 Pod 声明:

kubectl get pod default-mem-demo-3 --output=yaml --namespace=default-mem-example

输出结果显示所创建的 Pod 中,容器的内存请求为 Pod 清单中声明的值。 然而同一容器的内存限制被设置为 512MiB,此值是该命名空间的默认内存限制值。

resources:

limits:

memory: 512Mi

requests:

memory: 128Mi

说明:

LimitRange 不会检查它应用的默认值的一致性。 这意味着 LimitRange 设置的 limit 的默认值可能小于客户端提交给

API 服务器的声明中为容器指定的 request 值。如果发生这种情况,最终会导致 Pod 无法调度。更多信息,

请参阅资源限制的 limit 和 request。

设置默认内存限制和请求的动机

如果你的命名空间设置了内存 资源配额, 那么为内存限制设置一个默认值会很有帮助。 以下是内存资源配额对命名空间的施加的三条限制:

命名空间中运行的每个 Pod 中的容器都必须有内存限制。 (如果为 Pod 中的每个容器声明了内存限制, Kubernetes 可以通过将其容器的内存限制相加推断出 Pod 级别的内存限制)。

内存限制用来在 Pod 被调度到的节点上执行资源预留。 预留给命名空间中所有 Pod 使用的内存总量不能超过规定的限制。

命名空间中所有 Pod 实际使用的内存总量也不能超过规定的限制。

当你添加 LimitRange 时:

如果该命名空间中的任何 Pod 的容器未指定内存限制, 控制面将默认内存限制应用于该容器, 这样 Pod 可以在受到内存 ResourceQuota 限制的命名空间中运行。

清理

删除你的命名空间:

kubectl delete namespace default-mem-example

接下来

集群管理员参考

应用开发者参考

5.2 - 为命名空间配置默认的 CPU 请求和限制

本章介绍如何为命名空间配置默认的 CPU 请求和限制。

一个 Kubernetes 集群可被划分为多个命名空间。 如果你在具有默认 CPU 限制 的命名空间内创建一个 Pod,并且这个 Pod 中任何容器都没有声明自己的 CPU 限制, 那么控制面会为容器设定默认的 CPU 限制。

Kubernetes 在一些特定情况还可以设置默认的 CPU 请求,本文后续章节将会对其进行解释。

准备开始

你必须拥有一个 Kubernetes 的集群,且必须配置 kubectl 命令行工具让其与你的集群通信。 建议运行本教程的集群至少有两个节点,且这两个节点不能作为控制平面主机。 如果你还没有集群,你可以通过 Minikube 构建一个你自己的集群,或者你可以使用下面的 Kubernetes 练习环境之一:

在你的集群里你必须要有创建命名空间的权限。

如果你还不熟悉 Kubernetes 中 1.0 CPU 的含义, 请阅读 CPU 的含义。

创建命名空间

创建一个命名空间,以便本练习中创建的资源和集群的其余部分相隔离。

kubectl create namespace default-cpu-example

创建 LimitRange 和 Pod

以下为 LimitRange 的示例清单。 清单中声明了默认 CPU 请求和默认 CPU 限制。

apiVersion: v1

kind: LimitRange

metadata:

name: cpu-limit-range

spec:

limits:

- default:

cpu: 1

defaultRequest:

cpu: 0.5

type: Container

在命名空间 default-cpu-example 中创建 LimitRange 对象:

kubectl apply -f https://k8s.io/examples/admin/resource/cpu-defaults.yaml --namespace=default-cpu-example

现在如果你在 default-cpu-example 命名空间中创建一个 Pod, 并且该 Pod 中所有容器都没有声明自己的 CPU 请求和 CPU 限制, 控制面会将 CPU 的默认请求值 0.5 和默认限制值 1 应用到 Pod 上。

以下为只包含一个容器的 Pod 的清单。该容器没有声明 CPU 请求和限制。

apiVersion: v1

kind: Pod

metadata:

name: default-cpu-demo

spec:

containers:

- name: default-cpu-demo-ctr

image: nginx

创建 Pod。

kubectl apply -f https://k8s.io/examples/admin/resource/cpu-defaults-pod.yaml --namespace=default-cpu-example

查看该 Pod 的声明:

kubectl get pod default-cpu-demo --output=yaml --namespace=default-cpu-example

输出显示该 Pod 的唯一的容器有 500m cpu 的 CPU 请求和 1 cpu 的 CPU 限制。

这些是 LimitRange 声明的默认值。

containers:

- image: nginx

imagePullPolicy: Always

name: default-cpu-demo-ctr

resources:

limits:

cpu: "1"

requests:

cpu: 500m

你只声明容器的限制,而不声明请求会怎么样?

以下为只包含一个容器的 Pod 的清单。该容器声明了 CPU 限制,而没有声明 CPU 请求。

apiVersion: v1

kind: Pod

metadata:

name: default-cpu-demo-2

spec:

containers:

- name: default-cpu-demo-2-ctr

image: nginx

resources:

limits:

cpu: "1"

创建 Pod:

kubectl apply -f https://k8s.io/examples/admin/resource/cpu-defaults-pod-2.yaml --namespace=default-cpu-example

查看你所创建的 Pod 的规约:

kubectl get pod default-cpu-demo-2 --output=yaml --namespace=default-cpu-example

输出显示该容器的 CPU 请求和 CPU 限制设置相同。注意该容器没有被指定默认的 CPU 请求值 0.5 cpu:

resources:

limits:

cpu: "1"

requests:

cpu: "1"

你只声明容器的请求,而不声明它的限制会怎么样?

这里给出了包含一个容器的 Pod 的示例清单。该容器声明了 CPU 请求,而没有声明 CPU 限制。

apiVersion: v1

kind: Pod